Text

¿Qué novedades presenta Octoparse 8.4.2?

Usuarios de Octoparse, ¿cómo va su viaje de raspado web con el software? En este mes, se lanzará la versión 8.4.2 del producto. ¿Quieren saber qué novedades presenta la próxima versión más reciente? ¡Sigue leyendo!

1. Integración de Zapier

En la versión 8.4.2, puedes exportar automáticamente tus datos en la nube con Zapier a Google Drive, Google Sheet y más software.

Encuentra más información aquí y pruébalo.

2. Raspar mientras se desplaza dentro de una sección determinada

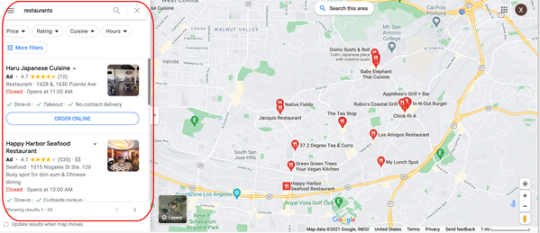

Tomamos Google Maps como ejemplo. Puedes ingresar a la página web y raspar los resultados de la búsqueda solo usando esta función en la versión 8.4.2. La función se puede implementar configurando el Xpath.

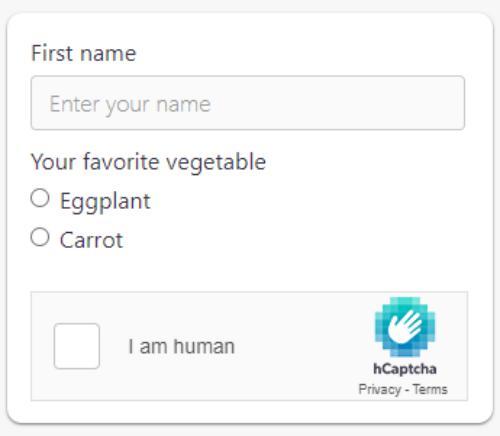

3. Personalizar el agente de usuario

Puedes cambiar la cadena del agente de usuario y el nombre del agente de usuario en los navegadores cuando utilices la versión 8.4.2 para extraer datos.

Para entender cómo funcionan los agentes de usuario, este artículo puede ser útil: Cómo cambiar los agentes de usuario en Chrome, Edge, Safari y Firefox

4. Realizar una copia de seguridad de los datos locales en la nube

Esta función solía estar disponible sólo para los usuarios empresariales. En la nueva versión 8.4.2, está abierta también a los usuarios con planes profesionales.

5. Formateo de la marca de tiempo

Esta función está diseñada principalmente para raspar plataformas de redes sociales. La conversión de la marca de tiempo de las publicaciones a la fecha está disponible en la versión 8.4.2.

6. Otras actualizaciones en las funciones existentes y la interfaz de usuario (UI)

Con las actualizaciones, la versión 8.4.2 será más estable y conveniente de usar en comparación con las versiones anteriores.

¡Qué más! El sistema de Octoparse 8.4.2 ahora está disponible en español, puedes cambiar el idioma según tu necesidad.

No dudes en contactarnos en [email protected] o enviar un ticket aquí si tienes alguna pregunta. El equipo de atención al cliente estará listo para ayudarte como siempre. ¡Te deseo un raspado aún más feliz!

#webscraping webscrapingtools webscrapingespañol datamining herramientas de web scraping#webscraping webscrapingtools webscrapingespañol datamining

0 notes

Text

Tripadvisor Scraper: los principales destinos abiertos a los ciudadanos bajo Covid

Las reglas de viaje están cambiando actualmente con la curva de casos de Covid. Con la variante Delta de la enfermedad, los casos están aumentando. Mientras estoy compilando este artículo, la UE está considerando volver a imponer restricciones de viaje a los visitantes estadounidenses.

De todos modos, he creado mi raspador de Tripadvisor con Octoparse y he analizado la información de los destinos que están abiertos a los ciudadanos estadounidenses. Prepárate siempre para un viaje refrescante.

Nota: si te diriges a estos países, es posible que desees comprobar si es necesaria la vacunación o la cuarentena.

Por cierto, el web scraping es definitivamente la mejor manera de ayudarnos a extraer los datos web y así poder examinarlos y sacar el máximo provecho de ellos. Mostraré cómo me ayuda a obtener los datos de viaje.

Web Scraping de Datos de Viajes

¿Tienes alguna idea sobre el big data en el turismo?

Los empresarios de la industria de viajes están rastreando todo tipo de datos, por ejemplo, datos comerciales de agentes de viajes y datos de comportamiento de los visitantes en todas las plataformas relacionadas con viajes. Es posible que conozcan sus hábitos de viaje mejor que tú. Toda la industria está aprovechando el big data para lanzar el producto adecuado y encontrar a las personas adecuadas para pagar por sus servicios.

El web scraping es la tecnología que lo hace posible.

Bueno, como viajero, quiero recopilar datos de viajes en la web para satisfacer mis necesidades: encontrar destinos entre los más atractivos y obtener las guías de Tripadvisor para mi referencia.

Que voy a hacer

En primer lugar, necesito una lista de países para investigar.

En segundo lugar, utilizaré una herramienta de raspado web, Octoparse, para crear un raspador de Tripadvisor y rastrear los datos de viajes de estos países.

¡Finalmente, voy a empacar mi equipaje y dirigirme al destino que más se ajuste a mis gustos de viaje!

¿A Dónde Puede Ir un Estadounidense?

Entonces, ¿a dónde puede viajar un estadounidense ahora?

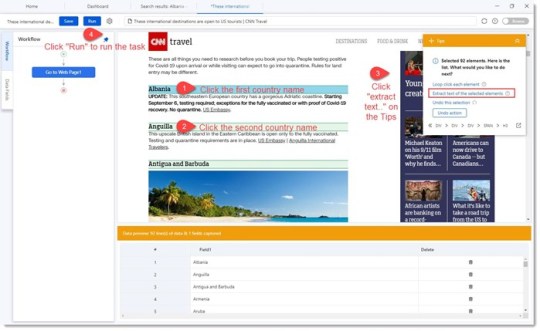

Este artículo de CNN enumeró los destinos que están abiertos a los EE. UU. (La lista podría actualizarse de vez en cuando).

Lo que quería hacer era extraer todos los nombres de países de esta página web en una hoja de cálculo para poder pegarlos en Octoparse y obtener datos más específicos de Tripadvisor.

Octoparse: cómo obtener información de la lista en una página web en Excel

Octoparse puede obtener fácilmente información de la lista en una página web en Excel o CSV.

Esto es extremadamente útil cuando deseas obtener una lista de URL o una lista de datos, que deseas pegar y buscar en otra plataforma, o importar a un software de análisis de datos para tu análisis.

Ahora que tengo la lista de destinos de texto, voy a crear un raspador de TripAdvisor para obtener datos específicos sobre estos lugares.

Crear un Raspador de TripAdvisor

Los datos que voy a rastrear desde Tripadvisor:

Quiero comprobar la popularidad de los viajes en estos países. Consultaré con el número de reseñas sobre el país en Tripadvisor. (Mi hipótesis: más visitas, más reseñas).

Tengo mi tema de viaje. Soy un amante de la naturaleza interesado en eventos al aire libre y turismo en la naturaleza. Obtendré la información de la etiqueta de estos destinos para poder filtrar y ubicar el lugar perfecto donde pueda perseguir el viento, jugar en la playa o apreciar la grandeza de un pico.

Guardaré la URL de las guías de viaje en Tripadvisor para una mayor planificación de viajes. (¡Gracias contribuidores!)

Generar URL por Lotes con Nombres de Países

¿Dónde conseguir estos datos? Esta es una página de muestra: Tripadvisor Nepal.

Con la lista de nombres de países que he extraído en el paso anterior, puedo generar por lotes todas las páginas de países de Tripadvisor con Octoparse.

Ejemplos de páginas generadas:

Tripadvisor Ireland

Tripadvisor Israel

Tripadvisor Italy

Tripadvisor Kenya

Ahora que tengo una lista de páginas web de destino para extraer datos, voy a crear un raspador que comprenda qué datos estoy solicitando y los tomará por mí.

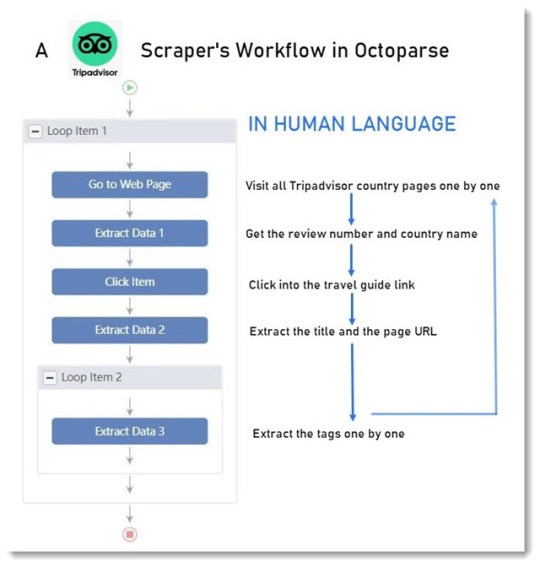

Crear un Raspador: Dime Lo Que Quieres

Construir un raspador es como compilar una carta para conversar con la computadora: dígale dónde y cómo obtener los datos que deseas. Solo que no hablas en lenguaje humano, sino en lenguajes de programación.

Y una herramienta de raspado web es como un traductor. Te permite compilar la carta utilizando lenguaje humano, gracias al flujo de trabajo comprensible y la interfaz de usuario intuitiva.

Si esto sigue siendo abstracto, no importa. Vamos a sumergirnos en algunas preguntas.

¿Qué puede hacer un raspador?

Visitar - abrir una página web.

Hacer clic - hacer clic en un enlace de la página web.

Extraer - rastrear datos como textos, URL, números, etc.

¿Qué datos necesito?

El nombre del país, el número de reseñas.

El enlace de la guía de viaje, el título de la guía y sus etiquetas.

¿Cómo actuará un raspador para obtener los datos que necesito?

Visitará la pagina web

Extraerá el nombre del país y el número de reseñas en la página

Buscará el enlace de la guía de viaje y hará clic en él

Extraerá la URL de la página, el título de la guía, las etiquetas de la guía

Regresará y visitará la siguiente página web

Repetirá los pasos anteriores (en Octoparse, esto se puede hacer con un bucle)

Bingo. Ese es el flujo de trabajo que construí aquí.

¿Cómo construir el flujo de trabajo?

Pan comido.

Ingresar las URL en la barra de búsqueda y comenzar una tarea de construcción. (Díle al raspador qué páginas web visitar)

Hacer clic en los datos que deseas en el navegador integrado. (Ayuda al raspador a localizar los datos)

Seleccionar las acciones que deseas que realice el raspador en el Panel de sugerencias. (Díle al raspador que visite, haga clic o extraiga datos)

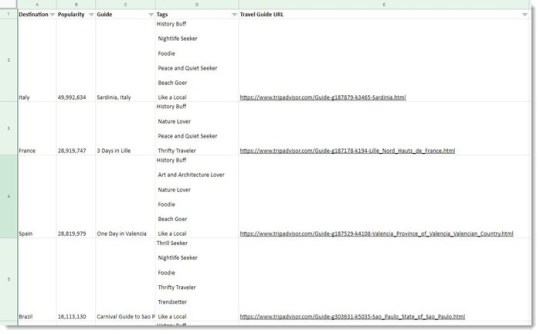

¿Cómo se ven los datos?

Es una tabla larga ya que hay más de 100 líneas de datos en mi lista. La siguiente captura de pantalla ha hecho todo lo posible.

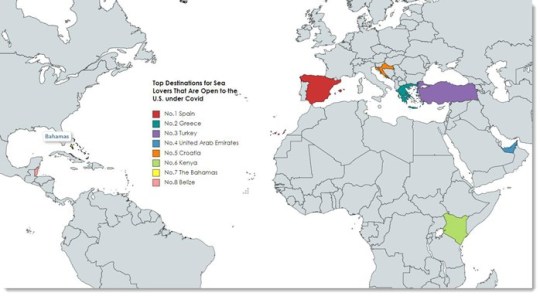

Lo sé, los datos sin procesar no son bonitos antes de cualquier visualización, pero son útiles. Con estos datos, encontré la mejor opción para un amante de la comida y la playa - ¡España!

Diviértete con Octoparse. Cualquier problema al usarlo, no dude en contactarnos en [email protected].

>> Empezar a raspar mis datos

>> Herramientas de visualización para mostrar (o mostrar) mis datos

0 notes

Text

9 herramientas de Web Scraping Gratuitas que No Te Puedes Perder en 2021

¿Cuánto sabes sobre web scraping? No te preocupe, este artículo te informará sobre los conceptos básicos del web scraping, cómo acceder a una herramienta de web scraping para obtener una herramienta que se adapte perfectamente a tus necesidades y por último, pero no por ello menos importante, te presentará una lista de herramientas de web scraping para tu referencia.

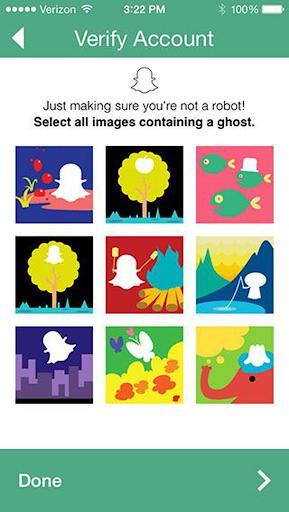

Web Scraping Y Como Se Usa

El web scraping es una forma de recopilar datos de páginas web con un bot de scraping, por lo que todo el proceso se realiza de forma automatizada. La técnica permite a las personas obtener datos web a gran escala rápidamente. Mientras tanto, instrumentos como Regex (Expresión Regular) permiten la limpieza de datos durante el proceso de raspado, lo que significa que las personas pueden obtener datos limpios bien estructurados en un solo lugar.

¿Cómo funciona el web scraping?

En primer lugar, un robot de raspado web simula el acto de navegación humana por el sitio web. Con la URL de destino ingresada, envía una solicitud al servidor y obtiene información en el archivo HTML.

A continuación, con el código fuente HTML a mano, el bot puede llegar al nodo donde se encuentran los datos de destino y analizar los datos como se ordena en el código de raspado.

Por último, (según cómo esté configurado el bot de raspado) el grupo de datos raspados se limpiará, se colocará en una estructura y estará listo para descargar o transferir a tu base de datos.

Cómo Elegir Una Herramienta De Web Scraping

Hay formas de acceder a los datos web. A pesar de que lo has reducido a una herramienta de raspado web, las herramientas que aparecieron en los resultados de búsqueda con todas las características confusas aún pueden hacer que una decisión sea difícil de alcanzar.

Hay algunas dimensiones que puedes tener en cuenta antes de elegir una herramienta de raspado web:

Dispositivo: si eres un usuario de Mac o Linux, debes asegurarte de que la herramienta sea compatible con tu sistema.

Servicio en la nube: el servicio en la nube es importante si deseas acceder a tus datos en todos los dispositivos en cualquier momento.

Integración: ¿cómo utilizarías los datos más adelante? Las opciones de integración permiten una mejor automatización de todo el proceso de manejo de datos.

Formación: si no sobresales en la programación, es mejor asegurarte de que haya guías y soporte para ayudarte a lo largo del viaje de recolección de datos.

Precio: sí, el costo de una herramienta siempre se debe tener en cuenta y varía mucho entre los diferentes proveedores.

Ahora es posible que desees saber qué herramientas de raspado web puedes elegir:

Tres Tipos De Herramientas De Raspado Web

Cliente Web Scraper

Complementos / Extensión de Web Scraping

Aplicación de raspado basada en web

Hay muchas herramientas gratuitas de raspado web. Sin embargo, no todo el software de web scraping es para no programadores. Las siguientes listas son las mejores herramientas de raspado web sin habilidades de codificación a un bajo costo. El software gratuito que se enumera a continuación es fácil de adquirir y satisfaría la mayoría de las necesidades de raspado con una cantidad razonable de requisitos de datos.

Software de Web Scraping de Cliente

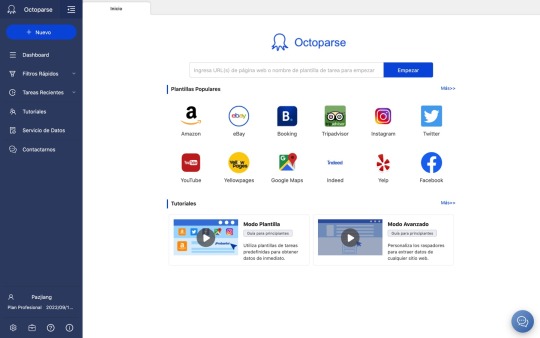

1. Octoparse

Octoparse es una herramienta robusta de web scraping que también proporciona un servicio de web scraping para empresarios y empresas.

Dispositivo: como se puede instalar tanto en Windows como en Mac OS, los usuarios pueden extraer datos con dispositivos Apple.

Datos: extracción de datos web para redes sociales, comercio electrónico, marketing, listados de bienes raíces, etc.

Función:

- manejar sitios web estáticos y dinámicos con AJAX, JavaScript, cookies, etc.

- extraer datos de un sitio web complejo que requiere inicio de sesión y paginación.

- tratar la información que no se muestra en los sitios web analizando el código fuente.

Casos de uso: como resultado, puedes lograr un seguimiento automático de inventarios, monitoreo de precios y generación de leads al alcance de tu mano.

Octoparse ofrece diferentes opciones para usuarios con diferentes niveles de habilidades de codificación.

El Modo de Plantilla de Tareas Un usuario con habilidades básicas de datos scraping puede usar esta nueva característica que convirte páginas web en algunos datos estructurados al instante. El modo de plantilla de tareas solo toma alrededor de 6.5 segundos para desplegar los datos detrás de una página y te permite descargar los datos a Excel.

El modo avanzado tiene más flexibilidad comparando los otros dos modos. Esto permite a los usuarios configurar y editar el flujo de trabajo con más opciones. El modo avanzado se usa para scrape sitios web más complejos con una gran cantidad de datos.

La nueva función de detección automática te permite crear un rastreador con un solo clic. Si no estás satisfecho con los campos de datos generados automáticamente, siempre puedes personalizar la tarea de raspado para permitirte raspar los datos por ti.

Los servicios en la nube permiten una gran extracción de datos en un corto período de tiempo, ya que varios servidores en la nube se ejecutan simultáneamente para una tarea. Además de eso, el servicio en la nube te permitirá almacenar y recuperar los datos en cualquier momento.

2.

ParseHub

Parsehub es un raspador web que recopila datos de sitios web que utilizan tecnologías AJAX, JavaScript, cookies, etc. Parsehub aprovecha la tecnología de aprendizaje automático que puede leer, analizar y transformar documentos web en datos relevantes.

Dispositivo: la aplicación de escritorio de Parsehub es compatible con sistemas como Windows, Mac OS X y Linux, o puedes usar la extensión del navegador para lograr un raspado instantáneo.

Precio: no es completamente gratuito, pero aún puedes configurar hasta cinco tareas de raspado de forma gratuita. El plan de suscripción paga te permite configurar al menos 20 proyectos privados.

Tutorial: hay muchos tutoriales en Parsehub y puedes obtener más información en la página de inicio.

3.

Import.io

Import.io es un software de integración de datos web SaaS. Proporciona un entorno visual para que los usuarios finales diseñen y personalicen los flujos de trabajo para recopilar datos. Cubre todo el ciclo de vida de la extracción web, desde la extracción de datos hasta el análisis dentro de una plataforma. Y también puedes integrarte fácilmente en otros sistemas.

Función: raspado de datos a gran escala, captura de fotos y archivos PDF en un formato factible

Integración: integración con herramientas de análisis de datos

Precios: el precio del servicio solo se presenta mediante consulta caso por caso

Complementos / Extensión de Web Scraping1.

Data Scraper (Chrome)

Data Scraper puede extraer datos de tablas y datos de tipo de listado de una sola página web. Su plan gratuito debería satisfacer el scraping más simple con una pequeña cantidad de datos. El plan pagado tiene más funciones, como API y muchos servidores proxy IP anónimos. Puede recuperar un gran volumen de datos en tiempo real más rápido. Puede scrapear hasta 500 páginas por mes, si necesitas scrapear más páginas, necesitas actualizar a un plan pago.

2.

Web scraper

El raspador web tiene una extensión de Chrome y una extensión de nube.

Para la versión de extensión de Chrome, puedes crear un mapa del sitio (plan) sobre cómo se debe navegar por un sitio web y qué datos deben rasparse.

La extensión de la nube puede raspar un gran volumen de datos y ejecutar múltiples tareas de raspado al mismo tiempo. Puedes exportar los datos en CSV o almacenarlos en Couch DB.

3.

Scraper (Chrome)

El Scraper es otro raspador web de pantalla fácil de usar que puede extraer fácilmente datos de una tabla en línea y subir el resultado a Google Docs.

Simplemente selecciona un texto en una tabla o lista, haz clic con el botón derecho en el texto seleccionado y elige "Scrape similar" en el menú del navegador. Luego obtendrás los datos y extraerás otro contenido agregando nuevas columnas usando XPath o JQuery. Esta herramienta está destinada a usuarios de nivel intermedio a avanzado que saben cómo escribir XPath.

4.

Outwit hub(Firefox)

Outwit hub es una extensión de Firefox y se puede descargar fácilmente desde la tienda de complementos de Firefox. Una vez instalado y activado, puedes extraer el contenido de los sitios web al instante.

Función: tiene características sobresalientes de "Raspado rápido", que rápidamente extrae datos de una lista de URL que ingresas. La extracción de datos de sitios que usan Outwit Hub no requiere habilidades de programación.

Formación: El proceso de raspado es bastante fácil de aprender. Los usuarios pueden consultar sus guías para comenzar con el web scraping con la herramienta.

Outwit Hub also offers services of tailor-making scrapers.Outwit Hub también ofrece servicios de raspadores a medida.

Aplicación de raspado basada en web1.

Dexi.io (anteriormente conocido como raspado de nubes)

Dexi.io está destinado a usuarios avanzados que tienen habilidades de programación competentes. Tiene tres tipos de robots para que puedas crear una tarea de raspado - Extractor, Crawler, y Pipes. Proporciona varias herramientas que te permiten extraer los datos con mayor precisión. Con su característica moderna, podrás abordar los detalles en cualquier sitio web. Sin conocimientos de programación, es posible que debas tomarte un tiempo para acostumbrarte antes de crear un robot de raspado web. Consulta su página de inicio para obtener más información sobre la base de conocimientos.

El software gratuito proporciona servidores proxy web anónimos para raspar la web. Los datos extraídos se alojarán en los servidores de Dexi.io durante dos semanas antes de ser archivados, o puedes exportar directamente los datos extraídos a archivos JSON o CSV. Ofrece servicios de pago para satisfacer tus necesidades de obtención de datos en tiempo real.

2.

Webhose.io

Webhose.io te permite obtener datos en tiempo real de raspar fuentes en línea de todo el mundo en varios formatos limpios. Incluso puedes recopilar información en sitios web que no aparecen en los motores de búsqueda. Este raspador web te permite raspar datos en muchos idiomas diferentes utilizando múltiples filtros y exportar datos raspados en formatos XML, JSON y RSS.

El software gratuito ofrece un plan de suscripción gratuito para que puedas realizar 1000 solicitudes HTTP por mes y planes de suscripción pagados para realizar más solicitudes HTTP por mes para satisfacer tus necesidades de raspado web.

0 notes

Text

¿Para qué se usa el screen scraping y cómo construir uno?

Screen Scraping

Por lo general, se refiere a analizar el HTML en el contenido web generado con programas diseñados para extraer patrones específicos de contenido.

El raspado de pantalla es el método de recopilar datos de visualización de pantalla de una aplicación y traducirlos para que otra aplicación pueda mostrarlos. Normalmente, esto se hace para capturar datos de una aplicación heredada con el fin de mostrarlos utilizando una interfaz de usuario más moderna.

A veces se confunde con el raspado de contenido, que es el uso de medios manuales o automáticos para extraer contenido de un sitio web sin la aprobación del propietario del sitio web. Muy a menudo, el raspado de pantalla se refiere a un cliente web que analiza las páginas HTML del sitio web de destino para extraer datos formateados.

Screen Scrapers

Un raspador de pantalla es un programa de computadora que utiliza una técnica de raspado de pantalla para traducir entre programas de aplicación heredados (escritos para comunicarse con dispositivos de entrada / salida e interfaces de usuario ahora generalmente obsoletos) y nuevas interfaces de usuario para que la lógica y los datos asociados con los programas heredados puede seguir utilizándose.

En los primeros días de las PC, los raspadores de pantalla emulaban un terminal (por ejemplo, IBM 3270) y pretendían ser un usuario para extraer y actualizar información de forma interactiva en el mainframe. En tiempos más recientes, el concepto se aplica a cualquier aplicación que proporcione una interfaz a través de páginas web.

¿Para qué se usa Screen Scrapers?

Los raspadores de pantalla se han aplicado en una amplia cantidad de campos para una variedad de casos de uso. Algunos usos potenciales incluyen:

aplicaciones bancarias y transacciones financieras

guardar datos significativos para su uso posterior

para realizar acciones que un usuario haría en un sitio web

para traducir datos de una aplicación heredada a una aplicación moderna

para agregadores de datos, como sitios web de comparación de precios

para rastrear perfiles de usuario para ver actividades en línea; y

para obtener datos

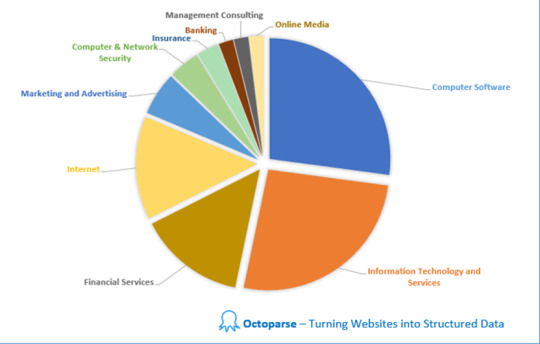

Top 10 industrias que utilizan screen scraping

Uno de los casos de uso más importantes ha sido el de la banca. Es posible que los prestamistas deseen utilizar el raspado de pantalla para recopilar los datos financieros de un cliente. Las aplicaciones basadas en finanzas pueden usar el rastreo de pantalla para acceder a múltiples cuentas de un usuario, agregando toda la información en un solo lugar. Sin embargo, los usuarios deberían confiar explícitamente en la aplicación, ya que confían en esa organización con sus cuentas, datos de clientes y contraseñas. El raspado de pantalla también se puede utilizar para aplicaciones de proveedores de hipotecas.

Es posible que una organización también desee utilizar el raspado de pantalla para traducir entre programas de aplicaciones heredados y nuevas interfaces de usuario (UI) para que la lógica y los datos asociados con los programas heredados puedan seguir utilizándose. Esta opción rara vez se usa y solo se ve como una opción cuando otros métodos no son prácticos.

Raspado de datos sin codificación

Si deseas probar la extracción, Octoparse te permite trabajar con datos dinámicos no estructurados con solo hacer clic en puntos de datos individuales y generará automáticamente un código eficiente para extraer datos. No se requiere codificación en este proceso. Además, te permite exportar datos a formatos de tu elección como Excel, JSON, CSV, TXT, HTML, incluso directamente a tu base de datos a través de API.

0 notes

Text

Un Marco Para Informes de Análisis de Datos

Cuando se resume un proyecto, es inevitable formar un informe de análisis de datos relativamente completo.

El informe también requiere múltiples situaciones. De acuerdo con la aplicación, se puede dividir en muchos tipos: algunos necesitan informar al correo electrónico, otros necesitan dar una explicación al equipo del proyecto y otros deben mostrarse e informarse directamente. Según el tipo de proyecto, también se puede dividir en varios tipos: evaluación del efecto del lanzamiento de un nuevo proyecto, resultados de la prueba AB, resumen de datos diarios, análisis de datos de actividad, etc.

Ya sea el texto o la diapositiva, las ideas centrales del informe de análisis de datos son todas iguales.

Tabla de Contenido

1. Debes tener una "historia"

2. Un marco para los informes de análisis de datos

3. Conclusión

1. Debes tener una "historia"

Mi propia idea es que los gerentes de producto deben aprender más conocimientos en campos relacionados, como aprender algunas especificaciones básicas de diseño, principios de interacción, conocimiento de marketing, conocimiento de psicología, conocimiento de algoritmos, etc. Además de una ayuda obvia para el trabajo, también puede ayudarlo a expandir su pensamiento. De hecho, para hacer un buen informe, debe aprender de agencias consultoras o instituciones de inversión.

El núcleo de un informe no contiene mucho contenido para que la audiencia o los lectores dediquen tiempo a comprenderlo, el núcleo es contar una historia simple. Antes de que las instituciones de consultoría e inversión hagan plan de negocios, se tomarán un tiempo para aclarar el storyline. De hecho, todo tipo de informes deberían ser así, primero aclara la historia que quieres contar.

2. Un marco para los informes de análisis de datos

Aquí hay un marco de informe que personalmente me gusta, que puede necesitar ser ajustado para diferentes escenarios de informes (como eliminar algunos pasos o agregar algunos detalles):

Antecedentes del proyecto: describir brevemente los antecedentes relevantes del proyecto, por qué se realiza y cuál es su propósito.

Avance del proyecto: resumir el avance general del proyecto y la situación actual.

Explicación del término: ¿Cuál es la definición de indicadores clave y por qué?

Método de adquisición de datos: cómo muestrear y cómo adquirir ¿Cuáles son los problemas?

Descripción general de los datos: tendencias de indicadores importantes, cambios y explicación de la causa del importante punto de inflexión.

División de datos: dividir diferentes dimensiones según la necesidad para complementar los detalles.

Resumen: resumir las principales conclusiones del análisis de datos anterior como una descripción general.

Mejora de seguimiento: analizar los problemas existentes y dar soluciones para mejorar y prevenir.

Agradecimiento & Adjunto: datos detallados.

Antecedentes del proyecto & Avance del proyecto

Antecedentes del proyecto, es necesario describir brevemente los antecedentes relevantes del proyecto, por qué se realiza y cuál es el propósito. Avance del proyecto,hay que resumir el avance general del proyecto y la situación actual. De hecho, no hay mucho que decir sobre estos dos puntos. Si el objetivo es un miembro del proyecto, puedes escribirlo de forma más sencilla. Si el objetivo es alguien que no comprende el proyecto, debes escribir más, pero aún así intentar uses las palabras más simples para explicar a los demás.

Explicación del término & Método de adquisición de datos

Explicación del término:¿Cuál es la definición de indicadores clave y por qué? Muchas personas pasan por alto este punto. De verdad, muchos malentendidos de los datos se deben a la falta de una definición unificada de los indicadores. Por ejemplo, la tasa de clics puede ser el número de clics / el número de vistas, o el número de clics de personas / el número de visitas de personas. El número de personas se puede deduplicar según las visitas o se pueden deduplicar según el día. Si no hay una explicación clara, diferentes personas entienden de manera diferente y la legibilidad de todos los datos se reducirá en gran medida.

Método de adquisición de datos:cómo muestrear y cómo adquirir ¿Cuáles son los problemas? Los datos originales a menudo tienen algunas deficiencias. Los datos deben limpiarse para eliminar el ruido y también se requieren algunas suposiciones para completar los datos. El método de limpieza y finalización de datos debe ser explicado y reconocido por el objeto de informe, de modo que la otra parte tenga una estimación del nivel de confianza.

Descripción general de los datos & División de datos

La descripción general de los datos debe tener tendencias de indicadores importantes, cambios y explicación de la causa del importante punto de inflexión.

La división de datos debe dividir diferentes dimensiones según la necesidad para complementar los detalles.

Este es básicamente el método de análisis de datos mencionado anteriormente. Si necesitas que la otra parte conozca la comparación o la tendencia, uses el gráfico, si necesitas que la otra parte conozca los datos específicos, uses la tabla. La tabla debe identificar claramente los números que deben enfatizarse. Los puntos a tener en cuenta son: los indicadores básicos deben ser pocos pero críticos, y los indicadores divididos deben ser significativos y detallados. Al mismo tiempo, si se trata de una diapositiva, basta con explicar una conclusión o explicar claramente una tendencia en cada página. La conclusión clave debe expresarse claramente en una oración.

Resumen & Mejora de seguimiento

Resumen,debes resumir las principales conclusiones del análisis de datos anterior como una descripción general.

Mejora de seguimiento,necesitas realizar una explicación direccional para iteraciones posteriores y medidas de mejora en base a las conclusiones y problemas del análisis de datos. Esta parte suele ser el propósito fundamental del análisis.

Agradecimiento & Adjunto

Los agradecimientos son el agradecimiento al equipo del proyecto y a los departamentos de asistencia relacionados, para el equipo del proyecto y los departamentos de asistencia relevantes, también esperan que su trabajo o cooperación activa pueda ver resultados de datos efectivos. En la cooperación posterior, será más armonioso.

El archivo adjunto es un suplemento de elección y no es necesario reflejarlo en el informe de datos, pero sigue siendo información valiosa. Para la diapositiva, esta parte también se puede colocar después del agradecimiento. Si tu colega tiene alguna pregunta, puede pasar a la última explicación en cualquier momento.

3. Conclusión

Un producto, si no puedes medirlo, no puedes entenderlo y, naturalmente, no puedes mejorarlo. Se trata de datos.El significado del informe de datos es similar: una vez finalizado el proyecto, se requiere un informe completo, por lo que es de gran importancia tanto para el informe como para el equipo.

0 notes

Text

4 Formas de Extraer Datos del Sitio Web a Excel

Probablemente sepas cómo usar funciones básicas en Excel. Es fácil hacer cosas como ordenar, aplicar filtros, hacer gráficos y delinear datos con Excel. Incluso puedes realizar análisis de datos avanzados utilizando modelos de pivote y regresión. Se convierte en un trabajo fácil cuando los datos en vivo se convierten en un formato estructurado.

El problema es, ¿Cómo podemos extraer datos y ponerlos en Excel? Esto puede ser tedioso si lo haces manualmente escribiendo, buscando, copiando y pegando repetidamente. En cambio, puedes lograr la extracciñon automática de datos de la web para sobresalir.

En este artículo, te presentaré varias formas de ahorrar tiempo y energía, scrapear datos web en Excel.

Descargo de responsabilidad: Hay muchas otras formas de scrapear datos desde una web utilizando lenguajes de programación como PHP, Python, Perl, Ruby, etc. Aquí solo hablamos sobre cómo obtener datos de una web en Excel para no codificadores.

Tabla de contenidos

Obtener datos web utilizando Excel Web Queries

Obtener datos de la web usando Excel VBA

Utilizar herramientas de web scraping automatizadas

Subcontratar tu proyecto de web scraping

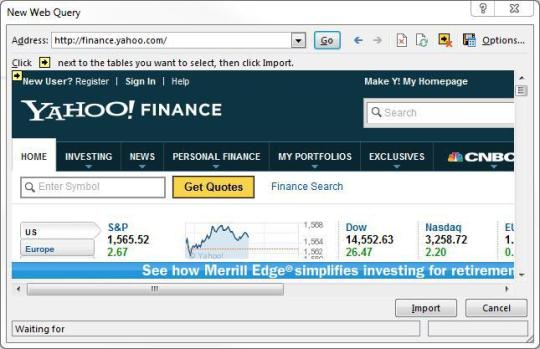

Obtener datos web utilizando Excel Web Queries

Excepto para transformar manualmente los datos de una página web copiando y pegando, Excel Web Queries se utiliza para recuperar rápidamente datos de páginas web estándar en hojas de cálculo de Excel. Puede detectar automáticamente tablas incrustadas en el HTML de la página web. Excel Web queries también se pueden usar en situaciones en las que es difícil crear o mantener una conexión estándar ODBC (Open Database Connectivity). Puede scrapear directamente una tabla desde cualquier sitio web utilizando Excel Web Queries.

El proceso se reduce a varios pasos simples (consulta este artículo):

1. Ir a Datos> Obtener datos externos> Dar la web

2. Aparecerá una ventana del navegador llamada "New Web Query"

3. Escribir la dirección web en la barra de direcciones.

4. Se cargará y mostrará iconos amarillos contra datos/tablas en la página.

5. Seleccionar uno apropiado

6. Presionar el botón Importar.

Ahora has scrapeado los datos de la web en una hoja de cálculo de Excel, perfecta permutación en filas y columnas como desees.

Obtener datos de la web usando Excel VBA

La mayoría de nosotros usaría fórmulas en Excel (p. Ej. = Avg (...), = sum (...), = if (...), etc.) mucho, pero menos familiarizado con el lenguaje incorporado: Visual BasicVisual Basic for Application a.k.a VBA. Se conoce comúnmente como "Macros" y dichos archivos de Excel se guardan como a **.xlsm.

Antes de usarlo,

Primero debes habilitar la pestaña la pestaña Desarrollador en la barra (hacer clic con el botón derecho en Archivo -> Personalizar barra -> verificar la pestaña Desarrollador),

Luego configura tu diseño. En esta interfaz de desarrollador, puedes escribir código VBA adjunto a varios eventos. Haz clic AQUÍ (https://msdn.microsoft.com/en-us/library/office/ee814737(v=office.14).aspx) para comenzar a utilizar VBA en Excel 2010.

Usar Excel VBA va a ser un poco técnico, esto no es muy amigable para quienes no son programadores entre nosotros. VBA funciona ejecutando macros, procedimientos paso a paso escritos en Excel Visual Basic. Para scrapear datos de sitios web a Excel usando VBA, necesitamos construir u obtener un script VBA para enviar alguna solicitud a las páginas web y obtener datos devueltos de estas páginas web. Es común usar VBA con XMLHTTP y expresiones regulares para analizar las páginas web. Para Windows, puedes usar VBA con WinHTTP o InternetExplorer para scrapear datos de sitios web a Excel.

Con un poco de paciencia y práctica, te convendría aprender algo de código Excel VBA y algo de conocimiento HTML para que tu Web scraping en Excel sea mucho más fácil y eficiente para automatizar el trabajo repetitivo. Hay una gran cantidad de material y foros para que aprendas a escribir código VBA.

Utilizar herramientas de web scraping automatizadas

Para alguien que está buscando una herramienta rápida para scrapear datos de las páginas a Excel y no quiere configurar el código VBA tú mismo, te recomiendo encarecidamente herramientas de web scraping automatizadas como Octoparse para scrapear datos para tu hoja de cálculo de Excel directamente o mediante API.

No hay necesidad de aprender a programar. Puedes elegir uno de esos programas gratuitos de web scraping de la lista y comenzar a extraer datos de sitios web de inmediato y exportarlos a Excel. Las diferentes herramientas de web scraping tienen sus ventajas y desventajas, y puedes elegir la perfecta para tus necesidades.

Echa un vistazo a esta publicación y prueba estas TOP 30 herramientas gratuitas de web scraping.

Subcontratar tu proyecto de web scraping

Si el tiempo es tu activo más valioso y deseas enfocarte en tus negocios principales, la mejor opción sería subcontratar un trabajo tan complicado de scrapear de contenido web a un equipo competente de scrapear de contenido web que tenga experiencia y conocimientos.

Es difícil scapear datos de sitios web debido al hecho de que la presencia de bots anti-scrape restringirá la práctica del web scraping. Un equipo competente de web scraping te ayudaría a obtener datos de los sitios web de manera adecuada y a entregarte datos estructurados en una hoja de Excel o en cualquier formato que necesites.

Octoparse proporciona todo lo que necesitas para la extracción automática de datos. Puedes scrapear los datos web rápidamente sin codificar y convierte las páginas web en datos estructurados con clics, o simplemente relájate y déjanos el trabajo a nosotros, ofrecemos servico de datos que nuestro equipo de datos se reunirá contigo para analizar el rastreo web y los requisitos de procesamiento de datos.

0 notes

Text

Las 9 mejores herramientas de visualización de datos para no desarrolladores

Estamos inundados de datos y nos resulta difícil presentar el significado detrás de ellos. Aquí es donde entran en escena las herramientas de visualización de datos. Por lo tanto, te proporciono 9 herramientas útiles de visualización de datos para que comprendas tus datos. ¡Espero que este artículo te ayude bien!

Tabla de Contenidos

Datawrapper

Tableau

Chart.js

Raw

Infogram

Timeline JS

Plotly

DataHero

Visualize Free

Datawrapper

Datawrapper es una herramienta de visualización de datos en línea para crear gráficos interactivos. Una vez que cargues los datos del archivo CSV o los pegues directamente en el campo, Datawrapper generará una barra, línea o cualquier otra visualización relacionada. Muchos reporteros y organizaciones de noticias usan Datawrapper para integrar gráficos en vivo en sus artículos. Es muy fácil de usar y produce gráficos efectivos.

Pros

Diseñado específicamente para la visualización de datos en salas de redacción

El plan gratuito es una buena opción para sitios más pequeños

La herramienta incluye un comprobador de daltonismo incorporado

Contras

Fuentes de datos limitadas

Los planes pagados son caros

Tableau

Tableau Public es quizás la herramienta de visualización más popular que admite una amplia variedad de cuadros, gráficos, mapas y otros gráficos. Es una herramienta completamente gratuita y los gráficos que crea con ella se pueden incrustar fácilmente en cualquier página web. Tienen una bonita galería que muestra visualizaciones creadas a través de Tableau.

Aunque ofrece cuadros y gráficos que son mucho mejores que otras herramientas similares, no me "encanta" usar su versión gratuita debido al gran pie de página con el que viene. Si no te disgusta tanto como a mí, definitivamente deberías intentarlo. O si puedes pagarlo, puedes optar por una versión paga.

Pros

Cientos de opciones de importación de datos

Capacidad de mapeo

Versión pública gratuita disponible

Muchos videos tutoriales para guiarlo a través de cómo usar Tableau

Contras

Las versiones que no son gratuitas son caras ($ 70 / mes / usuario para el software Tableau Creator)

La versión pública no te permite mantener privados los análisis de datos

Chart.js

Chart.js se adapta perfectamente a proyectos más pequeños. Aunque cuenta con solo seis tipos de gráficos, la biblioteca de código abierto Chart.js es la herramienta de visualización de datos perfecta para pasatiempos y pequeños proyectos. Utilizando elementos de lienzo HTML 5 para representar gráficos, Chart.js crea diseños planos y receptivos y se está convirtiendo rápidamente en una de las bibliotecas de gráficos de código abierto más populares.

Pros

Gratis y de código abierto

Salida receptiva y compatible con varios navegadores

Contras

Tipos de gráficos muy limitados en comparación con otras herramientas

Soporte limitado fuera de la documentación oficial

RAWGraphs

Raw se define a sí mismo como "el link perdido entre las hojas de cálculo y los gráficos vectoriales". Está construido sobre D3.js y está extremadamente bien diseñado. Tiene una interfaz tan intuitiva que sentirá que la has usado antes. Es de código abierto y no requiere ningún registro.

Tiene una biblioteca de 21 tipos de gráficos para elegir y todo el procesamiento se realiza en el navegador. Entonces tus datos están seguros. RAW es altamente personalizable y extensible, e incluso puede aceptar nuevos diseños personalizados.

Pros

Gratis ycódigo abierto

Intuitivo y eficiente

Tiene documento de ayuda

Contras

No tiene muchas opciones ajustables

Infogram

Infogram te permite crear gráficos e infografías en línea. Tiene una versión gratuita restringida y dos opciones de pago que incluyen funciones como más de 200 mapas, uso compartido privado y biblioteca de iconos, etc.

Viene con una interfaz fácil de usar y sus gráficos básicos están bien diseñados. Una característica que no me gustó es el enorme logotipo que aparece cuando intentas insertar gráficos interactivos en tu página web (en la versión gratuita). Será mejor si pueden hacerlo como el pequeño texto que usa Datawrapper.

Pros

Precios escalonados, incluido un plan gratuito con funciones básicas

Incluye más de 35 tipos de gráficos y más de 550 tipos de mapas

Editor de arrastrar y soltar

API para importar fuentes de datos adicionales

Contras

Significativamente menos fuentes de datos integradas que otras aplicaciones

Timeline JS

Como sugiere el nombre, Timeline JS te ayuda a crear hermosas líneas de tiempo sin escribir ningún código. Es una herramienta gratuita de código abierto que utilizan algunos de los sitios web más populares como Time y Radiolab.

Es un proceso de cuatro pasos muy fácil de seguir para crear su línea de tiempo que se explica aquí. ¿Mejor parte? Puede extraer medios de una variedad de fuentes y tiene soporte integrado para Twitter, Flickr, Google Maps, YouTube, Vimeo, Vine, Dailymotion, Wikipedia, SoundCloud y otros sitios similares.

Pros

Hacer una historia ilustrativa con TimelineJS no es complejo y, a veces, podría darte un buen resultado

Contras

No es flexible y no da mucho espacio para ser creativo

También, es difícil adaptarlo bien a su sitio web

Plotly

Plotly es una herramienta de análisis y gráficos de datos basada en la web. Admite una buena colección de tipos de gráficos con funciones integradas para compartir en redes sociales. Los cuadros y tipos de gráficos disponibles tienen un aspecto profesional. Crear un gráfico es solo una cuestión de cargar su información y personalizar el diseño, los ejes, las notas y la leyenda. Si estás buscando comenzar, puedes encontrar algo de inspiración aquí.

Pros

Figuras creadas hermosas, interactivas y exportables con solo unas pocas líneas de código

Mucho más interactivo y visualmente flexible que Matplotlib o Seaborn

Contras

Configuración inicial confusa para usar Plotly sin una cuenta en línea

Mucho código para escribir

DataHero

DataHero te permite reunir datos de servicios en la nube y crear gráficos y paneles. No se requieren habilidades técnicas, por lo que esta es una gran herramienta para que la use todo tu equipo.

Pros

Capacidad de conectarse a otras plataformas y tener esos datos actualizados diariamente

Interfaz de usuario sencilla, muchas opciones e integraciones con otras aplicaciones

Funcionalidad de exportación y rapidez

Contras

La tarea de mostrar datos duros de una manera elegante y sencilla no es fácil de entender para todos

Necesitan mejores consejos sobre cómo generar tablas por encima del promedio

Visualize Free

Visualize Free es una herramienta alojada que te permite utilizar conjuntos de datos disponibles públicamente, o cargar los tuyos propios, y crear visualizaciones interactivas para ilustrar los datos. Las visualizaciones van mucho más allá de los gráficos simples, y el servicio es completamente gratuito y, si bien el trabajo de desarrollo requiere Flash, la salida se puede realizar a través de HTML5.

Pros

Los conjuntos de datos pueden ser archivos de Excel (XLS o XLSX) o texto (CSV o TEXT)

Crear cuadros de mando exploratorios y analíticos

Descubrir tendencias y asociaciones significativas

Contras

No debe utilizarse con fines comerciales

Sin modelos de datos ni mashups de datos

Estas son las 9 mejores herramientas de visualización de datos para no desarrolladores que recomendé.

Al final, quiero agregar que use estas herramientas en cooperación con Octoparse, una herramienta dedicada de raspado web que te ayudará a comprender los datos de manera más rápida, fácil y clara.

0 notes

Text

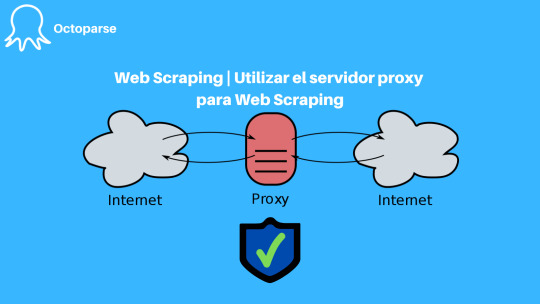

Web Scraping | Utilizar el servidor proxy para Web Scraping

Tabla de Contenidos

¿Por Qué Utilizar El Servidor Proxy Para El Web Scraping?

La Fiabilidad Del Proxy

Web Scraping En La Nube

Web Scrapers Populares Para Evitar El Bloqueo De IP

Octoparse

Import.io

Webhose.io

Screen Scraper

¿Por Qué Utilizar El Servidor Proxy Para El Web Scraping?

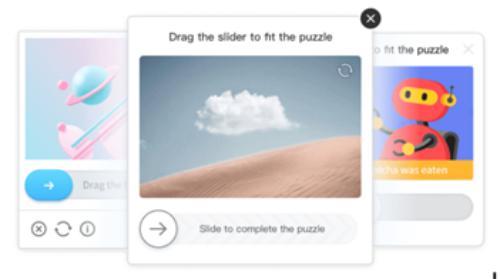

Web Scraper o spider se vuelve cada vez más popular en la ciencia de datos. Esta técnica automática puede ayudarnos a recuperar una gran cantidad de datos personalizados de la Web o de la base de datos. Sin embargo, el problema principal es que el sitio web puede rastrear fácilmente la solicitud de demasiadas páginas en un período de tiempo demasiado corto mediante una única dirección IP, por lo que el sitio web de destino puede bloquearlo. Para limitar las posibilidades de ser bloqueado, debemos intentar evitar raspar un sitio web con una única dirección IP. Y normalmente, utilizamos servidores proxy que incluyen direcciones IP de proxy discretas siempre que las solicitudes se enrutan a través del servidor de rastreo.

La Fiabilidad Del Proxy

Preocupados por el servidor proxy, la fiabilidad del proxy siempre debe ser lo primero en nuestra mente. En realidad, hay alrededor de 1000 lugares para comprar proxies y algunos proxies poco confiables irían demasiado rápido, lo que podría causar que se bloqueen. También hay otros enfoques que pueden estar más relacionados con la subcontratación de la rotación de IP (piensa en el proxy como un servicio), pero estos servicios generalmente tienen un costo más alto. Dado que existe un costo de comprar el proxy y el costo de volver a implementar el proxy cada vez que compra uno nuevo. Con mucha frecuencia, la confiabilidad tiene un costo y, a menudo, encontrará que "gratis" será muy poco confiable, "barato" será algo poco confiable y "más costoso" generalmente tendrá un costo adicional. Por lo tanto, recientemente se ha propuesto el concepto de extracción de datos basada en la nube.

Web Scraping En La Nube

Web Scraping basado en la nube es un verdadero servicio basado en la nube, puede ejecutarse desde cualquier sistema operativo y cualquier navegador. No tenemos que alojar nada nosotros mismos y todo se hace en la nube. Además, todas las visitas a la página del sitio web, la formación de datos y la transformación se pueden manejar en el servidor de otra persona. Los requisitos de proxy web pueden ser gestionados por nosotros mismos.

En el lado de la nube, estas máquinas son independientes, se puede acceder a ellas y ejecutarlas sin necesidad de instalarlas desde cualquier PC con acceso a Internet en todo el mundo. Este servicio administrará nuestros datos con un increíble hardware de back-end, más específicamente, podemos utilizar su función de proxy anónimo que podría rotar toneladas de direcciones IP para evitar ser bloqueadas por el sitio web de destino.

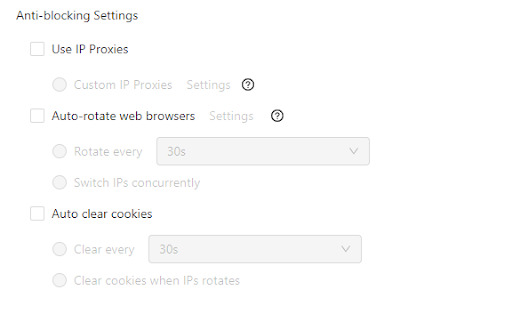

Web Scrapers Populares Para Evitar El Bloqueo De IP

En realidad, podemos adoptar un enfoque más conciso y eficiente mediante el uso de cierta herramienta Data Scraper con servicios basados en la nube, como Octoparse, Import.io. Estas herramientas pueden programar y ejecutar tu tarea en cualquier momento en el lado de la nube con toneladas de PC ejecutándose en el Mismo tiempo. Además, estas herramientas de raspador también pueden proporcionarnos una forma rápida de configurar manualmente estos servidores proxy según lo necesites. Aquí hay un tutorial que presenta cómo configurar proxies en Octoparse.

Algunas herramientas de raspador populares en el mercado incluyen Octoparse, Import.io, Webhose.io, Screen Scraper.

1.Octoparse

Octoparse es una herramienta de rastreo de datos poderosa y gratuita que puede rastrear casi todos los sitios web. Su extracción de datos basada en la nube puede proporcionar servidores proxy de dirección IP rotativos ricos para web scraping, lo que ha limitado las posibilidades de ser bloqueado y ahorrado mucho tiempo para la configuración manual. Han proporcionado instrucciones precisas y pautas claras para seguir los pasos de raspado. Básicamente, para esta herramienta, no es necesario tener habilidades de codificación. De todos modos, si deseas profundizar y fortalecer tu rastreo y raspado, ha ofrecido una API pública si lo necesitas. Además, su soporte de respaldo es eficiente y está disponible.

2.Import.io

Import.io también es un raspador de datos de escritorio fácil de usar. Tiene una interfaz de usuario sucinta y eficaz y una navegación sencilla. Para esta herramienta, también requiere menos habilidades de codificación. Import.io también posee muchas características poderosas, como el servicio basado en la nube que puede ayudarnos a cuidar mejor de nuestra tarea programada y mejorar nuestra capacidad de minería para su dirección IP rotativa. Sin embargo, Improt.io tiene dificultades para navegar a través de combinaciones de javascript / POST.

3.Webhose.io

Webhose.io es una herramienta de rastreo de datos basada en navegador que utiliza varias técnicas de rastreo de datos para rastrear cantidades de datos de múltiples canales. Si bien puede que no se comporte tan bien como las herramientas introducidas anteriormente sobre su servicio en la nube, lo que significa que el proceso de raspado relacionado con la rotación de IP o la configuración del proxy puede ser algo complejo. Han proporcionado un plan de servicio gratuito y de pago según lo necesites.

4.Screen Scraper

Screen Scraper es bastante ordenado y puede lidiar con ciertas tareas difíciles, incluida la localización precisa, la navegación y la extracción de datos, sin embargo, requiere que tengas habilidades básicas de programación / tokenización si deseas que funcione al máximo. Implica que debes configurar los ajustes y establecer los parámetros manualmente la mayor parte del tiempo, las ventajas de que puede personalizar tu proceso de minería distintivo, mientras que las desventajas son que requiere un poco de tiempo y es complejo. Además, es un poco caro.

0 notes

Text

Los 30 Mejores Software Gratuitos de Web Scraping en 2021

El Web scraping (también denominado extracción datos de una web, web crawler, web scraper o web spider) es una web scraping técnica para extraer datos de una página web . Convierte datos no estructurados en datos estructurados que pueden almacenarse en su computadora local o en database.

Puede ser difícil crear un web scraping para personas que no saben nada sobre codificación. Afortunadamente, hay herramientas disponibles tanto para personas que tienen o no habilidades de programación. Aquí está nuestra lista de las 30 herramientas de web scraping más populares, desde bibliotecas de código abierto hasta extensiones de navegador y software de escritorio.

Tabla de Contenido

Beautiful Soup

Octoparse

Import.io

Mozenda

Parsehub

Crawlmonster

Connotate

Common Crawl

Crawly

Content Grabber

Diffbot

Dexi.io

DataScraping.co

Easy Web Extract

FMiner

Scrapy

Helium Scraper

Scrape.it

Scrapinghub

Screen-Scraper

Salestools.io

ScrapeHero

UniPath

Web Content Extractor

WebHarvy

Web Scraper.io

Web Sundew

Winautomation

Web Robots

1. Beautiful Soup

Para quién sirve: desarrolladores que dominan la programación para crear un web spider/web crawler.

Por qué deberías usarlo:Beautiful Soup es una biblioteca de Python de código abierto diseñada para scrape archivos HTML y XML. Son los principales analizadores de Python que se han utilizado ampliamente. Si tienes habilidades de programación, funciona mejor cuando combina esta biblioteca con Python.

Esta tabla resume las ventajas y desventajas de cada parser:-

ParserUso estándarVentajasDesventajas

html.parser (puro)BeautifulSoup(markup, "html.parser")

Pilas incluidas

Velocidad decente

Leniente (Python 2.7.3 y 3.2.)

No es tan rápido como lxml, es menos permisivo que html5lib.

HTML (lxml)BeautifulSoup(markup, "lxml")

Muy rápido

Leniente

Dependencia externa de C

XML (lxml)

BeautifulSoup(markup, "lxml-xml") BeautifulSoup(markup, "xml")

Muy rápido

El único parser XML actualmente soportado

Dependencia externa de C

html5lib

BeautifulSoup(markup, "html5lib")

Extremadamente indulgente

Analizar las páginas de la misma manera que lo hace el navegador

Crear HTML5 válido

Demasiado lento

Dependencia externa de Python

2. Octoparse

Para quién sirve: Las empresas o las personas tienen la necesidad de captura estos sitios web: comercio electrónico, inversión, criptomoneda, marketing, bienes raíces, etc. Este software no requiere habilidades de programación y codificación.

Por qué deberías usarlo: Octoparse es una plataforma de datos web SaaS gratuita de por vida. Puedes usar para capturar datos web y convertir datos no estructurados o semiestructurados de sitios web en un conjunto de datos estructurados sin codificación. También proporciona task templates de los sitios web más populares de países hispanohablantes para usar, como Amazon.es, Idealista, Indeed.es, Mercadolibre y muchas otras. Octoparse también proporciona servicio de datos web. Puedes personalizar tu tarea de crawler según tus necesidades de scraping.

PROS

Interfaz limpia y fácil de usar con un panel de flujo de trabajo simple

Facilidad de uso, sin necesidad de conocimientos especiales

Capacidades variables para el trabajo de investigación

Plantillas de tareas abundantes

Extracción de nubes

Auto-detección

CONS

Se requiere algo de tiempo para configurar la herramienta y comenzar las primeras tareas

3. Import.io

Para quién sirve: Empresa que busca una solución de integración en datos web.

Por qué deberías usarlo: Import.io es una plataforma de datos web SaaS. Proporciona un software de web scraping que le permite extraer datos de una web y organizarlos en conjuntos de datos. Pueden integrar los datos web en herramientas analíticas para ventas y marketing para obtener información.

PROS

Colaboración con un equipo

Muy eficaz y preciso cuando se trata de extraer datos de grandes listas de URL

Rastrear páginas y raspar según los patrones que especificas a través de ejemplos

CONS

Es necesario reintroducir una aplicación de escritorio, ya que recientemente se basó en la nube

Los estudiantes tuvieron tiempo para comprender cómo usar la herramienta y luego dónde usarla.

4. Mozenda

Para quién sirve: Empresas y negocios hay necesidades de fluctuantes de datos/datos en tiempo real.

Por qué deberías usarlo: Mozenda proporciona una herramienta de extracción de datos que facilita la captura de contenido de la web. También proporcionan servicios de visualización de datos. Elimina la necesidad de contratar a un analista de datos.

PROS

Creación dinámica de agentes

Interfaz gráfica de usuario limpia para el diseño de agentes

Excelente soporte al cliente cuando sea necesario

CONS

La interfaz de usuario para la gestión de agentes se puede mejorar

Cuando los sitios web cambian, los agentes podrían mejorar en la actualización dinámica

Solo Windows

5. Parsehub

Para quién sirve: analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: ParseHub es un software visual de web scrapinng que puede usar para obtener datos de la web. Puede extraer los datos haciendo clic en cualquier campo del sitio web. También tiene una rotación de IP que ayudaría a cambiar su dirección IP cuando se encuentre con sitios web agresivos con una técnica anti-scraping.

PROS

Tener un excelente boaridng que te ayude a comprender el flujo de trabajo y los conceptos dentro de las herramientas

Plataforma cruzada, para Windows, Mac y Linux

No necesita conocimientos básicos de programación para comenzar

Soporte al usuario de muy alta calidad

CONS

No se puede importar / exportar la plantilla

Tener una integración limitada de javascript / regex solamente

6. Crawlmonster

Para quién sirve: SEO y especialistas en marketing

Por qué deberías usarlo: CrawlMonster es un software de web scraping gratis. Te permite escanear sitios web y analizar el contenido de tu sitio web, el código fuente, el estado de la página y muchos otros.

PROS

Facilidad de uso

Atención al cliente

Resumen y publicación de datos

Escanear el sitio web en busca de todo tipo de puntos de datos

CONS

Funcionalidades no son tan completas

7. Connotate

Para quién sirve: Empresa que busca una solución de integración en datos web.

Por qué deberías usarlo: Connotate ha estado trabajando junto con Import.io, que proporciona una solución para automatizar el scraping de datos web. Proporciona un servicio de datos web que puede ayudarlo a scrapear, recopilar y manejar los datos.

PROS

Fácil de usar, especialmente para no programadores

Los datos se reciben a diario y, por lo general, son bastante limpios y fáciles de procesar

Tiene el concepto de programación de trabajos, que ayuda a obtener datos en tiempos programados

CONS

Unos cuantos glitches con cada lanzamiento de una nueva versión provocan cierta frustración

Identificar las faltas y resolverlas puede llevar más tiempo del que nos gustaría

8. Common Crawl

Para quién sirve: Investigador, estudiantes y profesores.

Por qué deberías usarlo: Common Crawl se basa en la idea del código abierto en la era digital. Proporciona conjuntos de datos abiertos de sitios web rastreados. Contiene datos sin procesar de la página web, metadatos extraídos y extracciones de texto.

Common Crawl es una organización sin fines de lucro 501 (c) (3) que rastrea la web y proporciona libremente sus archivos y conjuntos de datos al público.

9. Crawly

Para quién sirve: Personas con requisitos de datos básicos sin hababilidad de codificación.

Por qué deberías usarlo: Crawly proporciona un servicio automático que scrape un sitio web y lo convierte en datos estructurados en forma de JSON o CSV. Pueden extraer elementos limitados en segundos, lo que incluye: Texto del título. HTML, comentarios, etiquetas de fecha y entidad, autor, URL de imágenes, videos, editor y país.

Características

Análisis de demanda

Investigación de fuentes de datos

Informe de resultados

Personalización del robot

Seguridad, LGPD y soporte

10. Content Grabber

Para quién sirve: Desarrolladores de Python que son expertos en programación.

Por qué deberías usarlo: Content Grabber es un software de web scraping dirigido a empresas. Puede crear sus propios agentes de web scraping con sus herramientas integradas de terceros. Es muy flexible en el manejo de sitios web complejos y extracción de datos.

PROS

Fácil de usar, no requiere habilidades especiales de programación

Capaz de raspar sitios web de datos específicos en minutos

Debugging avanzado

Ideal para raspados de bajo volumen de datos de sitios web

CONS

No se pueden realizar varios raspados al mismo tiempo

Falta de soporte

11. Diffbot

Para quién sirve: Desarrolladores y empresas.

Por qué deberías usarlo: Diffbot es una herramienta de web scraping que utiliza aprendizaje automático y algoritmos y API públicas para extraer datos de páginas web (web scraping). Puede usar Diffbot para el análisis de la competencia, el monitoreo de precios, analizar el comportamiento del consumidor y muchos más.

PROS

Información precisa actualizada

API confiable

Integración de Diffbot

CONS

La salida inicial fue en general bastante complicada, lo que requirió mucha limpieza antes de ser utilizable

12. Dexi.io

Para quién sirve: Personas con habilidades de programación y cotificación.

Por qué deberías usarlo: Dexi.io es un web spider basado en navegador. Proporciona tres tipos de robots: extractor, rastreador y tuberías. PIPES tiene una función de robot maestro donde 1 robot puede controlar múltiples tareas. Admite muchos servicios de terceros (solucionadores de captcha, almacenamiento en la nube, etc.) que puede integrar fácilmente en sus robots.

PROS

Fácil de empezar

El editor visual hace que la automatización web sea accesible para las personas que no están familiarizadas con la codificación

Integración con Amazon S3

CONS

La página de ayuda y soporte del sitio no cubre todo

Carece de alguna funcionalidad avanzada

13. DataScraping.co

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Data Scraping Studio es un software web scraping gratis para recolectar datos de páginas web, HTML, XML y pdf.

PROS

Una variedad de plataformas, incluidas en línea / basadas en la web, Windows, SaaS, Mac y Linux

14. Easy Web Extract

Para quién sirve: Negocios con necesidades limitadas de datos, especialistas en marketing e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Easy Web Extract es un software visual de scraping y crawling para fines comerciales. Puede extraer el contenido (texto, URL, imagen, archivos) de las páginas web y transformar los resultados en múltiples formatos.

Características

Agregación y publicación de datos

Extracción de direcciones de correo electrónico

Extracción de imágenes

Extracción de dirección IP

Extracción de número de teléfono

Extracción de datos web

15. FMiner

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: FMiner es un software de web scraping con un diseñador de diagramas visuales, y le permite construir un proyecto con una grabadora de macros sin codificación. La característica avanzada le permite scrapear desde sitios web dinámicos usando Ajax y Javascript.

PROS

Herramienta de diseño visual

No se requiere codificación

Características avanzadas

Múltiples opciones de navegación de rutas de rastreo

Listas de entrada de palabras clave

CONS

No ofrece formación

16. Scrapy

Para quién sirve: Desarrollador de Python con habilidades de programación y scraping

Por qué deberías usarlo: Scrapy se usa para desarrollar y construir una araña web. Lo bueno de este producto es que tiene una biblioteca de red asincrónica que le permitirá avanzar en la siguiente tarea antes de que finalice.

PROS

Construido sobre Twisted, un marco de trabajo de red asincrónico

Rápido, las arañas scrapy no tienen que esperar para hacer solicitudes una a la vez

CONS

Scrapy es solo para Python 2.7. +

La instalación es diferente para diferentes sistemas operativos

17. Helium Scrape

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Helium Scraper es un software visual de scraping de datos web que funciona bastante bien, especialmente eficaz para elementos pequeños en el sitio web. Tiene una interfaz fácil de apuntar y hacer clic, lo que facilita su uso.

Características:

Extracción rápida. Realizado por varios navegadores web Chromium fuera de la pantalla

Capturar datos complejos

Extracción rápida

Capturar datos complejos

Extracción rápida

Flujo de trabajo simple

Capturar datos complejos

18. Scrape.it

Para quién sirve: Personas que necesitan datos escalables sin codificación.

Por qué deberías usarlo: Permite que los datos raspados se almacenen en tu disco local que autorizas. Puede crear un Scraper utilizando su lenguaje de web scraping (WSL), que tiene una curva de aprendizaje baja y no tiene que estudiar codificación. Es una buena opción y vale la pena intentarlo si está buscando una herramienta de web scraping segura.

PROS

Soporte móvil

Agregación y publicación de datos

Automatizará todo el sitio web para ti

CONS

El precio es un poco alto

19. ScraperWiki

Para quién sirve: Un entorno de análisis de datos Python y R, ideal para economistas, estadísticos y administradores de datos que son nuevos en la codificación.

Por qué deberías usarlo: ScraperWiki tiene dos nombres

QuickCode: es el nuevo nombre del producto ScraperWiki original. Le cambian el nombre, ya que ya no es un wiki o simplemente para rasparlo. Es un entorno de análisis de datos de Python y R, ideal para economistas, estadísticos y administradores de datos que son nuevos en la codificación.

The Sensible Code Company: es el nuevo nombre de su empresa. Diseñan y venden productos que convierten la información desordenada en datos valiosos.

20. Zyte (anteriormente Scrapinghub)

Para quién sirve: Python/Desarrolladores de web scraping

Por qué deberías usarlo: Zyte es una plataforma web basada en la nube. Tiene cuatro tipos diferentes de herramientas: Scrapy Cloud, Portia, Crawlera y Splash. Es genial que Zyte ofrezca una colección de direcciones IP cubiertas en más de 50 países, que es una solución para los problemas de prohibición de IP.

PROS

La integración (scrapy + scrapinghub) es realmente buena, desde una simple implementación a través de una biblioteca o un docker lo hace adecuado para cualquier necesidad

El panel de trabajo es fácil de entender

La efectividad

CONS

No hay una interfaz de usuario en tiempo real que pueda ver lo que está sucediendo dentro de Splash

No hay una solución simple para el rastreo distribuido / de gran volumen

Falta de monitoreo y alerta.

21. Screen-Scraper

Para quién sirve: Para los negocios se relaciona con la industria automotriz, médica, financiera y de comercio electrónico.

Por qué deberías usarlo: Screen Scraper puede proporcionar servicios de datos web para las industrias automotriz, médica, financiera y de comercio electrónico. Es más conveniente y básico en comparación con otras herramientas de web scraping como Octoparse. También tiene un ciclo de aprendizaje corto para las personas que no tienen experiencia en el web scraping.

PROS

Sencillo de ejecutar - se puede recopilar una gran cantidad de información hecha una vez

Económico - el raspado brinda un servicio básico que requiere poco o ningún esfuerzo

Precisión - los servicios de raspado no solo son rápidos, también son exactos

CONS

Difícil de analizar - el proceso de raspado es confuso para obtenerlo si no eres un experto

Tiempo - dado que el software tiene una curva de aprendizaje

Políticas de velocidad y protección - una de las principales desventajas del rastreo de pantalla es que no solo funciona más lento que las llamadas a la API, pero también se ha prohibido su uso en muchos sitios web

22. Salestools.io

Para quién sirve: Comercializador y ventas.

Por qué deberías usarlo: Salestools.io proporciona un software de web scraping que ayuda a los vendedores a recopilar datos en redes profesionales como LinkedIn, Angellist, Viadeo.

PROS

Crear procesos de seguimiento automático en Pipedrive basados en los acuerdos creados

Ser capaz de agregar prospectos a lo largo del camino al crear acuerdos en el CRM

Ser capaz de integrarse de manera eficiente con CRM Pipedrive

CONS

La herramienta requiere cierto conocimiento de las estrategias de salida y no es fácil para todos la primera vez

El servicio necesita bastantes interacciones para obtener el valor total

23. ScrapeHero

Para quién sirve: Para inversores, Hedge Funds, Market Analyst es muy útil.

Por qué deberías usarlo: ScrapeHero como proveedor de API le permite convertir sitios web en datos. Proporciona servicios de datos web personalizados para empresas y empresas.

PROS

La calidad y consistencia del contenido entregado es excelente

Buena capacidad de respuesta y atención al cliente

Tiene buenos analizadores disponibles para la conversión de documentos a texto

CONS

Limited functionality in terms of what it can do with RPA, it is difficult to implement in use cases that are non traditional

Los datos solo vienen como un archivo CSV

24. UniPath

Para quién sirve: Negocios con todos los tamaños

Por qué deberías usarlo: UiPath es un software de automatización de procesos robótico para el web scraping gratuito. Permite a los usuarios crear, implementar y administrar la automatización en los procesos comerciales. Es una gran opción para los usuarios de negocios, ya que te hace crear reglas para la gestión de datos.

Características:

Conversión del valor FPKM de expresión génica en valor P

Combinación de valores P

Ajuste de valores P

ATAC-seq de celda única

Puntuaciones de accesibilidad global

Conversión de perfiles scATAC-seq en puntuaciones de enriquecimiento de la vía

25. Web Content Extractor

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Web Content Extractor es un software de web scraping fácil de usar para fines privados o empresariales. Es muy fácil de aprender y dominar. Tiene una prueba gratuita de 14 días.

PROS

Fácil de usar para la mayoría de los casos que puede encontrar en web scraping

Raspar un sitio web con un simple clic y obtendrá tus resultados de inmediato

Su soporte responderá a tus preguntas relacionadas con el software

CONS

El tutorial de youtube fue limitado

26. Webharvy

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: WebHarvy es un web scraping software de apuntar y hacer clic. Está diseñado para no programadores. El extractor no le permite programar. Tienen tutoriales de web scraping que son muy útiles para la mayoría de los usuarios principiantes.

PROS

Webharvey es realmente útil y eficaz. Viene con una excelente atención al cliente

Perfecto para raspar correos electrónicos y clientes potenciales

La configuración se realiza mediante una GUI que facilita la instalación inicialmente, pero las opciones hacen que la herramienta sea aún más poderosa

CONS

A menudo no es obvio cómo funciona una función

Tienes que invertir mucho esfuerzo en aprender a usar el producto correctamente

27. Web Scraper.io

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Web Scraper es una extensión de navegador Chrome creada para extraer datos en la web. Es un software gratuito de web scraping para descargar páginas web dinámicas.

PROS

Los datos que se raspan se almacenan en el almacenamiento local y, por lo tanto, son fácilmente accesibles

Funciona con una interfaz limpia y sencilla

El sistema de consultas es fácil de usar y es coherente con todos los proveedores de datos

CONS

Tiene alguna curva de aprendizaje

No para organizaciones

28. Web Sundew

Para quién sirve: Empresas, comercializadores e investigadores.

Por qué deberías usarlo: WebSundew es una herramienta de crawly web scraper visual que funciona para el raspado estructurado de datos web. La edición Enterprise le permite ejecutar el scraping en un servidor remoto y publicar los datos recopilados a través de FTP.

Caraterísticas:

Interfaz fácil de apuntar y hacer clic

Extraer cualquier dato web sin una línea de codificación

Desarrollado por Modern Web Engine

Software de plataforma agnóstico

29. Winautomation

Para quién sirve: Desarrolladores, líderes de operaciones comerciales, profesionales de IT

Por qué deberías usarlo: Winautomation es una herramienta de web scraper parsers de Windows que le permite automatizar tareas de escritorio y basadas en la web.

PROS

Automatizar tareas repetitivas

Fácil de configurar

Flexible para permitir una automatización más complicada

Se notifica cuando un proceso ha fallado

CONS

Podría vigilar y descartar actualizaciones de software estándar o avisos de mantenimiento

La funcionalidad FTP es útil pero complicada

Ocasionalmente pierde la pista de las ventanas de la aplicación

30. Web Robots

Para quién sirve: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué deberías usarlo: Web Robots es una plataforma de web scraping basada en la nube para scrape sitios web dinámicos con mucho Javascript. Tiene una extensión de navegador web, así como un software de escritorio que es fácil para las personas para extraer datos de los sitios web.

PROS

Ejecutarse en tu navegador Chrome o Edge como extensión

Localizar y extraer automáticamente datos de páginas web

SLA garantizado y excelente servicio al cliente

Puedes ver datos, código fuente, estadísticas e informes en el portal del cliente

CONS

Solo en la nube, SaaS, basado en web

Falta de tutoriales, no tiene videos

1 note

·

View note

Text

Las 20 Mejores Herramientas de Web Scraping para 2021

Herramienta Web Scraping (también conocido como extracción de datos de la web, web crawling) se ha aplicado ampliamente en muchos campos hoy en día. Antes de que una herramienta de scraping llegue al público, es la palabra mágica para personas normales sin habilidades de programación. Su alto umbral sigue bloqueando a las personas fuera de Big Data. Una herramienta de web scraping es la tecnología de captura automatizada y cierra la brecha entre Big Data y cada persona.

Enumeré 20 MEJORES web scrapers incluyen sus caracterísiticas y público objetivo para que tomes como referencia. ¡Bienvenido a aprovecharlo al máximo!

Tabla de Contenidos

¿Cuáles son los beneficios de usar técnicas de web scraping?

20 MEJORES web scrapers

Octoparse

Cyotek WebCopy

HTTrack

Getleft

Scraper

OutWit Hub

ParseHub

Visual Scraper

Scrapinghub

Dexi.io

Webhose.io

Import. io

80legs

Spinn3r

Content Grabber

Helium Scraper

UiPath

Scrape.it

WebHarvy

ProWebScraper

Conclusión

¿Cuáles son los beneficios de usar técnicas de web scraping?

Liberar tus manos de hacer trabajos repetitivos de copiar y pegar.

Colocar los datos extraídos en un formato bien estructurado que incluye, entre otros, Excel, HTML y CSV.

Ahorrarte tiempo y dinero al obtener un analista de datos profesional.

Es la cura para comercializador, vendedores, periodistas, YouTubers, investigadores y muchos otros que carecen de habilidades técnicas.

1. Octoparse

Octoparse es un web scraper para extraer casi todo tipo de datos que necesitas en los sitios web. Puedes usar Octoparse para extraer datos de la web con sus amplias funcionalidades y capacidades. Tiene dos tipos de modo de operación: Modo Plantilla de tarea y Modo Avanzado, para que los que no son programadores puedan aprender rápidamente. La interfaz fácil de apuntar y hacer clic puede guiarte a través de todo el proceso de extracción. Como resultado, puedes extraer fácilmente el contenido del sitio web y guardarlo en formatos estructurados como EXCEL, TXT, HTML o sus bases de datos en un corto período de tiempo.

Además, proporciona una Programada Cloud Extracción que tle permite extraer datos dinámicos en tiempo real y mantener un registro de seguimiento de las actualizaciones del sitio web.

También puedes extraer la web complejos con estructuras difíciles mediante el uso de su configuración incorporada de Regex y XPath para localizar elementos con precisión. Ya no tienes que preocuparte por el bloqueo de IP. Octoparse ofrece Servidores Proxy IP que automatizarán las IP y se irán sin ser detectados por sitios web agresivos.

Octoparse debería poder satisfacer las necesidades de rastreo de los usuarios, tanto básicas como avanzadas, sin ninguna habilidad de codificación.

2. Cyotek WebCopy

WebCopy es un web crawler gratuito que te permite copiar sitios parciales o completos localmente web en tu disco duro para referencia sin conexión.

Puedes cambiar su configuración para decirle al bot cómo deseas capturar. Además de eso, también puedes configurar alias de dominio, cadenas de agente de usuario, documentos predeterminados y más.

Sin embargo, WebCopy no incluye un DOM virtual ni ninguna forma de análisis de JavaScript. Si un sitio web hace un uso intensivo de JavaScript para operar, es más probable que WebCopy no pueda hacer una copia verdadera. Es probable que no maneje correctamente los diseños dinámicos del sitio web debido al uso intensivo de JavaScript

3. HTTrack

Como programa gratuito de rastreo de sitios web, HTTrack proporciona funciones muy adecuadas para descargar un sitio web completo a su PC. Tiene versiones disponibles para Windows, Linux, Sun Solaris y otros sistemas Unix, que cubren a la mayoría de los usuarios. Es interesante que HTTrack pueda reflejar un sitio, o más de un sitio juntos (con enlaces compartidos). Puedes decidir la cantidad de conexiones que se abrirán simultáneamente mientras descarga las páginas web en "establecer opciones". Puedes obtener las fotos, los archivos, el código HTML de su sitio web duplicado y reanudar las descargas interrumpidas.

Además, el soporte de proxy está disponible dentro de HTTrack para maximizar la velocidad.

HTTrack funciona como un programa de línea de comandos, o para uso privado (captura) o profesional (espejo web en línea). Dicho esto, HTTrack debería ser preferido por personas con habilidades avanzadas de programación.