#definizione del software open source

Text

Scopri la Demo di ATutor LMS e Padroneggia la Sua Installazione su Ubuntu con Webmin

Cos'è ATutor LMS ? Scuole, organizzazioni non profit e aziende possono trarre vantaggio da un sistema di gestione dell'apprendimento che può aiutare i membri dello staff a fare da mentore, guidare gli studenti nei compiti a casa, tenere traccia dei progressi e dei successi per t [...] https://is.gd/VW2WkO

#business #communication #data #education #ict #information #intelligence #technology - Created by David Donisa from Academypedia.info

#accessibilità#adattabilità#corsi online#definizione del software open source#gestione del sistema di apprendimento#LMS#server VPS#software open source#software open source e gratuito#Ubuntu#vantaggi del software open source#Webmin#Tecnologie dell'informazione e della comunicazione (TIC)#Tutorial

0 notes

Text

Un amico ti ha prestato una chiavetta con all’interno alcuni film MKV ma non riesci a riprodurli sul tuo computer perché Windows Media Player (su Windows) o QuickTime Player (su macOS) non sembrano “digerirli”? Non ti preoccupare è un problema che si può risolvere in una manciata di clic e senza spendere un centesimo.Quello che devi fare è rivolgerti alle soluzioni ad hoc che sto per segnalarti, funzionanti senza necessitare di codec esterni. Questo significa che dovrai semplicemente dargli “in pasto” il video da guardare e goderti lo spettacolo. Scommetto che rimarrai stupito dalla loro incredibile facilità di utilizzo.Come dici? Hai provato a riprodurre un video in formato MKV anche sul tuo smartphone o sul tuo tablet ma non ci sei riuscito? Forse hai utilizzato un’applicazione incompatibile con questo tipo di file, o forse stai provando a riprodurre un video in alta definizione e il tuo device non è abbastanza potente da riuscirci. Fra poco proveremo ad aggirare anche questa difficoltà. Adesso, però, mettiamo le chiacchiere da parte ed entriamo subito nel vivo della guida! Buona lettura!IndiceInformazioni preliminariPrima di andare al sodo, ossia prima di spiegarti come riprodurre i film MKV sui tuoi dispositivi, mi sembra doveroso chiarirti le idee sul formato di file in questione.Qualora non sapessi di che cosa si tratta, i file MKV, vale a dire i file in formato Matroska, corrispondono prevalentemente a contenuti video nei quali è possibile trovare anche tracce audio, sottotitoli e capitoli: si tratta, dunque, di un formato “contenitore”, progettato con l’obiettivo di permettere la visualizzazione dei contenuti di riferimento su tutte le piattaforme software e di agevolare lo streaming su Internet.I file nel formato in questione, inoltre, sono compatibili con un gran numero di tracce native. Per essere più precisi, all’interno dei file MKV si possono trovare video di tipo MPEG-2 e 4, WMV, RealVideo, Flash, Theora, VP8, VP9, H.264 e H.265; audio di tipo MP2, MP3, PCM, AAC, WMA, Vorbis, AC3, RealAudio, DTS e FLAC; e sottotitoli di tipo VobSub, PGS, OGG Writ, WebVTT, ASS, SSA, USF e SRT.Film MKV: come vederliFatte le dovute precisazioni di cui sopra, veniamo all’azione e andiamo a scoprire, in dettaglio, come vedere i film MKV su tutti i dispositivi: computer, smartphone o tablet, TV e console di gioco. Per ulteriori dettagli, prosegui pure nella lettura, trovi spiegato tutto qui di seguito.Film MKV su PCPer vedere film MKV sul tuo PC, ti consiglio l’uso di VLC. Nel caso in cui non ne avessi mai sentito parlare, si tratta di un diffuso e apprezzato media player, totalmente gratuito e di natura open source, capace di riprodurre praticamente qualsiasi tipo di formato audio e video, inclusi i file MKV, senza necessitare di codec esterni.Per effettuarne il download sul tuo PC, visita il sito Internet del programma e fai clic sul pulsante Scarica VLC. A download ultimato, apri il file .exe ottenuto e segui le indicazioni su schermo per installarlo. Maggiori info qui.A questo punto, il più dovrebbe essere fatto: trascina sulla finestra di VLC il film MKV di tuo interesse e aspetta che ne venga avviata la riproduzione. In alternativa, puoi aprire il video facendo clic sul menu File situato in alto a sinistra, selezionando la voce Apri e, in seguito, il file di tuo interesse.Per gestire la riproduzione del filmato, puoi usare i controlli appositi visibili nella parte in basso della finestra del player: ci trovi i pulsanti per andare avanti e indietro nel film, quello per mettere in pausa o in stop la riproduzione e il bottone per accedere all’elenco dei file in scaletta. Ci sono, inoltre, la barra d’avanzamento, quella per la regolazione del volume e il pulsante per abilitare la visualizzazione a tutto schermo.Se vuoi, puoi anche fare in modo che tutti i file in formato MKV si aprano automaticamente con VLC: per riuscirci, fai clic destro con il mouse su un file MKV e clicca sulla voce Proprietà presente nel menu che compare. Nella

finestra che si apre, clicca quindi sul pulsante Cambia e seleziona VLC dall’elenco delle applicazioni disponibili. Maggiori info qui.VLC a parte, ci sono anche altri player multimediali che consentono di riprodurre i film in formato MKV, come nel caso di quelli che ti ho segnalato nella mia rassegna dedicata ai programmi per MKV. Altre risorse utili allo scopo le trovi poi nel mio articolo sui programmi per vedere video.Vedere film MKV su MacNon sai come vedere film MKV su Mac? Semplice, basta utilizzare VLC anche qui. Puoi rifarti facilmente alle indicazioni che ti ho già dato.In alternativa, puoi rivolgerti a IINA, un ottimo player gratuito e open source che supporta tutti i principali tipi di file multimediali, MKV compresi.Per scaricarlo, collegati al suo sito ufficiale e clicca sul pulsante Download, dunque apri il file dmg ottenuto e trascina l’icona del programma nella cartella Applicazioni.Ora non ti resta che aprire IINA, trascinarci sopra il video da riprodurre e godertelo. In alternativa, puoi aprire un video con IINA tramite il menu del clic destro o impostandolo come programma predefinito per i file MKV. Per fare questo, fai clic destro su un file MKV e vai su Ottieni informazioni che si trova nel menu contestuale, dunque scegli IINA dal menu a tendina Apri con (espandi questa sezione della finestra delle proprietà se non vedi alcun menu a tendina) e premi Modifica tutti, per salvare i cambiamenti.Se cerchi altri programmi per video sul Mac, ti lascio alla mia guida sul tema.Film MKV su AndroidHai trasferito un film MKV sul tuo smartphone o tablet Android e vorresti capire a quale risorsa affidarti per poterlo riprodurre? Se le cose stanno così, ti comunico che, anche in tal caso, puoi contare su VLC.Il famoso player multimediale per PC di cui ti parlavo nelle righe precedenti, infatti è disponibile anche sotto forma di app per i dispositivi basati sulla piattaforma mobile di Google. È gratis, facile da usare e presenta praticamente le stesse caratteristiche della controparte per computer.Per effettuarne il download sul tuo dispositivo, collegati alla relativa sezione del Play Store e fai tap sul bottone Installa. In seguito, premi sul pulsante Apri comparso sullo schermo oppure sull’icona di VLC appena aggiunta al drawer, in modo tale da avviare l’app.Ora che visualizzi la schermata principale dell’applicazione, premi sul menu Sfoglia che trovi in basso, poi vai alla ricerca del file multimediale da riprodurre. Una volta trovato, facci tap sopra e poi premi il pulsante Play che si trova in alto.In alternativa, puoi aprire i film MKV di tuo interesse con VLC usando un gestore di file o qualsiasi altra app: per riuscirci, ti basta selezionare il file di tuo interesse, poi ti dovrebbe apparire una finestra che ti chiede con quale app vuoi aprire tale file. Qui fai clic sull’icona di VLC seguito dalla voce Sempre (se desideri che questo file venga sempre aperto da VLC) e goditi la riproduzione.Una volta avviato il film, potrai servirti dei comandi situati nella parte in basso del player, visibili facendo tap sullo schermo, per gestirne la riproduzione. Per la precisione, ci trovi la barra d’avanzamento e i pulsanti per bloccare l’orientamento dello schermo, attivare e gestire i sottotitoli, mettere in pausa o riprendere la riproduzione, modificare il formato di visualizzazione e accedere alle altre opzioni più avanzate.VLC a parte, puoi riprodurre i tuoi film MKV su Android anche ricorrendo all’impiego di altri player multimediali, come quelli che ti ho segnalato nella mia rassegna dedicata ai migliori player per Android e nel mio post sulle app per video.Film MKV su iPad e iPhoneVLC è disponibile anche per iPhone e iPad e, anche in tal caso, può essere impiegato per riprodurre i film MKV. La versione dell’app per iOS e iPadOS presenta praticamente le stesse caratteristiche di quella per Android e il suo funzionamento è estremamente semplice.Per effettuarne il download sul tuo dispositivo, accedi alla relativa sezione

dell’App Store, pigia prima sul pulsante Ottieni, poi su quello Installa e autorizza il download tramite Face ID, Touch ID o password dell’ID Apple.Una volta completata la procedura d’installazione di VLC, per avviare la riproduzione di un film in formato MKV, apri il gestore di file che in genere usi su iPhone o iPad o comunque l’app all’interno della quale è salvato il file di tuo interesse, seleziona quest’ultimo, sfiora l’icona per la condivisione (in genere è quella che raffigura un quadrato con una freccia) e seleziona l’icona di VLC dal menu ti viene mostrato.In seguito, potrai servirti dei comandi situati nella parte in alto e in basso della schermata, visibili facendo tap sul display, per gestire la riproduzione. Più precisamente, in cima ci trovi la barra d’avanzamento e il pulsante per modificare la modalità di visualizzazione, mentre in basso ci sono la barra di regolazione del volume, il pulsante per la riproduzione tramite AirPlay, quello per andare avanti e indietro nel filmato e quello per mettere in pausa e in stop il video. Ci trovi anche i bottoni per regolare la velocità di riproduzione, il formato dell’immagine e per accedere alle impostazioni avanzate. Se cerchi altri player per dispositivi mobili Apple li trovi nella mia guida su come mettere film su iPhone e nel mio articolo su come guardare film su iPad.Film MKV su TVSe, invece, ti interessa capire come riprodurre film MKV sul TV, ti comunico che la cosa è facilmente attuabile sfruttando la porta USB presente sul retro oppure lateralmente su tutti i moderni televisori (copiando quindi i file da riprodurre su una chiavetta USB o un hard disk esterno).Una volta collegato il dispositivo d’archiviazione, questo verrà riconosciuto in maniera automatica dal televisore e sullo schermo dell’apparecchio verrà visualizzato il menu con i contenuti presenti su quest’ultimo. Su alcuni TV, invece, viene prima visualizzato un messaggio, che consente, se selezionato, di accedere alla sezione dedicata al media player.Se, invece, non compare alcun messaggio e il menu per gestire i contenuti multimediali non si avvia in automatico, per raggiungere quest’ultimo, provvedi prima a prima selezionare l’ingresso relativo alla presa USB dalle impostazioni del televisore.Successivamente, seleziona Film tra le varie tipologie di contenuti che possono essere riprodotti, premi sul pulsante del telecomando per accedere ai contenuti della chiavetta o dell’hard disk, seleziona il film MKV da guardare e premi sul bottone per avviarne la riproduzione. Per maggiori dettagli, puoi consultare la mia guida su come vedere la chiavetta USB sul TV (valida anche per gli hard disk).Se poi possiedi uno Smart TV dotato di un player di rete, puoi riprodurre anche i film MKV presenti su un NAS, sul computer o su un hard disk di rete. Per la riproduzione dei contenuti dal computer, puoi sfruttare le funzioni di rete di Windows o macOS oppure software ad hoc, come ad esempio Plex, capaci di trasformare il PC in un media server, come ti ho spiegato nella mia guida su come usare Plex su Smart TV. In linea di massima, per riuscirci, basta attivare la condivisione dei file e assicurarsi che il televisore sia collegato alla medesima rete del computer o del disco esterno.In alternativa, per riprodurre i film in MKV (e non solo) sul tuo televisore puoi rivolgerti a un set-top box oppure a un dongle, cioè dei dispositivi da collegare esternamente al TV, i quali consentono di aggiungere funzioni Smart ed extra a quest’ultimo, mediante l’uso di applicazioni e l’accesso alla Rete.Tra i vari device parte della categoria, io ti suggerisco di valutare l’uso di un TV box Android, del Chromecast di Google, del Fire TV Stick prodotto da Amazon e dell’Apple TV.Film MKV su PS4 e PS5Possiedi una PS4 e ti interessa capire come usare quest’ultima per riprodurre i tuoi film in formato MKV? Ti spiego subito in che modo procedere. Il formato in oggetto, infatti è perfettamente supportato dalla console di casa Sony e, per di più, la riproduzione dello stesso non è affatto complicata.

Per compiere l’operazione in questione, puoi scegliere di trasferire i tuoi fil MKV su un hard disk esterno oppure su una chiavetta USB da collegare poi alla PS4. Per procedere, recati poi nella schermata iniziale della PlayStation 4 e premi il pulsante X del controller sopra alla voce Lettore Multimediale.In seguito, collega il dispositivo di archiviazione esterno da te scelto a una delle porte USB della console, seleziona il nome dell’hard disk o della chiavetta USB e premi il tasto X del controller sopra al contenuto che desideri riprodurre.Se, invece, il film MKV che vuoi guardare si trova su un hard disk di rete o su un NAS, verifica in primo luogo che la PS4 risulti connessa alla stessa rete del disco, dopodiché avvia il Lettore multimediale di PS4 e seleziona, usando il tasto X del pad, prima il nome del dispositivo di rete di tuo interesse e poi quello del film MKV che vuoi riprodurre.Puoi anche valutare di condividere in rete i film in formato MKV presenti sul computer oppure su un disco collegato al PC, come ti ho spiegato anche nel capitolo precedente, dedicato alla visione dei film MKV su TV.In tal caso, non dovrai far altro che avviare il Lettore multimediale della PS4 e accedere ai contenuti condivisi. Per ulteriori approfondimenti, ti rimando alla lettura del mio tutorial incentrato specificamente su come vedere film su PS4.Se hai una PS5, invece, collega una chiavetta o un disco esterno al PC, crea una cartella nella directory principale dell’unità e copia in quest’ultima i video MKV. Collega poi il drive alla console, vai su Galleria multimediale nella Home giochi della console, seleziona USB e scegli il video da riprodurre.Film AVI in MKVSe vuoi sapere come convertire file AVI in MKV, questi programmi non fanno al caso tuo. Ho una serie molto lunga di opzioni che servono proprio a questo, ma siccome ho già scritto una guida completa su come convertire MKV, ti rimando a quest’ultima.

Salvatore Aranzulla è il blogger e divulgatore informatico più letto in Italia. Noto per aver scoperto delle vulnerabilità nei siti di Google e

Microsoft. Collabora con riviste di informatica e cura la rubrica tecnologica del quotidiano Il Messaggero. È il fondatore di Aranzulla.it, uno dei

trenta siti più visitati d'Italia, nel quale risponde con semplicità a migliaia di dubbi di tipo informatico. Ha pubblicato per Mondadori e

Mondadori Informatica.

[ad_2]

Source link

0 notes

Text

Open innovation e collaborazioni con Università

https://aedic.eu/open-innovation-e-collaborazioni-con-universita/

Open innovation e collaborazioni con Università

Open Innovation

L’Open Innovation (OI) è un paradigma che afferma che le imprese possono e debbono fare ricorso a idee esterne, così come a quelle interne, ed accedere con percorsi interni ed esterni ai mercati se vogliono progredire nelle loro competenze tecnologiche.

Il primo a dare una definizione di OI è stato Henry Chesbrough, economista e autore statunitense che ha battezzato il nuovo concetto con un libro intitolato proprio “Open Innovation: The New Imperative for Creating and Profiting from Technology”, pubblicato nel 2003 dalla Harvard Business School Press.

Lo studioso rifletteva sul fatto che la globalizzazione avesse reso sempre più costosi e rischiosi i processi di ricerca e sviluppo, perché il ciclo di vita dei prodotti era diventato più breve.

Secondo Chesbrough, diventa maggiormente competitivo non chi produce al proprio interno le migliori innovazioni ma chi riesce a creare prodotti e servizi innovativi modulando al meglio ciò che viene da dentro e ciò che può ricavare dai player fuori dal perimetro aziendale. Le aziende che investono nell’innovazione aperta hanno semplicemente riconosciuto 2 cose:

nessuna azienda è in grado di sviluppare internamente tutta la tecnologia di cui ha bisogno;

i prodotti/servizi che realizzano devono funzionare bene con quelli prodotti da altre aziende, inclusi concorrenti diretti e aziende con modelli di business molto diversi, ad esempio fornitori di software open source.

Sono poche le grandi aziende che hanno una platea di risorse interne talmente ampia e funzionale da non necessitare di uno scambio con l’esterno. E anche queste si stanno rendendo conto che i contributi esterni rappresentano uno stimolo significativo e a volte essenziale.

Challenges per le PMI

Per le PMI che accedono a idee/tecnologie dall’esterno è importante:

avere capacità di assorbimento: essere in grado di portare dentro l’azienda, assorbire, integrare e fare proprio quello che arriva dall’esterno, facendolo diventare una parte della propria catena del valore.

Rilassare l’ansia di perdere informazioni segrete facendole uscire dal proprio recinto chiuso verso la concorrenza. La vera sfida dell’innovazione è nella implementazione.

Continuare a innovare: l’innovazione continua consente di essere sempre un passo avanti.

Sviluppare regole del gioco chiare e ben definite in anticipo (cosa offro e cosa perdo; cosa porto a casa a fronte di quale rischio) ben definite in anticipo (codificare il processo).

Ciò premesso, è importante prestare attenzione alla formalizzazione di relazioni che la PMI instaura con partner esterni attraverso contratti tra impresa e dipendenti volti a regolamentare i comportamenti di questi ultimi. Queste clausole sono importanti perché:

possono impedire ai lavoratori di entrare alle dipendenze di un’azienda coinvolta nello stesso business della prima o di diventare egli stessi un concorrente dell’azienda (contratto di non competizione).

Possono stabilire vincoli di segretezza volti ad assicurare la riservatezza di idee, segreti industriali e altre informazioni e materiali confidenziali (NDA o accordi di riservatezza).

Possono regolare il trasferimento dei diritti delle invenzioni frutto del lavoro del personale.

Strumenti per praticare l’Open Innovation

Challenge based innovation, hackathon e crowdsourcing

Una PMI con poche risorse per l’innovazione e scarse competenze in materia, può iniziare con strumenti come challenge based innovation, hackathon e crowdsourcing.

Tutto si costruisce intorno ad una challenge (sfida, problema alla ricerca di una soluzione) promossa da una o più imprese alla ricerca di una soluzione a un problema.

La challenge viene gestita da organizzazioni specializzate (spesso enti di intermediazione che hanno contatti con università per coinvolgere studenti, anche di dottorato, nell’esercizio) o dalle università stesse, attraverso ricercatori esperti di design thinking e business development.

Altra modalità è rappresentata dagli hackathon, gare di programmazione, durante le quali si chiede a sviluppatori e programmatori di creare soluzioni digitali innovative relative a un determinato settore in un arco di tempo circoscritto (24 o 48 continuative, in generale). Le soluzioni devono sempre essere in risposta ad una challenge/sfida. Infine, il crowdsourcing utilizza gruppi di persone sfruttando l’intelligenza collettiva per fare innovazione. Esistono diverse tipologie:

crowd contest (competizioni);

crowd collaborative communities (i partecipanti possono condividere e mixare le idee);

crowd complementors (partire da una tecnologia ed elaborarla creando innovazione);

crowd labor market (una sorta di mercato on-demand per cercare chi è in grado di fornire la soluzione a un determinato problema.

Corporate acceleration e corporate entrepreneurship

Esistono strutture specializzate (agenzie regionali, incubatori, acceleratori, uffici per il trasferimento tecnologico) nella cosiddetta corporate acceleration.

Partendo da esigenze specifiche di una impresa committente, queste strutture vanno a vedere quali start-up e imprese innovative possono offrire una soluzione adeguata.

Queste strutture, per imprese di più grandi dimensioni, possono essere interne e offrono programmi interni di corporate acceleration con strutture organizzative di proprietà, il cui obiettivo è identificare soluzioni innovative che possono anche sfociare nella creazione di nuovi mercati, nuovi business, con la costituzione di nuove imprese o con l’acquisizione di start-up di nuova creazione.

Acquisizioni

L’acquisizione, da parte di imprese medio-grandi, di startup o PMI innovative è considerato uno degli strumenti principali per fare OI. Le aziende che rilevano la maggioranza delle quote delle nuove imprese si assicurano in un colpo solo idee, tecnologie e competenze. In diversi casi l’acquisizione comporta anche l’assunzione dei soci e/o dipendenti della startup, per mantenere una continuità con la gestione precedente e integrare nel proprio organico i talenti digitali individuati.

Partnership

Un altro percorso di OI riguarda la possibilità di stringere accordi con partner esterni.

Accordi inter-aziendali, per cui un’impresa delega a un’altra, di solito più piccola, la creazione di determinate innovazioni o la produzione di specifici manufatti.

Partnership e rapporti di collaborazione con università, centri di ricerca o gruppi di ricercatori.

Collaborazioni di innovation procurement,creando una filiera con i propri fornitori per sviluppare soluzione innovative.

Focus su collaborazioni Università-impresa: cosa serve

Le Università possono avere un ruolo centrale nel favorire l’innovazione delle piccole imprese. Tuttavia esistono diversi fattori che ostacolano collaborazioni efficaci:

il focus su ricerca esplorativa e di lungo termine;

la logica istituzionale del mondo della ricerca;

il focus sullo sviluppo e valorizzazione a mercato, sulla velocità e l’orizzonte di breve termine che caratterizza l’operato di molte imprese/PMI;

negoziazione della proprietà intellettuale nella collaborazioni di ricerca con le Università ed Enti Pubblici di Ricerca.

Come superare questi ostacoli? Quali suggerimenti per le PMI e per le Università?Suggerimenti per le PMI:

abbandonare l’approccio all’impresa familiare;

investire di più sulla formazione dei dipendenti e sulla riqualificazione delle competenze (formazione continua, up-skilling e re-skilling);

assunzione di laureati e persone con il dottorato;

considerare dottorato industriale e finanziamento di assegni di ricerca;

creare incentivi interni per l’apertura e collaborazione con Università.

Suggerimenti per le Università:

creare strutture interne (punto di ingresso) per aspiranti imprese che cercano forme di collaborazione;

essere visibili e raggiungibili;

investire in professionisti (capitale umano);

investire in comunicazione di risultati di ricerche valorizzabili a mercato, con taglio anche divulgativo finalizzato all’impatto;

promuovere (anche attraverso incentivi interni a percorsi di carriera accademici) il coinvolgimento di ricercatori e dottorandi in progetti di ricerca con le imprese per generare impatto;

elaborare un portafoglio di attività oggetto di collaborazione con l’impresa che vada oltre la ricerca (formazione professionalizzante, workshop, coinvolgimento di imprenditori nella didattica, organizzazione di seminari congiunti, trasferimento tecnologico, placement, open innovation, ecc.);

sviluppare (insieme ad associazioni di imprese) nuovi curricula, percorsi di studio in linea con le aspettative delle PMI (Lauree Professionalizzanti).

Riferimenti bibliografici e web

Aldieri L., Esternalità di conoscenza tra imprese, Giappichelli Editore

Chesbrough, H. 2003. Open Innovation. Harvard Business School Press

Grant, R.M. 2020. L’analisi strategica per le decisioni aziendali. IlMulino

Pisano, G. 2015. You need an innovation strategy, Harvard Business Review

Porter, M. 2011. Il vantaggio competitivo, Piccola biblioteca Einaudi

Università degli Studi di Palermo, La proprietà intellettuale

0 notes

Text

Quel pinguino amato che pensa di avere il mondo

5 vittorie e 5 sconfitte dei primi trent'anni di Linux. Il sistema operativo open source ha cambiato per sempre internet e l'industria del software ma non è riuscito a vincere alcune delle sue sfide più importanti.

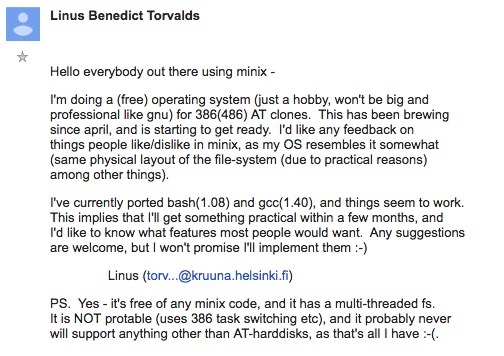

Trent’anni fa, il 25 agosto del 1991, un giovane studente finlandese mandò una storica email a un gruppo di sviluppatori hobbysti intitolata “Cosa vi piacerebbe vedere di più in Minix?”. Il giovane studente era Linus Torvalds e quell’email è considerata l’atto di nascita di Linux, il sistema operativo open source che da piccolo hobby di un gruppo di giovanissimi hacker all’alba di internet è diventata l’architrave della rete e uno dei tre progetti open source più di successo al mondo oltre che uno dei più grandi. Infatti, il kernel di Linux, cioè il motore del sistema operativo (e la parte comune a tutte le varie distribuzioni gratuite disponibili) è diventato un progetto da poco più di 27.8 milioni di righe di codice, a cui contribuisce un’armata di 14mila sviluppatori sparsi in tutto il mondo.

La storica email di Linus Torvalds per presentare la sua versione di Minix. L’idea di chiamare il sistema operativo Linux non è stata sua ma di alcuni volontari.

La scelta di Torvalds di sviluppare in maniera free, open e collaborativa il kernel di Linux ha consentito a un altro grande progetto open source, il sistema operativo Gnu, pensato da Richard Stallman ma che non riusciva a decollare, di trovare il suo motore e diventare un rimpiazzo gratuito per Unix, all’epoca “il” sistema operativo (a pagamento) usato sui server e nei centri di calcolo.

Trent’anni dopo, però, cos’è successo? Si fa presto a dire che Linux ha vinto: in realtà ha anche perso alcune grandi battaglie. La sua valutazione di mercato era di 3,89 miliardi di dollari nel 2019 (secondo Fortune), il suo valore cresce del 19,2% all’anno (Cagr) e nel 2027 raggiungerò il traguardo dei 15,64 miliardi di dollari. Al tempo stesso, la sua quota di mercato nel settore desktop e portatili è attorno al 2,38%, il doppio di Chrome Os (che non sommiamo perché pur essendo basato su Linux ha uno strato proprietario di servizi di Google) ma molto sotto i due principali sistemi operativi “closed source”: Windows (73%)e macOs (15,4%). Insomma, dopo trent’anni Linux ha sicuramente vinto ai punti ma non per ko. Vediamo perché.

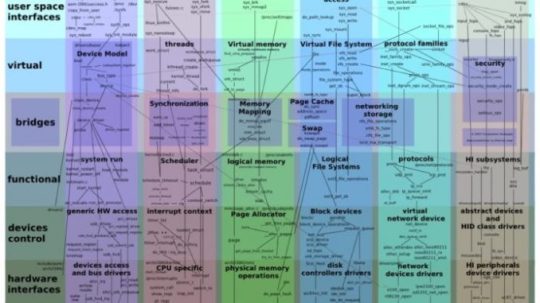

La mappa del kernel di Linux (fonte Wikipedia)

Le 5 grandi vittorie

1 – Il sistema operativo più diffuso oltre al pc

Linux ha sdoganato l’idea che possa esistere un sistema operativo open. Nel mondo del software questa è stata la seconda grande rivoluzione dopo quella di Microsoft degli anni Settanta (cioè che il software ha più valore dell’hardware). L’importanza di essere aperti fin nei dettagli (e non fornire solo delle Apie delle specifiche di sviluppo per le terze parti) è la ricetta segreta del successo di Linux e la cosa che gli ha permesso di essere estremamente efficace per la costruzione di strumenti sofisticatissimi.

Non a caso Linux è la piattaforma standard per una marea di apparecchi e strumenti digitali oltre ai pc e ai server: dal router di casa all’auto della Tesla, dalla webcam alle fotocamere digitali. Il mondo dell’embedded è quasi totalmente Linux e questo è possibile perché tutti hanno potuto lavorare al suo sviluppo e verificare che funzioni. Oggi i grandi sviluppano linguaggi di programmazione (Go, Swift), framework, middleware open source per continuare a sfruttare il valore di essere open. L’apertura completa è la versione “fatta bene” della cosiddetta Api Economy, che invece si basa sul monopolio dei servizi esposti dai fornitori.

2 – Linux è Gnu

L’idea del free software o del software open arriva prima di Linux: Richard Stallman è stato il suo ideologo ma non è riuscito a trasformarla in una proposizione vincente sul mercato. C’è riuscito Torvalds con Linux, che ha ridato vita al progetto Gnu di Stallman diventandone il motore e insieme ad Apache è il vero grande diffusore dell’idea del free software (ma non chiedetelo a Stallman perché lui vi dirà di no).

Linux ha sdoganato l’idea che i software open non sono solo degli hobby ma anche degli strumenti scientifici e industriali sofisticati.

3 – Internet ama Linux

L’infrastruttura di internet è storicamente basata su server Unix e sistemi di routing dei dati che hanno utilizzato Unix o altri sistemi operativi proprietari. Tuttavia, è con l’arrivo di Linux che si è sviluppato il “vero” paradigma di internet: senza Linux milioni di startup non avrebbero potuto entrare in affari, da piccolissimi provider che hanno portato per la prima volta la connettività nelle case di milioni di persone negli anni Novanta ai primi servizi e aziende online.

Linux (logo da Wikipedia)

Per esempio, il motore di ricerca di Google esisterebbe solo come tesi di dottorato se non fosse stato possibile riciclare migliaia e migliaia di vecchi pc con Linux per trasformarli nella prima, grande “server farm”. Se Microsoft o Apple volessero sviluppare da zero Linux dovrebbero investire almeno 14,7 miliardi di dollari in stipendi di programmatori per riuscirci.

4 – Un mondo standard

Trent’anni fa, quando è nato Linux, c’erano decine di versioni di Unix incompatibili tra loro. È una fase dello sviluppo della tecnologia che viene chiamato “guerra degli Unix” e che ha segnato profondamente quella storia che non si studia sui banchi di scuola o all’università, e tuttavia è critica per lo sviluppo di interi settori industriali oggi dipendenti dal digitale. Linux ha introdotto una varietà di possibili utilizzi con un unico sistema operativo sempre aperto e compatibile, a cui tutti hanno potuto contribuire. Qualcosa di più di uno standard aperto.

5 – Il futuro del cloud

L’idea di “macchine virtuali” è molto vecchia, è nata negli anni Sessanta in Ibm. E quella di internet come sistema operativo è dei geni di Sun Microsystems (“The network is the computer“). Ma se guardiamo a tutte le tecnologie del cloud che negli ultimi cinque anni hanno radicalmente trasformato internet, cioè i container e i microservizi, l’unico punto in comune è che sono tutte basate su Linux.

La piattaforma creata da Torvalds è quella che permette anche la trasformazione nel modo con il quale si costruisce il software online e offline: DevOps, Ci/Cd (le pratiche combinate di integrazione continua e distribuzione continua del software) e tutti i flussi di lavoro e le tecnologie che oggi permettono il funzionamento di servizi come Google Cloud e Netflix si basano su innovazioni rese possibili, in ultima analisi, da Linux.

Le 5 sconfitte di Linux

Le sconfitte di Linux sono politiche, non tecnologiche. Ma non per questo bruciano meno. E in alcuni casi ci vuole un attimo per capire perché il sistema operativo nato per essere il campione del mondo open source sia in realtà diventato lo strato gratuito di alcune delle più grandi piattaforme proprietarie

1 – Pochissimo mercato desktop

Nonostante lo sforzo dei volontari e la passione europea (soprattutto in Germania) per l’uso dei sistemi operativi e dei software open source per la pubblica amministrazione, in realtà Linux non ha mai sfondato nel mondo dei personal computer, cioè dei sistemi operativi per la produttività personale. La sua quota di mercato è relativamente molto piccola ed è poco diffuso.

Ed è un vero peccato, perché ci sono distribuzioni mirate che sono più facili da usare di Windows, ambienti con desktop manager e gestori del sistema strutturati per essere come, se non meglio, di quelli di macOS. Però alla fine chi compra un pc lo fa con Windows già caricato a bordo, oppure prende un Mac. Che, oggi, con il nuovo chip proprietario Apple Silicon, è diventato un po’ meno compatibile con Linux di prima (ma non temete: la community ci sta lavorando). In conclusione: la promessa di avere Linux nei personal computer della metà degli utenti del pianeta non si è realizzata. Peccato.

2 – Non è più veramente “open”

Linux ha perso anche una battaglia ideologica molto importante: il sistema operativo “open” e “free” per definizione, alfiere di un sistema in cui tutti possono vedere il codice sorgente del software e modificarlo a piacimento, è diventato la base di una serie di piattaforme chiuse. E questo non è un bene.

La licenza di distribuzione e d’uso di Linux non è stata pensata per impedire che, per esempio, Google lo usi sui suoi server e sui telefoni Android, Amazon sul suo cloud, Ibm sui suoi server. Però gli utilizzatori di Linux in questo caso lo sfruttano per costruire piattaforme proprietarie. Il lavoro gratuito di migliaia e migliaia di sviluppatori volontari è stato usato per arricchire i proprietari del codice e Linux è diventato (anche) una commodity che fa il gioco dei big tech, senza ricevere niente in cambio.

3- L’influenza (negativa) dei big del tech

Chi sono i più grandi contributori del codice del kernel di Linux e delle varie componenti open source? La leggenda vuole che siano studenti e giovani programmatori volontari di tutto il pianeta che, mossi dalla loro etica, si dedicano gratuitamente al grande progetto “open”. Non è più così.

La realtà invece è che grandi aziende come Intel, Ibm, Samsung, Oracle, Google, Amazon e da qualche tempo anche Microsoft (ma non dimentichiamoci di Hp e decine di altri) pagano i loro dipendenti per lavorare in orario di ufficio a Linux e completare una serie di componenti del kernel e di altre parti del sistema operativo open. Diventando anche responsabili di determinate aree o di nuovi progetti. Lo scopo? È riassunto nel vecchio detto: “Se non puoi combatterli, unisciti a loro“.

A 21 anni, Torvalds era un vero geek e come tale si è comportato: ha creato il suo sistema operativo, lo ha messo in Rete e ha chiesto ai suoi simili di partecipare al suo sviluppo. Parliamo di Linux, ovviamente (foto: AFP)

Intel, Ibm, Microsoft e tutti gli altri vogliono che Linux vada nella direzione tecnologica che conviene a loro, che supporti le loro tecnologie e hardware, che insomma sia un sistema fatto a loro immagine e somiglianza. Così, i Linux Day (e gli Install Day), i vecchi appassionati che girano a fare proseliti e insegnare ai “newbie” come installare Ubuntu o la Debian e le altre attività della community di volontari (compresi gli adesivi gratuiti che gli studenti appiccicano sul coperchio del loro pc) sono diventati una specie di facciata folkloristica.

4 – Spaghetti code

L’espressione, chiariamolo subito, è provocatoria e palesemente esagerata: “spaghetti code” era il termine usato negli anni Settanta e successivi per indicare programmi il cui codice sorgente era confuso e confusionario, soprattutto per l’uso del goto al posto dei costrutti della programmazione strutturato. Lo sviluppo di Linux gestito ancora da Linus Torvalds è fantastico, ma non così il mondo delle distribuzioni e soprattutto la documentazione per gli utenti finali. Là regna il caos.

Accanto ad alcune distribuzioni “maggiori” che curano particolarmente la documentazione, c’è un vero e proprio spezzatino in cui trovare la tecnologia o l’informazione che serve diventa un incubo. Senza contare che le distribuzioni e i software open collegati vanno a mode: per un periodo hanno centinaia di sviluppatori e poi vengono abbandonate, lasciando gli utenti finali nei pasticci.

5 – Il kernel sbagliato

Quando Linus Torvalds ha deciso di creare Linux, era all’università e l’ha fatto in polemica con un famoso professore di sistemi operativi, Andrew S. Tanenbaum, una specie di superstar del settore nonché il creatore del sistema operativo “didattico” Minix, che era una alternativa accademica nettamente migliore di Unix. Al centro della scelta per l’architettura di Linux fatta da Torvalds c’è stata quella di sviluppare un kernel di tipo monolitico (anche se poi modularizzato).

Invece, Tanenbaum aveva e ha dimostrato che l’approccio opposto, cioè con un micro-kernel, è superiore e avrebbe reso Linux molto più efficace e più adatto sia ai processori multicore (che nel 1991 non erano ancora una opzione) e in prospettiva per i servizi distribuiti nel cloud. Linux ha vinto una battaglia che sarebbe stato meglio aver perso.

Read the full article

#apple#chrome#cloudcomputing#Debian#elettronica#ElettronicaOpenSource#google#ibm#informatica#intel#Internet#kernel#LinusTorvalds#Linux#macos#microsoft#Minix#opensource#telecomunicazioni#Ubuntu#windows

0 notes

Text

CMS: problemi e come risolverli

Oggi parliamo di siti internet in Wordpress e di CMS, ovvero del content managment system. Vediamo insieme di cosa si tratta e cosa fare quando capita qualche problema di funzionamento.

Cos'è il CMS?

Per chi non fosse del settore programmazione software o gestione siti internet, il CMS è il Content Management System.

Stiamo parlando di software che facilitano la gestione di siti internet a coloro che se li costruiscono da soli e che successivamente li utilizzano svincolando il lavoro degli addetti del mestiere: i webmaster.

Il Webmaster è colui che costruisce un sito. Sul web si trovano molte piattaforme in grado di costruire siti open source tramite CMS.

Generalmente offrono un'interfaccia di amministrazione, anche definita "admin console" (console di amministrazione) con cui l'amministratore può gestire ogni aspetto del sito web, senza il bisogno di possedere conoscenze tecniche particolari di programmazione Web.

Problemi di gestione dei CMS

In un approccio sistematizzato alla gestione dei contenuti di un sito, i CMS si occupano di identificare gli utenti del sito e i relativi ruoli di produzione o fruizione dei contenuti stessi.

In sostanza controllano e coordinano ciò che viene inserito nel sito ed assegnano responsabilità e permessi a differenti categorie di utenti per distinti tipi di contenuti.

Spesso, a causa della definizione delle attività di flusso di lavoro, quindi di formalizzazione di un percorso per l'assemblaggio del sito finale, si riscontrano problemi di gestione dovuti alla produzione frammentaria dei contenuti inseriti.

Ecco che, mentre il sito mano mano dovrebbe acquisire la sua unitarietà sottostando ad opportune procedure di supervisione, spesso la comunicazione tra i vari livelli gerarchici viene meno e diviene difficile il tracciamento e la gestione delle varie versioni del contenuto.

Mancanza di pubblicazione e definizione

Per i motivi sopra descritti, spesso si trovano online siti internet costruiti male, o la cui costruzione sembra lasciata a metà.

Non solo. Spesso in questi siti non si riesce ad individuare e definire un reale piano editoriale e i contenuti non vengono nemmeno pubblicati anche se obiettivamente programmati al momento della creazione del sito stesso.

Principalmente questi problemi accadono con siti costruiti con piattaforme open source, come ad esempio Wordpress.

Se non si acquista un dominio e non si hanno i plug-in giusti, insorgono problemi con la pubblicazione dei contenuti del sito e i CMS non lavorano come dovrebbero. Questo accade quasi sempre quando si fa l'aggiornamento del software del sito o del tema che abbiamo scelto per realizzarlo.

Il CMS Wordpress

Come abbiamo accennato, Wordpress è una piattaforma CMS. Forse la più utilizzata per creare autonomamente il proprio sito.

Visto quanto è amata dal pubblico di internet è chiaro che sia un ottimo CMS, ma come abbiamo visto non è perfetto e può creare problemi di gestione, soprattutto a coloro che non sono esperti di programmazione.

Detto questo, è importante usufruire di un servizio di assistenza clienti di hosting web cui potersi affidare per risolvere le eventuali problematiche che possono insorgere nella gestione del proprio sito internet (soprattutto se si effettuano aggiornamenti costanti).

In sostanza, quello che vi serve è un provider di hosting che sia in grado di risolvere i vostri problemi e gli errori di Wordpress in modo immediato. Oppure un'agenzia web che si occupa di installazione, configurazione e supporto, un esempio può essere Enkey.

Vantaggi e limiti dei CMS

Concludiamo parlando dei pro e dei contro dei CMS. Punto primo permettono di costruire e aggiornare un sito dinamico, anche piuttosto grande, senza necessità di scrivere in linguaggio HTML.

Non si deve quindi conoscere uno dei linguaggi di programmazione lato server o progettare un apposito database.

Progettare un sito da soli utilizzando un CMS open source è facile, ma crea problemi sul medio-lungo periodo.

Vi basterà seguire le indicazioni della piattaforma di costruzione, dando alle pagine del vostro sito un aspetto personalizzato scegliendo un foglio di stile CSS progettato appositamente per il CMS scelto (nel caso del nostro esempio per Wordpress).

In genere le modifiche alle pagine dovranno seguire regole precise, dettate dagli sviluppatori della piattaforma.

I vantaggi possono sembrare limitati e non lasciano molte scelte in merito alla costruzione del sito. Ecco perché la community degli informatici crede che in realtà i siti costruiti in CMS open source, senza seguire le procedure richieste per personalizzazioni, porteranno sicuramente a mal funzionamenti soprattutto nel medio-lungo periodo.

Ed ecco che arriviamo a parlare di quelli che sono i limiti dei CMS. Non sono specializzati e non potendo spesso intervenire sul codice sorgente dei contenuti bloccano molte delle funzioni base del sito.

Infine, sono lenti, spesso perché non vengono associati ad un buon servizio di hosting e utilizzano plug-in gratuiti ma non validi e/o non aggiornati.

Read the full article

#cms#cmsinwordpress#comecostruireunsitogratis#design#gestionesitiinternet#sitointernetgratis#wordpress

0 notes

Text

Risk Assessment: identificazione, analisi e valutazione del rischio

Questo articolo fa parte di una serie di approfondimenti dedicata al Risk Management ed è dedicato alle metodologie di identificazione, analisi e valutazione del rischio: in altre parole parleremo delle attività di Risk Assessment, che convenzionalmente corrispondono alle fasi 2 e 3 in cui si scompone l'insieme dei processi di gestione del rischio, subito dopo l'analisi del contesto e necessarie per dar vita alle successive azioni di Risk Treatment e impostare le conseguenti attività di Risk Monitoring.

Definizione

Come sempre in questi casi è opportuno partire dalle definizioni: secondo quella ufficiale fornita dalla ISO/IEC 27000 la Valutazione del Rischio (Risk Assessment) è il processo complessivo di identificazione, analisi e ponderazione del rischio: in altre parole, l'insieme di attività volte a identificare i rischi (ossia gli asset, le minacce e le vulnerabilità), calcolarne il livello e deciderne il trattamento.

E' importante considerare che tale definizione non riguarda unicamente la valutazione del rischio per la sicurezza delle informazioni, ma ha una valenza generale a prescindere dal contesto: è dunque valida anche all'analisi dei rischi strategici, finanziari, sulla sicurezza dei lavoratori, sulla privacy e in qualsiasi altro ambito.

La valutazione dei rischi è un processo necessariamente iterativo e che va ripetuto (continuous improvement), in quanto il contesto oggetto di analisi tenderà inevitabilmente a cambiare nel corso del tempo. Le best practices suggeriscono inoltre di partire da una analisi di alto livello, ovvero senza scendere troppo nei dettagli: in altre parole, di cominciare a curare gli aspetti strategici (alto livello), per poi scendere ad approfondire quelli tattici (medio livello): questo consentirà di affrontare in modo omogeneo le diverse funzioni da analizzare e di produrre un set di regole comuni, eliminando carenze che potrebbero rendere inefficace - e inutilmente dispendiosa in termini di tempi e costi - una analisi operativa (basso livello) effettuata troppo presto. Questo approccio è particolarmente importante nelle iniziative di valutazione del rischio connesse alla sicurezza delle informazioni, dove si commette di frequente l'errore di confondere il Risk Assessment con il Vulnerability Assessment con conseguenze negative non banali dal punto di vista metodologico e organizzativo.

L'importanza di iniziare con analisi "meno accurate" ma più veloci è certificata anche da diversi studi (cfr. Information and Software Technology, Jorgensen Magne 2010), secondo i quali questo approccio porta molto di frequente ad risultati del tutto paragonabili a quelli di indagini molto più approfondite, ma a previsioni meno ottimistiche e dunque a un approccio più prudente: il che, in un contesto come quello della sicurezza delle informazioni, non è certo una cosa negativa.

Livello di Rischio

La prima cosa da fare quando ci si trova di fronte alla necessità di valutare un rischio è stabilirne il livello, ovvero classificarlo mediante l'adozione di una scala di grandezza oggettiva. La ISO/IEC 27001, dedicata alla gestione della sicurezza delle informazioni e caratterizzata da un risk-based approach, propone di utilizzare una misurazione basata sul livello di rischio, inteso come "la grandezza di un rischio espresso come combinazione delle sue conseguenze e della loro verosimiglianza".

Per comprendere al meglio questa definizione è utile chiarire il significato di conseguenze e verosimiglianza:

- Conseguenze: l'impatto di un possibile evento.

- Verosimiglianza: la probabilità che un evento si verifichi.

I termini impatto e probabilità risultano probabilmente più intuitivi, cosa che nel corso del tempo ne ha ha favorito la diffusione e l'utilizzo al di fuori della normativa ISO 27001. A prescindere da come li si chiama, è importante comprendere che il livello di rischio corrisponde al prodotto di impatto e probabilità. Ovviamente, l'impatto e la probabilità vanno anch'essi calcolati, a seconda della presenza e incidenza di variabili positive (es. controlli di sicurezza) e negative (es. vulnerabilità note).

Si pensi, ad esempio, al livello di rischio legato al possibile furto del contenuto di una valigia in un aereoporto:

- la presenza di oggetti di grande valore all'interno del bagaglio aumenterà l'impatto del rischio, ma non avrà alcun effetto sulla probabilità;

- l'assenza di una serratura che impedisce l'apertura del bagaglio aumenterà sensibilmente la probabilità che il furto si verifichi, ma non avrà conseguenze di rilievo sull'impatto;

- la presenza di telecamere di sorveglianza nelle zone dove si trova e/o transita il bagaglio diminuirà la probabilità che il furto si verifichi, senza però variarne l'impatto se non in misura marginale (l'autore del furto potrebbe avere meno tempo a disposizione);

Come si può facilmente comprendere, la presenza di oggetti di grande valore e l'assenza di serratura sono elementi di vulnerabilità rispetto all'impatto e/o alla probabilità del rischio, mentre le videocamere di sorveglianza sono dei controlli di sicurezza che hanno lo scopo di ridurre le suddette variabili.

Valutazione del Rischio

Sulla base di quanto detto finora è possibile elencare i seguenti parametri di valutazione del rischio:

- Il contesto, inteso come la situazione in cui vengono valutati i rischi;

- l'asset e il suo valore, da cui dipendono le conseguenze ovvero l'impatto del rischio;

- la minaccia (threat) e le sue caratteristiche, tra cui soprattutto la verosimiglianza o probabilità che ha di avere luogo;

- il complesso di vulnerabilità e controlli di sicurezza a disposizione e la loro robustezza (intesa nel senso di efficacia), che è necessario conoscere in quanto possono alterare in modo rilevante l'impatto e la probabilità del rischio.

E' importante sottolineare la differenza tra evento (event), incidente (incident) e minaccia (threat). In estrema sintesi, prendendo come riferimento le definizioni fornite dalla ISO/IEC 27000, è possibile fornire la seguente formulazione: l'evento è una situazione che si verifica realmente e che può comportare una violazione; l'incidente è una particolare tipologia di evento che si riferisce a una situazione non voluta/inattesa che si verifica realmente e che ha una probabilità significativa di comportare una violazione; la minaccia è una causa potenziale di un incidente, ovvero un possibile evento che però non si è ancora verificato.

Una volta calcolato il livello di rischio è necessario prendere delle decisioni su come affrontarlo (Risk Treatment). Tra le tante possibili strategie di trattamento, le più importanti sono:

- la prevenzione (non perdere mai di vista il bagaglio);

- la riduzione (aumentare i controlli e/o ridurre le vulnerabilità);

- il trasferimento (assicurare il contenuto della valigia);

- l'accettazione (considerare il rischio "accettabile" e procedere senza bisogno di compiere ulteriori azioni);

Per maggiori dettagli sul trattamento dei rischi consigliamo di leggere il nostro approfondimento sul Risk Treatment.

Requisiti di validità

Proviamo ora a mettere a fuoco i requisiti richiesti a una metodologia di Risk Assessment per essere considerato valido, ovvero capace di fornire risultati credibili, verosimili ed affidabili:

- completezza: le valutazioni devono essere esaustive, ovvero analizzare tutti gli asset, le minacce e le vulnerabilità.

- ripetitibilità: valutazioni condotte nello stesso contesto e nelle stesse condizioni devono dare gli stessi risultati.

- comparabilità: valutazioni condotte nello stesso contesto e in momenti diversi devono fornire output comparabili, così da poter capire se il rischio è cambiato e in che misura;

- coerenza: il livello di rischio deve essere calcolato in modo tale per cui, a fronte di un incremento dei valori di asset, minacce e vulnerabilità più alti di altri, anch'esso risulti più elevato (e viceversa);

Applicativi software

L'utilizzo di un software per effettuare le valutazioni del rischio e/o per "censire" i rischi e i relativi valori e parametri può certamente essere una buona scelta, a patto che la scelta sia effettuata in modo consapevole e che i vantaggi superino gli svantaggi spesso connessi a tale scelta.

Ecco un elenco non esaustivo dei principali aspetti negativi che l'adozione di un software di Risk Management o Risk Assessment può comportare all'interno di una organizzazione:

- Perdita di tempo, non di rado dovuta alla quantità di dati da inserire e/o alla formazione da effettuare alle risorse che dovranno occuparsi del data entry; e, come sappiamo, in un contesto di Risk Assessment che riguarda la sicurezza delle informazioni il tempo è letteralmente denaro; per questo motivo è opportuno scegliere software semplici e immediati.

- Opacità dei metodi di calcolo, che si traduce quasi certamente nell'impossibilità di verificare in modo oggettivo la coerenza dei risultati di cui abbiamo parlato nel paragrafo precedente; per risolvere questo problema è consigliabile scegliere software open source o quantomeno caratterizzati da un elevato livello di trasparenza rispetto agli algoritmi utilizzati;

- Rigidità dei parametri, che potrebbero non consentire l'inserimento arbitrario di asset, minacce o vulnerabilità importanti;

- Rigidità operativa, dovuta al fatto che l'operatore incaricato sarà naturalmente portato a "sedersi" su quanto offerto dal software e a "forzare" l'organizzazione oggetto di analisi nelle categorie e tipologie previste dagli standard presentati; al contrario, la valutazione dei rischi va compiuta adattando e personalizzando il metodo al proprio contesto.

Secondo l'opinione autorevole di molti analisti, l'utilizzo di un software molto generico (ad es. un normale foglio elettronico come MS Excel o Google Spreadsheet) consente di mettersi al riparo dalla maggior parte di questi "rischi" senza rinunsciare a numerosi automatismi utili, risultando quindi un'ottimo compromesso. Nel caso in cui si preferisca comunque dotarsi di un software apposito consigliamo di consultare il catalogo ENISA (Inventory of Risk Management / Risk Assessment Tools), che descrive 12 strumenti utilizzando un modello di comparazione costituito da 22 attributi che descrivono le caratteristiche di ciascuno di essi.

Conclusioni

Per il momento è tutto: ci auguriamo che questa panoramica sul Risk Assessment possa essere utile ai manager, auditor e amministratori di sistema che sono chiamati ad affrontare quotidianamente queste attività per aumentare il livello di sicurezza della propria organizzazione.

Read the full article

0 notes

Text

TOR e VPNs

Spesso le definizioni di TOR e VPNs vengono confuse oppure mal interpretate. Con questo post vorrei chiarire la loro definizione e le loro sostanziali differenze.

Nei precedenti post è stato accennato all’uso dei TOR. L’acronimo TOR sta per “The Onion Router” e nasce per mascherare l’indirizzo IP dei militari della marina ma una volta che loro passarono ai sistemi VPN (molto più sicuri), TOR fu rilasciato come un software open source, completamente legale e accessibile a tutti. Come si collega allora un software legale al Deep Web? Essendo una rete multi-proxy, TOR usa le connessioni degli altri utenti per mascherare il proprio indirizzo IP; grazie ai più di tre milioni di utenti è impossibile risalire all’indirizzo IP di chi sta usando il browser TOR. È facile capire che mascherare il proprio dispositivo è molto utile se si vuole passare inosservati e soprattutto se si vuole accedere ad alcuni servizi segreti disponibili solo dagli utenti di TOR, solitamente illegali e appartenenti al Deep Web.

Figura: logo del software TOR; Fonte: torproject.org

Bisogna sottolineare però che TOR non è usato solo dagli hacker, ma la maggior parte dei suoi utenti ne usufruisce proprio perché è perfettamente legale farlo e permette loro di essere completamente anonimi. In questo modo si è invisibili a quelle compagnie che vendono i dati degli utenti per favorire inserzioni e annunci pubblicitari più simili “ai propri gusti” che in realtà sono basati proprio sulle nostre ricerche online, oppure si possono aggirare le restrizioni che vengono imposte dal proprio paese su alcuni tipi di contenuti.

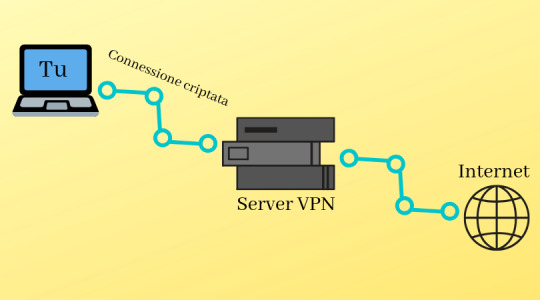

Il servizio VPN (Virtual private Network) si basa sullo stesso principio di TOR: permette di accedere ad Internet nascondendo la tua connessione e le tue ricerche, il server collegato al VPN client cripta i tuoi dati prima che la tua connessione Internet li legga.

Fonte: the-dark-side-of-the-web.tumblr.com

I protocolli dei VPN definiscono come i server usano i dati che vengono trasmessi tramite questo servizio, ce ne sono di diversi tipi ma generalmente alcuni di essi permettono delle connessioni più sicure. In quasi tutti i Paesi è legale usare VPNs ma in alcune parti dell’Asia ancora non lo è.

Una delle prime differenze che si riscontrano tra TOR e VPNs è che a differenza del primo, alcuni dei servizi VPN sono a pagamento tramite abbonamenti spesso non troppo costosi che ne garantiscono l’efficienza. Infatti, il servizio VPN si basa sulla fiducia che l’utente ripone in lui nel criptare i suoi dati e non rivenderli a terze parti mentre TOR non è controllato da nessuna organizzazione e l’utente non si affida a nessuno di specifico per ottenere la garanzia dell’anonimato.

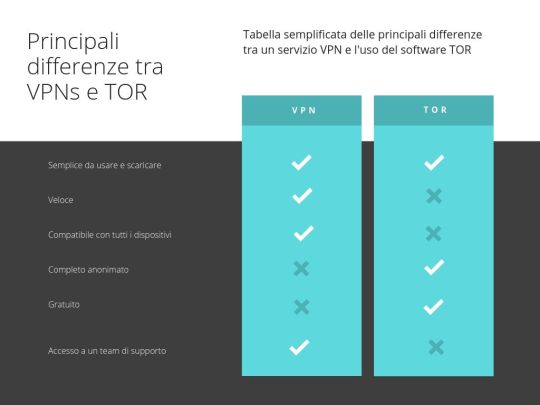

Ecco di seguito una semplice tabella che riassume le differenze tra questi due servizi:

Fonte: the-dark-side-of-the-web.tumblr.com

In conclusione, possiamo affermare che entrambi i servizi sono validi e nessuno dei due è superiore all’altro ma semplicemente soddisfano bisogni diversi.

Chiara My

0 notes

Text

Open innovation e collaborazioni con Università

New Post has been published on https://aedic.eu/open-innovation-e-collaborazioni-con-universita/

Open innovation e collaborazioni con Università

Open Innovation

L’Open Innovation (OI) è un paradigma che afferma che le imprese possono e debbono fare ricorso a idee esterne, così come a quelle interne, ed accedere con percorsi interni ed esterni ai mercati se vogliono progredire nelle loro competenze tecnologiche.

Il primo a dare una definizione di OI è stato Henry Chesbrough, economista e autore statunitense che ha battezzato il nuovo concetto con un libro intitolato proprio “Open Innovation: The New Imperative for Creating and Profiting from Technology”, pubblicato nel 2003 dalla Harvard Business School Press.

Lo studioso rifletteva sul fatto che la globalizzazione avesse reso sempre più costosi e rischiosi i processi di ricerca e sviluppo, perché il ciclo di vita dei prodotti era diventato più breve.

Secondo Chesbrough, diventa maggiormente competitivo non chi produce al proprio interno le migliori innovazioni ma chi riesce a creare prodotti e servizi innovativi modulando al meglio ciò che viene da dentro e ciò che può ricavare dai player fuori dal perimetro aziendale. Le aziende che investono nell’innovazione aperta hanno semplicemente riconosciuto 2 cose:

nessuna azienda è in grado di sviluppare internamente tutta la tecnologia di cui ha bisogno;

i prodotti/servizi che realizzano devono funzionare bene con quelli prodotti da altre aziende, inclusi concorrenti diretti e aziende con modelli di business molto diversi, ad esempio fornitori di software open source.

Sono poche le grandi aziende che hanno una platea di risorse interne talmente ampia e funzionale da non necessitare di uno scambio con l’esterno. E anche queste si stanno rendendo conto che i contributi esterni rappresentano uno stimolo significativo e a volte essenziale.

Challenges per le PMI

Per le PMI che accedono a idee/tecnologie dall’esterno è importante:

avere capacità di assorbimento: essere in grado di portare dentro l’azienda, assorbire, integrare e fare proprio quello che arriva dall’esterno, facendolo diventare una parte della propria catena del valore.

Rilassare l’ansia di perdere informazioni segrete facendole uscire dal proprio recinto chiuso verso la concorrenza. La vera sfida dell’innovazione è nella implementazione.

Continuare a innovare: l’innovazione continua consente di essere sempre un passo avanti.

Sviluppare regole del gioco chiare e ben definite in anticipo (cosa offro e cosa perdo; cosa porto a casa a fronte di quale rischio) ben definite in anticipo (codificare il processo).

Ciò premesso, è importante prestare attenzione alla formalizzazione di relazioni che la PMI instaura con partner esterni attraverso contratti tra impresa e dipendenti volti a regolamentare i comportamenti di questi ultimi. Queste clausole sono importanti perché:

possono impedire ai lavoratori di entrare alle dipendenze di un’azienda coinvolta nello stesso business della prima o di diventare egli stessi un concorrente dell’azienda (contratto di non competizione).

Possono stabilire vincoli di segretezza volti ad assicurare la riservatezza di idee, segreti industriali e altre informazioni e materiali confidenziali (NDA o accordi di riservatezza).

Possono regolare il trasferimento dei diritti delle invenzioni frutto del lavoro del personale.

Strumenti per praticare l’Open Innovation

Challenge based innovation, hackathon e crowdsourcing

Una PMI con poche risorse per l’innovazione e scarse competenze in materia, può iniziare con strumenti come challenge based innovation, hackathon e crowdsourcing.

Tutto si costruisce intorno ad una challenge (sfida, problema alla ricerca di una soluzione) promossa da una o più imprese alla ricerca di una soluzione a un problema.

La challenge viene gestita da organizzazioni specializzate (spesso enti di intermediazione che hanno contatti con università per coinvolgere studenti, anche di dottorato, nell’esercizio) o dalle università stesse, attraverso ricercatori esperti di design thinking e business development.

Altra modalità è rappresentata dagli hackathon, gare di programmazione, durante le quali si chiede a sviluppatori e programmatori di creare soluzioni digitali innovative relative a un determinato settore in un arco di tempo circoscritto (24 o 48 continuative, in generale). Le soluzioni devono sempre essere in risposta ad una challenge/sfida. Infine, il crowdsourcing utilizza gruppi di persone sfruttando l’intelligenza collettiva per fare innovazione. Esistono diverse tipologie:

crowd contest (competizioni);

crowd collaborative communities (i partecipanti possono condividere e mixare le idee);

crowd complementors (partire da una tecnologia ed elaborarla creando innovazione);

crowd labor market (una sorta di mercato on-demand per cercare chi è in grado di fornire la soluzione a un determinato problema.

Corporate acceleration e corporate entrepreneurship

Esistono strutture specializzate (agenzie regionali, incubatori, acceleratori, uffici per il trasferimento tecnologico) nella cosiddetta corporate acceleration.

Partendo da esigenze specifiche di una impresa committente, queste strutture vanno a vedere quali start-up e imprese innovative possono offrire una soluzione adeguata.

Queste strutture, per imprese di più grandi dimensioni, possono essere interne e offrono programmi interni di corporate acceleration con strutture organizzative di proprietà, il cui obiettivo è identificare soluzioni innovative che possono anche sfociare nella creazione di nuovi mercati, nuovi business, con la costituzione di nuove imprese o con l’acquisizione di start-up di nuova creazione.

Acquisizioni

L’acquisizione, da parte di imprese medio-grandi, di startup o PMI innovative è considerato uno degli strumenti principali per fare OI. Le aziende che rilevano la maggioranza delle quote delle nuove imprese si assicurano in un colpo solo idee, tecnologie e competenze. In diversi casi l’acquisizione comporta anche l’assunzione dei soci e/o dipendenti della startup, per mantenere una continuità con la gestione precedente e integrare nel proprio organico i talenti digitali individuati.

Partnership

Un altro percorso di OI riguarda la possibilità di stringere accordi con partner esterni.

Accordi inter-aziendali, per cui un’impresa delega a un’altra, di solito più piccola, la creazione di determinate innovazioni o la produzione di specifici manufatti.

Partnership e rapporti di collaborazione con università, centri di ricerca o gruppi di ricercatori.

Collaborazioni di innovation procurement,creando una filiera con i propri fornitori per sviluppare soluzione innovative.

Focus su collaborazioni Università-impresa: cosa serve

Le Università possono avere un ruolo centrale nel favorire l’innovazione delle piccole imprese. Tuttavia esistono diversi fattori che ostacolano collaborazioni efficaci:

il focus su ricerca esplorativa e di lungo termine;

la logica istituzionale del mondo della ricerca;

il focus sullo sviluppo e valorizzazione a mercato, sulla velocità e l’orizzonte di breve termine che caratterizza l’operato di molte imprese/PMI;

negoziazione della proprietà intellettuale nella collaborazioni di ricerca con le Università ed Enti Pubblici di Ricerca.

Come superare questi ostacoli? Quali suggerimenti per le PMI e per le Università?Suggerimenti per le PMI:

abbandonare l’approccio all’impresa familiare;

investire di più sulla formazione dei dipendenti e sulla riqualificazione delle competenze (formazione continua, up-skilling e re-skilling);

assunzione di laureati e persone con il dottorato;

considerare dottorato industriale e finanziamento di assegni di ricerca;

creare incentivi interni per l’apertura e collaborazione con Università.

Suggerimenti per le Università:

creare strutture interne (punto di ingresso) per aspiranti imprese che cercano forme di collaborazione;

essere visibili e raggiungibili;

investire in professionisti (capitale umano);

investire in comunicazione di risultati di ricerche valorizzabili a mercato, con taglio anche divulgativo finalizzato all’impatto;

promuovere (anche attraverso incentivi interni a percorsi di carriera accademici) il coinvolgimento di ricercatori e dottorandi in progetti di ricerca con le imprese per generare impatto;

elaborare un portafoglio di attività oggetto di collaborazione con l’impresa che vada oltre la ricerca (formazione professionalizzante, workshop, coinvolgimento di imprenditori nella didattica, organizzazione di seminari congiunti, trasferimento tecnologico, placement, open innovation, ecc.);

sviluppare (insieme ad associazioni di imprese) nuovi curricula, percorsi di studio in linea con le aspettative delle PMI (Lauree Professionalizzanti).

Riferimenti bibliografici e web

Aldieri L., Esternalità di conoscenza tra imprese, Giappichelli Editore

Chesbrough, H. 2003. Open Innovation. Harvard Business School Press

Grant, R.M. 2020. L’analisi strategica per le decisioni aziendali. IlMulino

Pisano, G. 2015. You need an innovation strategy, Harvard Business Review

Porter, M. 2011. Il vantaggio competitivo, Piccola biblioteca Einaudi

Università degli Studi di Palermo, La proprietà intellettuale

0 notes

Text

Open Badge - Cosa sono, come funzionano e come crearli

In questo articolo cercheremo di far luce sugli Open Badge, gli attestati digitali utilizzati a livello internazionale per certificare competenze e risultati che in questi ultimi anni stanno vivendo un periodo di grande diffusione anche all'interno del nostro paese.

Origini e sviluppo

Per comprendere il percorso che ha portato allo sviluppo del concetto di badge digitale e alla definizione dello standard Open Badge è necessario partire dall'oggetto fisico da cui deriva questa evoluzione: il badge fisico tradizionale, utilizzato per molti anni da varie organizzazioni come l'esercito russo, i Boy Scouts of America e altre organizzazioni militari e para-militari per dare ai membri un emblema fisico per mostrare i risultati raggiunti.

Mentre i badge fisici sono in uso da centinaia di anni, l'idea dei badge digitali è uno sviluppo relativamente recente, determinato in gran parte dal processo di gamification che ha investito il settore dei servizi, ridefinendo i rapporti tra i produttori di contenuti (videogiochi, editori, siti web, etc.) e i loro utenti. Nel corso degli ultimi decenni, soprattutto a seguito della diffusione di Internet e del Web, sono stati utilizzati da organizzazioni come Foursquare e Huffington Post per premiare utenti per l'esecuzione di determinati compiti. Nel 2005, Microsoft ha introdotto il sistema Gamerscore per Xbox 360, considerato l'implementazione originale di un sistema di successo: tale sistema prevede, tra le altre cose, l'assegnazione di una serie di achievement - specifici per ciascun gioco o contenuto della console - che il sistema ha la possibilità di assegnare a ciascun giocatore a seguito del conseguimento di un determinato obiettivo.

Secondo Shields & Chugh, i badge digitali stanno rapidamente diventando un modo appropriato, facile ed efficiente per educatori, gruppi di comunità e altre organizzazioni professionali di esibire e premiare i partecipanti per le competenze acquisite nello sviluppo professionale o nell'apprendimento formale e informale.

Dall'achievement alla certificazione

All'inizio del 2010, il fornitore di servizi di badge digitali Basno ha lanciato la prima piattaforma che ha consentito agli utenti di creare e collezionare badge relativi al conseguimento di obiettivi reali, come la corsa alla ING New York City Marathon (la famosa Maratona di New York) del 2011: un segnale molto forte che certifica il passaggio dalla concezione del badge come un traguardo di gioco al suo utilizzo come certificazione di un'esperienza realmente vissuta.

Come si può facilmente immaginare, il passaggio dall'esperienza all'apprendimento è stato breve: nel settembre 2011, la segretaria alla Pubblica Istruzione degli Stati Uniti, Arne Duncan, ha annunciato il lancio dei badge della Fondazione HASTAC / MacArthur per il concorso per l'apprendimento permanente. Finanziato dalla Fondazione MacArthur , con il supporto aggiuntivo della Gates Foundation, HASTAC gestisce i badge per il concorso per l'apprendimento permanente, che ha assegnato fondi a trenta organizzazioni nel marzo 2012.

La situazione attuale

A partire dal 2012 la diffusione dei badge digitali è stata costante, anche grazie all'arrivo di diverse piattaforme che hanno permesso ad aziende, enti e organizzazioni di qualsivoglia tipo di creare il proprio portfolio di badge digitali assegnabili ai loro dipendenti, clienti e collaboratori per certificare la loro partecipazione a corsi, seminari, meeting e workshop. Tra queste, vale la pena ricordare Badgr.com, una delle piattaformi più diffuse e semplici da utilizzare per la creazione e l'emissione di badge virtuali, nonché completamente open-source.

Ovviamente, non sono mancati tentativi di sfruttare la componente "motivazionale" insita nei badge digitali per ottenere risultati misurabili in termini di business, come ad esempio l'incremento della produttività aziendale: un obiettivo che ha finito per dare alla luce una intera categoria di servizi, come Orcaso.io e GetBadges, che si concentrano proprio su questo aspetto, fornendo funzionalità di gamification non soltanto direttamente alle aziende, ma anche ai prodotti e servizi di terze parti di CRM e/o al project management (Trello, Jira, etc.).

Lo standard Open Badge

Nel 2011 Mozilla, la nota community di software libero nata nel 1998 dalle ceneri di Netscape Communications e creatrice del browser web Firefox e del client di posta elettronica Thunderbird, ha dato luce al progetto Mozilla Open Badges: si tratta di un modello infrastrutturale (Open Badge Infrastructure o OBI) pensato appositamente per il rilascio badge digitali che consentano di riconoscere le competenze di chi li riceve e, al tempo stesso, garantire la tracciabilità di chi li emette. L'infrastruttura è stata disegnata in modo aperto, consentendo così a qualsiasi piattaforma di implementare lo standard e fornire quindi servizi di emissione di Open Badge.

Gli Open Badge sono dunque indicatori digitali che certificano le conoscenze disciplinari, abilità personali (soft skills) e competenze tecniche acquisite. Sono costituiti da una parte grafica, una immagine distintiva, e da una serie di metadati: questi ultimi consentono di verificare l'assegnazione del badge e di accedere a tutti i contenuti descrittivi: competenza acquisita o un’abilità o un obiettivo raggiunto, il metodo utilizzato per verificarla, l’indicazione di chi l’ha rilasciata e l’identità di chi l’ha ottenuta, etc. Queste informazioni possono essere visualizzate in formato leggibile attraverso una URL univoca, solitamente comunicata all'interno della e-mail che attesta l'avvenuta emissione del badge, che consente di accedere alla pagina web dedicata al badge stesso sulla piattaforma utilizzata per l'emissione (badgr.com, bestr.it o altre). Il badge è in tal modo internamente verificabile in tutte le sue informazioni, oltre che garantiti dall’ente che li eroga.

Chi può rilasciare un Open Badge?

Gli Open Badge possono essere rilasciati da qualsiasi azienda, associazione, organizzazione, ente o persona fisica: l'assegnazione di un badge digitale è un atto di fiducia con cui il soggetto emittente (issuer) dichiara che il destinatario (learner) ha partecipato a un corso di formazione, preso parte a un'iniziativa formativa o sviluppato una competenza: i dettagli dell'esperienza vengono normalmente descritti all'interno del badge stesso e accessibili/verificabili secondo le modalità descritte nel paragrafo precedente.

I badge rilasciati sono garantiti dall'ente o società che li eroga e riconosciuti a livello internazionale: possono essere usati nei curricula elettronici e sui social network per comunicare in modo sintetico, rapido e credibile che cosa si è appreso, in che modo lo si è appreso e con quali risultati ai datori di lavoro di tutto il mondo. Le organizzazioni assegnano Badge (invece di attestati di partecipazione o titoli di studio) per dare evidenza di singole qualità o esperienze, che la persona può poi raggruppare e presentare costruendo la propria personale narrazione del proprio profilo professionale.

Riferimenti Utili

https://openbadges.org/ - Open Badge Project

http://openbadges.it/ - Comunità italiana sugli OpenBadges.

Conclusioni

Per il momento è tutto: ci auguriamo che questa panoramica possa essere utile a quanti erano alla ricerca di maggiori informazioni sul mondo degli Open Badge.

Se siete alla ricerca di corsi di formazione che rilascino attestati virtuali in standard open badge, vi suggeriamo di dare un'occhiata ai nostri corsi di formazione IT, che prevedono proprio l'emissione di un open badge al loro completamento.

Read the full article

0 notes

Text

Cos'è una VPN, come funziona, e perché è importante averne una

Negli ultimi anni il mondo del web è stato oggetto di un incremento esponenziale delle minacce informatiche: hacker, malware, ransomware, phishing e molti altri espedienti di natura malevola mettono quotidianamente a rischio la sicurezza di chiunque utilizzi internet: dall'utente meno smaliziato al professionista informatico, dalla piccola ditta individuale alla grande azienda internazionale, nessuno può definirsi realmente al sicuro. Per questo motivo è diventato molto importante dotarsi sia della necessaria consapevolezza su questo tipo di minacce che, soprattutto, degli opportuni strumenti di contenimento dei rischi connessi alla navigazione online.

Come è certamente noto a molti lettori, esistono una serie di strumenti di protezione che oggi come oggi sono - giustamente - considerati pressoché essenziali:

Antivirus: un essenziale strumento di prevenzione e rimozione delle principali minacce informatiche provenienti dai cosiddetti malware: parliamo dunque di virus, trojan, ransomware, rootkit e qualsiasi altro strumento informatico programmato con il preciso intento di far compiere al nostro device attività o operazioni al di fuori del nostro controllo. Per maggiori informazioni riguardo a questo tipo di minacce, consigliamo di leggere alcuni dei numerosi articoli che abbiamo pubblicato sul tema:

Ransomware, Rootkit, Trojan e Worm: come difendersi?

Come eliminare Malware, Virus, Trojan e Worm dal proprio sistema

Cryptolocker, Locky e altri Ransomware: come recuperare i dati senza pagare il riscatto

Firewall: strumento fondamentale per proteggere la vostra macchina da tutti gli attacchi basati su connessioni non autorizzate o tentativi di compromissione del traffico dati (DDoS Attacks, packet forgery, man-in-the-middle, etc.). Può essere installato sia come una stand-alone appliance che- se non potete permettervi una macchina dedicata - come strumento di protezione software.

Software e/o strategie di Data Encryption: il metodo più efficace per garantire la protezione costante dei nostri dati in-transit, at-rest e/o end-to-end. Per maggiori informazioni sulle varie tipologie di crittografia ad oggi disponibili, suggeriamo di dare un'occhiata all'articolo Data Encryption in-transit, at-rest, end-to-end: definizioni e best practice.

In questo articolo non approfondiremo ulterioremnte questi argomenti, per i quali rimandiamo ai riferimenti sopra indicati. Ci occuperemo invece di introdurre un ulteriore strumento di protezione, particolarmente importante per chiunque sia interessato a rendere la propria esperienza di navigazione online più sicura: il suo nome è VPN, acronimo di Virtual Private Network.

Definizione

Per prima cosa, cerchiamo di comprendere il significato della sigla VPN: abbiamo già detto che si tratta di un acronimo per Virtual Private Network, ovvero un network privato che consente a uno o più computer (o network) esterni di connettersi in modo sicuro e accedere alle proprie risorse. Queste ultime, a seconda dei casi, possono riguardare l'accesso ad altre macchine (o periferiche, o dispositivi) connessi a loro volta al medesimo network privato, e/o alla connessione internet del network stesso.

La connessione tra un singolo client e una VPN viene talvolta chiamata client-to-site, mentre quella tra due network VPN è nota come site-to-site.

Tipologie di VPN

Al giorno d'oggi, quando si parla di VPN, ci si riferisce solitamente a una di due possibili tipologie di servizio:

Le VPN on-premise, ovvero installate e configurate su infrastruttura di rete propria o della azienda presso cui si lavora, questo tipo di VPN, solitamente installate tramite un Firewall con supporto VPN, un router con supporto VPN o un server VPN vero e proprio, vengono utilizzate per fornire a client, server e/o network esterni un modo sicuro per connettersi a un Local Area Network (LAN) personale o aziendale: si tratta di una tipologia di utilizzo molto comune nelle aziende che abbiano implementato al loro interno forme relativamente evolute di smart working o lavoro da postazione remota e/o che necessitino di stabilire connessioni permanenti e sicure con server farm esterne tramite internet. Questa tipologia di VPN prevede solitamente l'utilizzo di tecnologie, protocolli e algoritmi standard, che consentono la connessione mediante la maggior parte dei client VPN esistenti in commercio (a patto ovviamente che supportino quegli stessi standard).

Le VPN as-a-service, ovvero servizi acquistabili online mediante il pagamento di una fee periodica (solitamente mensile o annuale), il cui scopo principale è quello di occultare l'identità dell'utente mascherandone l'indirizzo IP e consentendogli quindi di accedere a internet in modo anonimo e sicuro, evitando restrizioni geografiche o altre limitazioni legate all'IP e/o al paese di provenienza. Questi servizi utilizzano nella maggior parte dei casi tecnologie, protocolli e algoritmi proprietari, che rendono necessario o altamente preferibile l'utilizzo di un client VPN specifico. Questo client è solitamente fornito dal servizio VPN stesso per le principali piattaforme (Windows, OSX, Android, etc.).