#przetwarzanie

Text

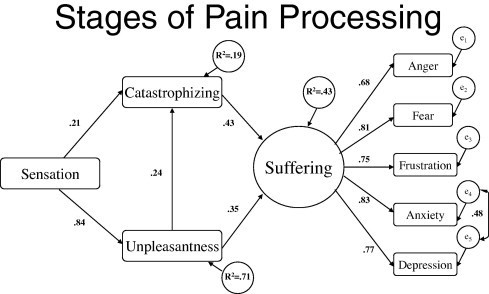

Chart: stages of processing pain.

0 notes

Text

Przetwarzanie i Ponowne Wykorzystanie: Odnawianie Starych Mebli i Dekoracji

W świecie, gdzie coraz bardziej ceniona jest zrównoważoność i kreatywność, przetwarzanie i ponowne wykorzystywanie starych mebli i dekoracji stało się popularnym sposobem na ożywienie zmęczonych przedmiotów oraz redukcję odpadów. Zamiast pozbywać się starych elementów, rozważ ich przekształcenie w coś pięknego i funkcjonalnego. Oto kilka pomysłów na przetwarzanie i ponowne wykorzystywanie starych mebli i dekoracji:

1. Restauracja Mebli: Nadaj starym meblom świeży wygląd poprzez ich szlifowanie, malowanie lub lakierowanie. Możesz także wymienić zużyte tapicerki lub elementy wykończeniowe, aby odświeżyć mebel i dopasować go do obecnego stylu dekoracyjnego.

2. Kreatywne Rozwiązania Przechowywania: Przekształć stare skrzynie, walizki lub kosze w unikalne rozwiązania przechowywania. Układaj skrzynie w stosy, aby stworzyć regały, zamień walizki w stoliki nocne lub zawieś kosze na ścianie, aby stworzyć stylową organizację.

3. Projekty z Odzyskanych Drewna: Wykorzystaj odzyskane drewno ze starych mebli lub palet do tworzenia nowych przedmiotów. Zbuduj rustykalny stolik kawowy, odzyskane drewniane łóżko lub zestaw półek dla urokliwego wyglądu.

4. Lampa z Przysłowiowej Świnki: Przemień stare słoiki, butelki lub metalowe puszki w lampy wiszące lub lampki stołowe. Dodaj warstwę farby lub ozdób, aby dopasować je do swojego wystroju, i zainstaluj zestaw oświetleniowy, aby ukończyć przemianę.

5. Rękodzieło z Wintageowych Tekstyliów: Przetwórz wintageowe tekstylia, takie jak obrusy, serwetki lub zasłony, w nowe elementy dekoracyjne. Wykonaj z nich pokrowce na poduszki, torby na zakupy lub ozdoby na ścianę, aby dodać nutę nostalgii i uroku.

6. Sztuka Ogrodowa: Przekształć stare narzędzia ogrodnicze, donice lub nawet meble w wesołą sztukę ogrodową. Namaluj kolorowe wzory na starych łopatach lub grablach, wykorzystaj ceramiczne donice jako donice na kwiaty, lub zamień stary ławek w centralny punkt Twojej przestrzeni na świeżym powietrzu.

7. Galeria Ram Obrazowych: Przeznacz stare ramy obrazowe na galerię na ścianie lub dekoracyjną ekspozycję. Pomaluj ramy w spójnych kolorach, wypełnij je zdjęciami rodzinymi lub sztuką, i ułóż je kreatywnie na ścianie, aby dodać personalizacji.

8. Fuzja Mebli: Połącz różne elementy starych mebli, aby stworzyć coś zupełnie nowego. Na przykład przymocuj stare drzwi do zestawu szuflad, aby stworzyć unikalną konsolę wejściową, lub przekształć drabinę w regał na książki, dodając półki między biegi.

9. Ekologiczne Rękodzieło: Baw się ekologicznymi materiałami, takimi jak korek, tektura lub gazety, aby wykonać ręcznie robione przedmioty dekoracyjne. Stwórz podkładki z resztek korka, pleć kosze z pasków gazet, lub buduj rzeźby z recyklingowanej tektury.

10. Personalizowane Przetwarzanie: Pozwól swojej wyobraźni działać na całego i spersonalizuj swoje projekty przetwarzania, aby pasowały do Twojego gustu i stylu. Niezależnie od tego, czy dodajesz warstwę farby, przetwarzasz materiały, czy ozdabiasz unikalnymi detalami, zrób każdy przedmiot swoim.

Przez przetwarzanie i ponowne wykorzystywanie starych mebli i dekoracji, możesz stworzyć niepowtarzalne przedmioty, które odzwierciedlają Twoją osobowość, redukują odpady i dodają charakteru Twojemu domowi.

Odkryj inspiracje dla projektów przetwarzania i zrównoważonej dekoracji na xlmeble.pl. Poznaj szeroki wybór mebli i akcesoriów ekologicznych, aby podnieść swój dom stylem i zrównoważoną produkcją.

#Przetwarzanie Mebli#Odnawianie Starych Mebli#Kreatywne Recyklingowanie#Dekoracja Zrównoważona#Sztuka Upcyklingu#Rękodzieło DIY#Projektowanie Wnętrz Ekologiczne#Styl Upcyklingu#Zrównoważony Dom#Ochrona Środowiska

0 notes

Text

Podzielność uwagi a ADHD

Nigdy nie słuchałam audiobooków ani podkastów, bo 1. problemy z przetwarzaniem słuchowym, 2. nie jestem się ZA NIC w stanie skupić na samych mówionych słowach, one do mojej głowy po prostu nie docierają albo natychmiast się rozpraszam. Jestem hardkorowym wzrokowcem – czyli najlepiej, jak do dźwięku mam też obraz oraz napisy. Bo jak widzę literki, to wiem, co znaczą dźwięki.

Ostatnio jednak wpadłam na pomysł, by puścić sobie podkast w tle, gdy robię korektę techniczną tekstu. Czyli wiecie, muszę się ogólnie skupić na tym, co dłubię, żeby wyłapać wszystkie źle oznaczone nagłówki, źle wstawione cudzysłowy, dywizy zamiast półpauzy i inne pierdoły. I co się okazało? Że jakby mój mózg miał się skupić tylko na korekcie, no to nie za bardzo, za trudne. A jakby miał się skupić tylko na podkaście, to też nie, za trudne. Skupić się na dwóch kompletnie różnych treściach w tych w samym czasie? A to bardzo fajnie, bardzo miło, od razu się łatwiej pracuje.To chyba jedna z tych supermocy ADHD czy coś.

PS. Ale nie wczytuję się ze zrozumieniem w tekst, który obrabiam, aż taka mocarna nie jestem.

0 notes

Text

Literat przegląda Internet nr 149

Literat przegląda Internet nr 149:

Zapraszam na wycieczkę do dwóch światów! Myślistwa i pornografii!

#pornhub #data #antropologia

Na dzisiaj wyszperałem dwa teksty. Zupełnie ze sobą niepowiązane, jakoś tak wyszło, że mnie zainteresowały. Pierwszy będzie dotyczył antropologii, a drugi przetwarzania danych osobowych w na portalu Pornhub. Ostrzegałem o wycieczce do zupełnie odmiennych światów! Pasy zapięte, więc mogę ze spokojną głową rozpędzać kolejny przegląd Internetu!

Kobiety też polowały!

Kiedyś, będąc jeszcze na…

View On WordPress

1 note

·

View note

Text

Przyszły wyniki alergologiczne Mika, no wynik na pyłki traw wywalony w kosmos plus niewielka alergia na uwaga ...jabłka!. A ja mu codziennie wciskam te jabłka.

Dziś w końcu wyczekany od marca laryngolog ( i tak prywatny of kors), migdały w miarę ( a straszyli nas koniecznością wycięcia) , ale przez tą alergię tak jest zapchany, ze najpierw 6 tyg leczenia, a potem jakiekolwiek dalsze badania ( badanie słuchu i kamerka w nos). Tym samym przetwarzanie słuchowe tez musi poczekać.

9 notes

·

View notes

Text

Nie chodzi o to, że Narcyzi mają zawyżoną samoocenę

Chodzi o to, że trudno jest nam ją uregulować - podobnie jak wielu neurotypowym czy straumatyzowanym osobom.

-----

Ogromną, gigantyczną częścią NPD jest fakt, że mamy zawyżoną podatność na wstyd. Oznacza to, że łatwo się wstydzimy, a gdy tak jest, odczuwamy go bardzo intensywnie. Tak intensywnie, że trudno jest to przetworzyć.

Warto też zwrócić uwagę na to, że samoocena przeciętnej osoby wzrasta i obniża się, ale nie tak łatwo jak u narcyzów (oraz osób z bpd, adhd itp.) Dla przeciętnej osoby, jeden błąd lub przypadek ośmieszenia się może nie wpłynąć na jej ogólną samoocenę. Wpłynie natomiast na narcyzów. Nie wychodzi nam jedna rzecz i nagle wstyd staje się nie do wytrzymania i może nas doprowadzić nawet do samookaleczania lub szukania na siłę walidacji, by zmniejszyć ból fizyczny, który odczuwamy razem z nim.

Wstyd ten pochodzi (oczywiście) z zaniedbania w dzieciństwie, przemocy czy ogólnie traumy. Bycie zmuszonym jako dziecko do odczuwania ogromu wstydu, a potem ukaranym za jego okazywanie, tworzy niezdrową myśl, że sam wstyd jest czymś, czego trzeba się wstydzić. Że coś jest z nami nie tak, jeśli robimy coś wstydliwego. A narcyzm jest stworzony tak, by nie móc sobie z tym poradzić.

Często łatwiej jest nam zamiast tego sfrustrować się, wkurzyć czy sięgnąć po niezdrowe metody radzenia sobie. Samookaleczanie, izolacja, niepozwalanie sobie na wrażliwość, alkohol/narkotyki i (czasami) odreagowywanie złości na innych.

Na szczęście młodsi terapeuci starają się naprawić szkody & stygmę, które wywołali dawni terapeuci. Wymyślili plany by nam pomóc z naszą mocno zachwianą samooceną, które składają się z:

tworzenie swojej własnej definicji tożsamości, na którą nie może wpłynąć perspektywa innych (to koncepcja w stylu "wyobraź sobie, że jesteś na bezludnej wyspie ze wszystkim, czego potrzebujesz. co byś zrobił i kim byś się stał?")

umiejętność dawania walidacji i Wsparcia samemu sobie

pozwalanie sobie na przetwarzanie wstydu w bezpiecznym miejscu, w którym możesz pewniej powstrzymać się przed sięganiem po stare, niezdrowe mechanizmy obronne

tworzenie zdrowszych nawyków odreagowywania, gdy twoja złość, wstyd i nienawiść do siebie stają się zbyt intensywne

Myślę, że ta idea, że symptomy w połączeniu z twoim stanem emocjonalnym automatycznie wywołują u ciebie pewne zachowania, jest ableistyczna.

Bardziej prawdopodobne jest, że narcyz stanie się ofiarą niż agresorem, ponieważ łatwo jest manipulować naszą samooceną i sprawić, że będziemy polegać na czyjejś walidacji/Wsparciu.

Mam nadzieję, że wyjaśniło to cokolwiek zainteresowanym.

źródło @theegosystem

#narcystyczne zaburzenie osobowości#npd#narcyzm#inne#zdrowie psychiczne#zaburzenie dramatyczno niekonsekwentne#zaburzenie osobowości typu b#zaburzenia osobowości#rozumienie narcyzmu#foreign language#typ b#theegosystem

5 notes

·

View notes

Text

Centra danych z wyjątkowymi perspektywami w Polsce

Bartłomiej Zagrodnik, Managing Partner, CEO w Walter Herz

Moc centrów danych w Polsce rośnie. Czy mamy szansę wyrównać do europejskiej czołówki? Inwestycje w tym sektorze nabierają rozpędu

Ilość inwestycji, jakie realizowane są w poszczególnych sektorach nieruchomości stoi dziś na zróżnicowanym poziomie. Coraz lepiej zaczynają jednak radzić sobie w Polsce tzw. sektory alternatywne. Biorąc pod uwagę aktualne potrzeby rynku najlepsze możliwości wzrostu ma szeroko pojęty sektor living oraz inwestycje w nieruchomości związane z rozwojem takich obszarów, jak transformacja energetyczna czy gromadzenie i przetwarzanie danych. Szczególnie duże szanse na szybki rozwój zasobów w Polsce i budowę klasy aktywów, która stanie się konkurencyjna dla standardowych sektorów mają centra danych.

Rynek data centers na świecie rośnie w imponującym tempie, o czym świadczą publikowane dane. W 2022 roku ich globalna moc wynosiła 4,9 GW, a w 2023 roku osiągnęła już 7,4 GW. W Europie największe huby dla sektora znajdują się w Londynie, Frankfurcie, Amsterdamie, Paryżu i Dublinie.

Polski rynek jest na początku swojej drogi, ale szeroką skalę rozwoju zapewniają nam wciąż niższe koszty realizacji projektów, tańsza budowa i grunty niż w Europie oraz małe nasycenie tego typu infrastrukturą w porównaniu z rynkami zachodnimi. Zwiększające się zapotrzebowanie na usługi cyfrowe, przekłada się na rozwój chmury obliczeniowej i wpływa także na tempo rozwoju inwestycji w centra danych w Polsce, co szczególnie widoczne jest od czterech lat.

Wzrost segmentu podbija teraz dodatkowo rozwój sztucznej inteligencji. I to właśnie AI jest aktualnie turbiną napędzającą popyt na moc obliczeniową i gromadzenie danych, a tym samym wzrost inwestycyjny branży. W Polsce inwestycje w centra przetwarzania danych dedykowane sztucznej inteligencji są dopiero na etapie przygotowania, ale skala projektów, jakie możemy ostatnio obserwować w tym sektorze jest naprawdę duża.

Oblicza się, że w kraju mamy ponad czterdzieści centrów danych, z których ponad jedna trzecia znajduje się w Warszawie. Prognozy mówią o prawie dwukrotnym zwiększeniu mocy (obecnie 310 MW) centrów danych działających w Polsce w ciągu czterech, pięciu lat.

Przyspieszenie w branży widoczne jest, zarówno w ilości, jak i wartości projektów. Wystarczy spojrzeć na ostatnie informacje. Firma Atman, której głównym udziałowcem jest Global Compute Infrastructure, zawarła niedawno umowę na finansowanie rozbudowy centrów danych na kwotę 1,35 mld zł. Kredyt udzielony przez sześć instytucji finansowych jest największym finansowaniem uzyskanym dotąd w Polsce na rozwój centrów danych. Kapitał ma zostać przeznaczony głównie na budowę nowego kampusu Waw-3 w Duchnicach pod Warszawą, który pomieści ponad 50 tys. serwerów w trzech budynkach o łącznej powierzchni blisko 19 tys. mkw., a także na rozbudowę istniejących obiektów firmy. Pierwszy budynek oferujący 14,4 MW mocy ma być ukończony w ostatnim kwartale tego roku.

W Jawczycach koło Warszawy otwarte zostało w ubiegłym roku pierwsze w Polsce centrum danych Grupy Data4 o mocy 8 MW. Drugie ma zostać oddane przed końcem tego roku. Na terenie rozbudowywanego kampusu docelowo powstaną cztery budynki ogółem o powierzchni 50 tys. mkw. i łącznej mocy 60 MW, a całkowity koszt tej inwestycji wyniesie 1 mld zł.

W kampusie firmy Vantage Data Centers na warszawskich Bielanach od 2022 roku działa pierwszy z dwóch zaplanowanych w nim obiektów. Po osiągnięciu pełnej gotowości operacyjnej na łącznej powierzchni 36 tys. mkw. kompleks zapewniać ma 48 MW mocy obliczeniowej.

Proces inwestycyjny i grunty

Pytanie, jak silną lokalizacją na sektorowej mapie ma szansę stać się Warszawa, która ma w Polsce największy potencjał, dzięki lokalizacji regionów chmurowych Microsoftu i Google’a, które nawiązały współpracę z Chmurą Krajową i deklarują olbrzymie inwestycje. Sprzyjający wpływ na rozwój dalszych inwestycji w Warszawie ma konieczność zachowania małej odległości centrów danych od odbiorcy końcowego ze względu na bezpieczeństwo i szybkość przesyłania danych. A popyt na usługi cyfrowe jest na warszawskim rynku największy w kraju.

Ze względu jednak na olbrzymie zapotrzebowanie na moc obliczeniową generowane teraz przez sztuczną inteligencję, dla której lokalizacja nie jest warunkiem, na znaczeniu mogą zyskiwać ośrodki regionalne, jak również rejony podmiejskie. Tym bardziej, że jednym z wymogów dotyczących specyfiki gruntów pod budowę data centers jest brak sąsiedztwa zabudowy wielorodzinnej.

I tu dochodzimy do największej przeszkody dla branży, jaką jest pozyskanie odpowiednio przygotowanych gruntów. Takich, które zapewniałyby możliwość osiągnięcia określonych wymogów technicznych dla tego rodzaju inwestycji i umieszczenia potrzebnej infrastruktury zgodnie z przepisami prawa miejscowego.

Kluczowym aspektem dla wyboru lokalizacji jest zagwarantowanie odpowiednich warunków przyłączenia, o mocy wystarczającej do zasilania centrum danych. Duże obiekty mają bowiem kilkadziesiąt razy większe zużycie energii niż magazyny oraz spore zapotrzebowanie na wodę do swoich systemów chłodzenia. A należy wspomnieć, że projektowane w Europie obiekty mają już moc nie kilkudziesięciu, a kilkuset megawatów.

Ważne jest również bezpieczeństwo, jakie zapewnia lokalizacja. Data centers nie mogą być narażone na przerwy w dostawach i zakłócenia zasilania. Powinny być też m.in. położone w określonej odległości od głównych dróg, choć odpowiedni dostęp do infrastruktury komunikacyjnej ma tu też istotne znaczenie.

Wyzwania klimatyczne

Przygotowanie takich inwestycji wymaga gotowości do współpracy operatorów sieci energetycznych z operatorami centów danych w zakresie zarządzania energią, by możliwe było dostosowanie obciążenia i dostępności energii, także tej magazynowanej. Branża stara się bowiem korzystać w jak największym zakresie ze źródeł odnawialnych. Z pomocą w rozbudowie i modernizacji sieci dystrybucji energii przychodzą fundusze unijne, dzięki którym planowana jest poprawa infrastruktury energetycznej w Polsce.

Wybór odpowiedniej lokalizacji pod centra danych istotny jest też w świetle przepisów unijnych dotyczących zmniejszenia zużycia energii końcowej w UE i konieczności raportowa przez centra danych o kluczowych wskaźnikach efektywności. Przekazywania informacji o zużyciu energii, wydzielonym cieple, rodzajach czynników chłodniczych oraz przepływie danych przychodzących i wychodzących.

Ten aspekt sprawia, że już w fazie decyzyjnej związanej z planowaną inwestycją analizie poddawane są wszystkie parametry, które dotyczą emisji gazów cieplarnianych i wpływu obiektów na jakość środowiska, zarówno na etapie budowy, jak i w czasie eksploatacji. Poszukiwane są najlepsze rozwiązania dla zrównoważonego projektowania w tym zakresie.

Wpisana w działalność centrów danych kontrola czynników środowiskowych sprawia, że podczas przygotowywania inwestycji rozpatrywany jest sposób wykorzystywania ciepła odpadowego, energii cieplnej, którą generują oraz możliwości nawiązania wielosektorowej współpracy w celu jego odzyskania. Centra pracujące w Europie starają być sprzężone z okoliczną infrastrukturą, aby mogły zostać wdrożone rozwiązania umożliwiające wykorzystanie wytwarzanego przez nie ciepła na przykład do ogrzewania obszarów miejskich albo w działalności lokalnych przedsiębiorstw.

0 notes

Text

Centra danych z wyjątkowymi perspektywami w Polsce

Bartłomiej Zagrodnik, Managing Partner, CEO w Walter Herz

Moc centrów danych w Polsce rośnie. Czy mamy szansę wyrównać do europejskiej czołówki? Inwestycje w tym sektorze nabierają rozpędu

Ilość inwestycji, jakie realizowane są w poszczególnych sektorach nieruchomości stoi dziś na zróżnicowanym poziomie. Coraz lepiej zaczynają jednak radzić sobie w Polsce tzw. sektory alternatywne. Biorąc pod uwagę aktualne potrzeby rynku najlepsze możliwości wzrostu ma szeroko pojęty sektor living oraz inwestycje w nieruchomości związane z rozwojem takich obszarów, jak transformacja energetyczna czy gromadzenie i przetwarzanie danych. Szczególnie duże szanse na szybki rozwój zasobów w Polsce i budowę klasy aktywów, która stanie się konkurencyjna dla standardowych sektorów mają centra danych.

Rynek data centers na świecie rośnie w imponującym tempie, o czym świadczą publikowane dane. W 2022 roku ich globalna moc wynosiła 4,9 GW, a w 2023 roku osiągnęła już 7,4 GW. W Europie największe huby dla sektora znajdują się w Londynie, Frankfurcie, Amsterdamie, Paryżu i Dublinie.

Polski rynek jest na początku swojej drogi, ale szeroką skalę rozwoju zapewniają nam wciąż niższe koszty realizacji projektów, tańsza budowa i grunty niż w Europie oraz małe nasycenie tego typu infrastrukturą w porównaniu z rynkami zachodnimi. Zwiększające się zapotrzebowanie na usługi cyfrowe, przekłada się na rozwój chmury obliczeniowej i wpływa także na tempo rozwoju inwestycji w centra danych w Polsce, co szczególnie widoczne jest od czterech lat.

Wzrost segmentu podbija teraz dodatkowo rozwój sztucznej inteligencji. I to właśnie AI jest aktualnie turbiną napędzającą popyt na moc obliczeniową i gromadzenie danych, a tym samym wzrost inwestycyjny branży. W Polsce inwestycje w centra przetwarzania danych dedykowane sztucznej inteligencji są dopiero na etapie przygotowania, ale skala projektów, jakie możemy ostatnio obserwować w tym sektorze jest naprawdę duża.

Oblicza się, że w kraju mamy ponad czterdzieści centrów danych, z których ponad jedna trzecia znajduje się w Warszawie. Prognozy mówią o prawie dwukrotnym zwiększeniu mocy (obecnie 310 MW) centrów danych działających w Polsce w ciągu czterech, pięciu lat.

Przyspieszenie w branży widoczne jest, zarówno w ilości, jak i wartości projektów. Wystarczy spojrzeć na ostatnie informacje. Firma Atman, której głównym udziałowcem jest Global Compute Infrastructure, zawarła niedawno umowę na finansowanie rozbudowy centrów danych na kwotę 1,35 mld zł. Kredyt udzielony przez sześć instytucji finansowych jest największym finansowaniem uzyskanym dotąd w Polsce na rozwój centrów danych. Kapitał ma zostać przeznaczony głównie na budowę nowego kampusu Waw-3 w Duchnicach pod Warszawą, który pomieści ponad 50 tys. serwerów w trzech budynkach o łącznej powierzchni blisko 19 tys. mkw., a także na rozbudowę istniejących obiektów firmy. Pierwszy budynek oferujący 14,4 MW mocy ma być ukończony w ostatnim kwartale tego roku.

W Jawczycach koło Warszawy otwarte zostało w ubiegłym roku pierwsze w Polsce centrum danych Grupy Data4 o mocy 8 MW. Drugie ma zostać oddane przed końcem tego roku. Na terenie rozbudowywanego kampusu docelowo powstaną cztery budynki ogółem o powierzchni 50 tys. mkw. i łącznej mocy 60 MW, a całkowity koszt tej inwestycji wyniesie 1 mld zł.

W kampusie firmy Vantage Data Centers na warszawskich Bielanach od 2022 roku działa pierwszy z dwóch zaplanowanych w nim obiektów. Po osiągnięciu pełnej gotowości operacyjnej na łącznej powierzchni 36 tys. mkw. kompleks zapewniać ma 48 MW mocy obliczeniowej.

Proces inwestycyjny i grunty

Pytanie, jak silną lokalizacją na sektorowej mapie ma szansę stać się Warszawa, która ma w Polsce największy potencjał, dzięki lokalizacji regionów chmurowych Microsoftu i Google’a, które nawiązały współpracę z Chmurą Krajową i deklarują olbrzymie inwestycje. Sprzyjający wpływ na rozwój dalszych inwestycji w Warszawie ma konieczność zachowania małej odległości centrów danych od odbiorcy końcowego ze względu na bezpieczeństwo i szybkość przesyłania danych. A popyt na usługi cyfrowe jest na warszawskim rynku największy w kraju.

Ze względu jednak na olbrzymie zapotrzebowanie na moc obliczeniową generowane teraz przez sztuczną inteligencję, dla której lokalizacja nie jest warunkiem, na znaczeniu mogą zyskiwać ośrodki regionalne, jak również rejony podmiejskie. Tym bardziej, że jednym z wymogów dotyczących specyfiki gruntów pod budowę data centers jest brak sąsiedztwa zabudowy wielorodzinnej.

I tu dochodzimy do największej przeszkody dla branży, jaką jest pozyskanie odpowiednio przygotowanych gruntów. Takich, które zapewniałyby możliwość osiągnięcia określonych wymogów technicznych dla tego rodzaju inwestycji i umieszczenia potrzebnej infrastruktury zgodnie z przepisami prawa miejscowego.

Kluczowym aspektem dla wyboru lokalizacji jest zagwarantowanie odpowiednich warunków przyłączenia, o mocy wystarczającej do zasilania centrum danych. Duże obiekty mają bowiem kilkadziesiąt razy większe zużycie energii niż magazyny oraz spore zapotrzebowanie na wodę do swoich systemów chłodzenia. A należy wspomnieć, że projektowane w Europie obiekty mają już moc nie kilkudziesięciu, a kilkuset megawatów.

Ważne jest również bezpieczeństwo, jakie zapewnia lokalizacja. Data centers nie mogą być narażone na przerwy w dostawach i zakłócenia zasilania. Powinny być też m.in. położone w określonej odległości od głównych dróg, choć odpowiedni dostęp do infrastruktury komunikacyjnej ma tu też istotne znaczenie.

Wyzwania klimatyczne

Przygotowanie takich inwestycji wymaga gotowości do współpracy operatorów sieci energetycznych z operatorami centów danych w zakresie zarządzania energią, by możliwe było dostosowanie obciążenia i dostępności energii, także tej magazynowanej. Branża stara się bowiem korzystać w jak największym zakresie ze źródeł odnawialnych. Z pomocą w rozbudowie i modernizacji sieci dystrybucji energii przychodzą fundusze unijne, dzięki którym planowana jest poprawa infrastruktury energetycznej w Polsce.

Wybór odpowiedniej lokalizacji pod centra danych istotny jest też w świetle przepisów unijnych dotyczących zmniejszenia zużycia energii końcowej w UE i konieczności raportowa przez centra danych o kluczowych wskaźnikach efektywności. Przekazywania informacji o zużyciu energii, wydzielonym cieple, rodzajach czynników chłodniczych oraz przepływie danych przychodzących i wychodzących.

Ten aspekt sprawia, że już w fazie decyzyjnej związanej z planowaną inwestycją analizie poddawane są wszystkie parametry, które dotyczą emisji gazów cieplarnianych i wpływu obiektów na jakość środowiska, zarówno na etapie budowy, jak i w czasie eksploatacji. Poszukiwane są najlepsze rozwiązania dla zrównoważonego projektowania w tym zakresie.

Wpisana w działalność centrów danych kontrola czynników środowiskowych sprawia, że podczas przygotowywania inwestycji rozpatrywany jest sposób wykorzystywania ciepła odpadowego, energii cieplnej, którą generują oraz możliwości nawiązania wielosektorowej współpracy w celu jego odzyskania. Centra pracujące w Europie starają być sprzężone z okoliczną infrastrukturą, aby mogły zostać wdrożone rozwiązania umożliwiające wykorzystanie wytwarzanego przez nie ciepła na przykład do ogrzewania obszarów miejskich albo w działalności lokalnych przedsiębiorstw.

0 notes

Text

Centra danych z wyjątkowymi perspektywami w Polsce

Bartłomiej Zagrodnik, Managing Partner, CEO w Walter Herz

Moc centrów danych w Polsce rośnie. Czy mamy szansę wyrównać do europejskiej czołówki? Inwestycje w tym sektorze nabierają rozpędu

Ilość inwestycji, jakie realizowane są w poszczególnych sektorach nieruchomości stoi dziś na zróżnicowanym poziomie. Coraz lepiej zaczynają jednak radzić sobie w Polsce tzw. sektory alternatywne. Biorąc pod uwagę aktualne potrzeby rynku najlepsze możliwości wzrostu ma szeroko pojęty sektor living oraz inwestycje w nieruchomości związane z rozwojem takich obszarów, jak transformacja energetyczna czy gromadzenie i przetwarzanie danych. Szczególnie duże szanse na szybki rozwój zasobów w Polsce i budowę klasy aktywów, która stanie się konkurencyjna dla standardowych sektorów mają centra danych.

Rynek data centers na świecie rośnie w imponującym tempie, o czym świadczą publikowane dane. W 2022 roku ich globalna moc wynosiła 4,9 GW, a w 2023 roku osiągnęła już 7,4 GW. W Europie największe huby dla sektora znajdują się w Londynie, Frankfurcie, Amsterdamie, Paryżu i Dublinie.

Polski rynek jest na początku swojej drogi, ale szeroką skalę rozwoju zapewniają nam wciąż niższe koszty realizacji projektów, tańsza budowa i grunty niż w Europie oraz małe nasycenie tego typu infrastrukturą w porównaniu z rynkami zachodnimi. Zwiększające się zapotrzebowanie na usługi cyfrowe, przekłada się na rozwój chmury obliczeniowej i wpływa także na tempo rozwoju inwestycji w centra danych w Polsce, co szczególnie widoczne jest od czterech lat.

Wzrost segmentu podbija teraz dodatkowo rozwój sztucznej inteligencji. I to właśnie AI jest aktualnie turbiną napędzającą popyt na moc obliczeniową i gromadzenie danych, a tym samym wzrost inwestycyjny branży. W Polsce inwestycje w centra przetwarzania danych dedykowane sztucznej inteligencji są dopiero na etapie przygotowania, ale skala projektów, jakie możemy ostatnio obserwować w tym sektorze jest naprawdę duża.

Oblicza się, że w kraju mamy ponad czterdzieści centrów danych, z których ponad jedna trzecia znajduje się w Warszawie. Prognozy mówią o prawie dwukrotnym zwiększeniu mocy (obecnie 310 MW) centrów danych działających w Polsce w ciągu czterech, pięciu lat.

Przyspieszenie w branży widoczne jest, zarówno w ilości, jak i wartości projektów. Wystarczy spojrzeć na ostatnie informacje. Firma Atman, której głównym udziałowcem jest Global Compute Infrastructure, zawarła niedawno umowę na finansowanie rozbudowy centrów danych na kwotę 1,35 mld zł. Kredyt udzielony przez sześć instytucji finansowych jest największym finansowaniem uzyskanym dotąd w Polsce na rozwój centrów danych. Kapitał ma zostać przeznaczony głównie na budowę nowego kampusu Waw-3 w Duchnicach pod Warszawą, który pomieści ponad 50 tys. serwerów w trzech budynkach o łącznej powierzchni blisko 19 tys. mkw., a także na rozbudowę istniejących obiektów firmy. Pierwszy budynek oferujący 14,4 MW mocy ma być ukończony w ostatnim kwartale tego roku.

W Jawczycach koło Warszawy otwarte zostało w ubiegłym roku pierwsze w Polsce centrum danych Grupy Data4 o mocy 8 MW. Drugie ma zostać oddane przed końcem tego roku. Na terenie rozbudowywanego kampusu docelowo powstaną cztery budynki ogółem o powierzchni 50 tys. mkw. i łącznej mocy 60 MW, a całkowity koszt tej inwestycji wyniesie 1 mld zł.

W kampusie firmy Vantage Data Centers na warszawskich Bielanach od 2022 roku działa pierwszy z dwóch zaplanowanych w nim obiektów. Po osiągnięciu pełnej gotowości operacyjnej na łącznej powierzchni 36 tys. mkw. kompleks zapewniać ma 48 MW mocy obliczeniowej.

Proces inwestycyjny i grunty

Pytanie, jak silną lokalizacją na sektorowej mapie ma szansę stać się Warszawa, która ma w Polsce największy potencjał, dzięki lokalizacji regionów chmurowych Microsoftu i Google’a, które nawiązały współpracę z Chmurą Krajową i deklarują olbrzymie inwestycje. Sprzyjający wpływ na rozwój dalszych inwestycji w Warszawie ma konieczność zachowania małej odległości centrów danych od odbiorcy końcowego ze względu na bezpieczeństwo i szybkość przesyłania danych. A popyt na usługi cyfrowe jest na warszawskim rynku największy w kraju.

Ze względu jednak na olbrzymie zapotrzebowanie na moc obliczeniową generowane teraz przez sztuczną inteligencję, dla której lokalizacja nie jest warunkiem, na znaczeniu mogą zyskiwać ośrodki regionalne, jak również rejony podmiejskie. Tym bardziej, że jednym z wymogów dotyczących specyfiki gruntów pod budowę data centers jest brak sąsiedztwa zabudowy wielorodzinnej.

I tu dochodzimy do największej przeszkody dla branży, jaką jest pozyskanie odpowiednio przygotowanych gruntów. Takich, które zapewniałyby możliwość osiągnięcia określonych wymogów technicznych dla tego rodzaju inwestycji i umieszczenia potrzebnej infrastruktury zgodnie z przepisami prawa miejscowego.

Kluczowym aspektem dla wyboru lokalizacji jest zagwarantowanie odpowiednich warunków przyłączenia, o mocy wystarczającej do zasilania centrum danych. Duże obiekty mają bowiem kilkadziesiąt razy większe zużycie energii niż magazyny oraz spore zapotrzebowanie na wodę do swoich systemów chłodzenia. A należy wspomnieć, że projektowane w Europie obiekty mają już moc nie kilkudziesięciu, a kilkuset megawatów.

Ważne jest również bezpieczeństwo, jakie zapewnia lokalizacja. Data centers nie mogą być narażone na przerwy w dostawach i zakłócenia zasilania. Powinny być też m.in. położone w określonej odległości od głównych dróg, choć odpowiedni dostęp do infrastruktury komunikacyjnej ma tu też istotne znaczenie.

Wyzwania klimatyczne

Przygotowanie takich inwestycji wymaga gotowości do współpracy operatorów sieci energetycznych z operatorami centów danych w zakresie zarządzania energią, by możliwe było dostosowanie obciążenia i dostępności energii, także tej magazynowanej. Branża stara się bowiem korzystać w jak największym zakresie ze źródeł odnawialnych. Z pomocą w rozbudowie i modernizacji sieci dystrybucji energii przychodzą fundusze unijne, dzięki którym planowana jest poprawa infrastruktury energetycznej w Polsce.

Wybór odpowiedniej lokalizacji pod centra danych istotny jest też w świetle przepisów unijnych dotyczących zmniejszenia zużycia energii końcowej w UE i konieczności raportowa przez centra danych o kluczowych wskaźnikach efektywności. Przekazywania informacji o zużyciu energii, wydzielonym cieple, rodzajach czynników chłodniczych oraz przepływie danych przychodzących i wychodzących.

Ten aspekt sprawia, że już w fazie decyzyjnej związanej z planowaną inwestycją analizie poddawane są wszystkie parametry, które dotyczą emisji gazów cieplarnianych i wpływu obiektów na jakość środowiska, zarówno na etapie budowy, jak i w czasie eksploatacji. Poszukiwane są najlepsze rozwiązania dla zrównoważonego projektowania w tym zakresie.

Wpisana w działalność centrów danych kontrola czynników środowiskowych sprawia, że podczas przygotowywania inwestycji rozpatrywany jest sposób wykorzystywania ciepła odpadowego, energii cieplnej, którą generują oraz możliwości nawiązania wielosektorowej współpracy w celu jego odzyskania. Centra pracujące w Europie starają być sprzężone z okoliczną infrastrukturą, aby mogły zostać wdrożone rozwiązania umożliwiające wykorzystanie wytwarzanego przez nie ciepła na przykład do ogrzewania obszarów miejskich albo w działalności lokalnych przedsiębiorstw.

0 notes

Text

Centra danych z wyjątkowymi perspektywami w Polsce

Bartłomiej Zagrodnik, Managing Partner, CEO w Walter Herz

Moc centrów danych w Polsce rośnie. Czy mamy szansę wyrównać do europejskiej czołówki? Inwestycje w tym sektorze nabierają rozpędu

Ilość inwestycji, jakie realizowane są w poszczególnych sektorach nieruchomości stoi dziś na zróżnicowanym poziomie. Coraz lepiej zaczynają jednak radzić sobie w Polsce tzw. sektory alternatywne. Biorąc pod uwagę aktualne potrzeby rynku najlepsze możliwości wzrostu ma szeroko pojęty sektor living oraz inwestycje w nieruchomości związane z rozwojem takich obszarów, jak transformacja energetyczna czy gromadzenie i przetwarzanie danych. Szczególnie duże szanse na szybki rozwój zasobów w Polsce i budowę klasy aktywów, która stanie się konkurencyjna dla standardowych sektorów mają centra danych.

Rynek data centers na świecie rośnie w imponującym tempie, o czym świadczą publikowane dane. W 2022 roku ich globalna moc wynosiła 4,9 GW, a w 2023 roku osiągnęła już 7,4 GW. W Europie największe huby dla sektora znajdują się w Londynie, Frankfurcie, Amsterdamie, Paryżu i Dublinie.

Polski rynek jest na początku swojej drogi, ale szeroką skalę rozwoju zapewniają nam wciąż niższe koszty realizacji projektów, tańsza budowa i grunty niż w Europie oraz małe nasycenie tego typu infrastrukturą w porównaniu z rynkami zachodnimi. Zwiększające się zapotrzebowanie na usługi cyfrowe, przekłada się na rozwój chmury obliczeniowej i wpływa także na tempo rozwoju inwestycji w centra danych w Polsce, co szczególnie widoczne jest od czterech lat.

Wzrost segmentu podbija teraz dodatkowo rozwój sztucznej inteligencji. I to właśnie AI jest aktualnie turbiną napędzającą popyt na moc obliczeniową i gromadzenie danych, a tym samym wzrost inwestycyjny branży. W Polsce inwestycje w centra przetwarzania danych dedykowane sztucznej inteligencji są dopiero na etapie przygotowania, ale skala projektów, jakie możemy ostatnio obserwować w tym sektorze jest naprawdę duża.

Oblicza się, że w kraju mamy ponad czterdzieści centrów danych, z których ponad jedna trzecia znajduje się w Warszawie. Prognozy mówią o prawie dwukrotnym zwiększeniu mocy (obecnie 310 MW) centrów danych działających w Polsce w ciągu czterech, pięciu lat.

Przyspieszenie w branży widoczne jest, zarówno w ilości, jak i wartości projektów. Wystarczy spojrzeć na ostatnie informacje. Firma Atman, której głównym udziałowcem jest Global Compute Infrastructure, zawarła niedawno umowę na finansowanie rozbudowy centrów danych na kwotę 1,35 mld zł. Kredyt udzielony przez sześć instytucji finansowych jest największym finansowaniem uzyskanym dotąd w Polsce na rozwój centrów danych. Kapitał ma zostać przeznaczony głównie na budowę nowego kampusu Waw-3 w Duchnicach pod Warszawą, który pomieści ponad 50 tys. serwerów w trzech budynkach o łącznej powierzchni blisko 19 tys. mkw., a także na rozbudowę istniejących obiektów firmy. Pierwszy budynek oferujący 14,4 MW mocy ma być ukończony w ostatnim kwartale tego roku.

W Jawczycach koło Warszawy otwarte zostało w ubiegłym roku pierwsze w Polsce centrum danych Grupy Data4 o mocy 8 MW. Drugie ma zostać oddane przed końcem tego roku. Na terenie rozbudowywanego kampusu docelowo powstaną cztery budynki ogółem o powierzchni 50 tys. mkw. i łącznej mocy 60 MW, a całkowity koszt tej inwestycji wyniesie 1 mld zł.

W kampusie firmy Vantage Data Centers na warszawskich Bielanach od 2022 roku działa pierwszy z dwóch zaplanowanych w nim obiektów. Po osiągnięciu pełnej gotowości operacyjnej na łącznej powierzchni 36 tys. mkw. kompleks zapewniać ma 48 MW mocy obliczeniowej.

Proces inwestycyjny i grunty

Pytanie, jak silną lokalizacją na sektorowej mapie ma szansę stać się Warszawa, która ma w Polsce największy potencjał, dzięki lokalizacji regionów chmurowych Microsoftu i Google’a, które nawiązały współpracę z Chmurą Krajową i deklarują olbrzymie inwestycje. Sprzyjający wpływ na rozwój dalszych inwestycji w Warszawie ma konieczność zachowania małej odległości centrów danych od odbiorcy końcowego ze względu na bezpieczeństwo i szybkość przesyłania danych. A popyt na usługi cyfrowe jest na warszawskim rynku największy w kraju.

Ze względu jednak na olbrzymie zapotrzebowanie na moc obliczeniową generowane teraz przez sztuczną inteligencję, dla której lokalizacja nie jest warunkiem, na znaczeniu mogą zyskiwać ośrodki regionalne, jak również rejony podmiejskie. Tym bardziej, że jednym z wymogów dotyczących specyfiki gruntów pod budowę data centers jest brak sąsiedztwa zabudowy wielorodzinnej.

I tu dochodzimy do największej przeszkody dla branży, jaką jest pozyskanie odpowiednio przygotowanych gruntów. Takich, które zapewniałyby możliwość osiągnięcia określonych wymogów technicznych dla tego rodzaju inwestycji i umieszczenia potrzebnej infrastruktury zgodnie z przepisami prawa miejscowego.

Kluczowym aspektem dla wyboru lokalizacji jest zagwarantowanie odpowiednich warunków przyłączenia, o mocy wystarczającej do zasilania centrum danych. Duże obiekty mają bowiem kilkadziesiąt razy większe zużycie energii niż magazyny oraz spore zapotrzebowanie na wodę do swoich systemów chłodzenia. A należy wspomnieć, że projektowane w Europie obiekty mają już moc nie kilkudziesięciu, a kilkuset megawatów.

Ważne jest również bezpieczeństwo, jakie zapewnia lokalizacja. Data centers nie mogą być narażone na przerwy w dostawach i zakłócenia zasilania. Powinny być też m.in. położone w określonej odległości od głównych dróg, choć odpowiedni dostęp do infrastruktury komunikacyjnej ma tu też istotne znaczenie.

Wyzwania klimatyczne

Przygotowanie takich inwestycji wymaga gotowości do współpracy operatorów sieci energetycznych z operatorami centów danych w zakresie zarządzania energią, by możliwe było dostosowanie obciążenia i dostępności energii, także tej magazynowanej. Branża stara się bowiem korzystać w jak największym zakresie ze źródeł odnawialnych. Z pomocą w rozbudowie i modernizacji sieci dystrybucji energii przychodzą fundusze unijne, dzięki którym planowana jest poprawa infrastruktury energetycznej w Polsce.

Wybór odpowiedniej lokalizacji pod centra danych istotny jest też w świetle przepisów unijnych dotyczących zmniejszenia zużycia energii końcowej w UE i konieczności raportowa przez centra danych o kluczowych wskaźnikach efektywności. Przekazywania informacji o zużyciu energii, wydzielonym cieple, rodzajach czynników chłodniczych oraz przepływie danych przychodzących i wychodzących.

Ten aspekt sprawia, że już w fazie decyzyjnej związanej z planowaną inwestycją analizie poddawane są wszystkie parametry, które dotyczą emisji gazów cieplarnianych i wpływu obiektów na jakość środowiska, zarówno na etapie budowy, jak i w czasie eksploatacji. Poszukiwane są najlepsze rozwiązania dla zrównoważonego projektowania w tym zakresie.

Wpisana w działalność centrów danych kontrola czynników środowiskowych sprawia, że podczas przygotowywania inwestycji rozpatrywany jest sposób wykorzystywania ciepła odpadowego, energii cieplnej, którą generują oraz możliwości nawiązania wielosektorowej współpracy w celu jego odzyskania. Centra pracujące w Europie starają być sprzężone z okoliczną infrastrukturą, aby mogły zostać wdrożone rozwiązania umożliwiające wykorzystanie wytwarzanego przez nie ciepła na przykład do ogrzewania obszarów miejskich albo w działalności lokalnych przedsiębiorstw.

Walter Herz

0 notes

Text

Jak odczytywanie dokumentów rewolucjonizuje księgowość?

Odczytywanie faktur, zwane również OCR (Optical Character Recognition), stało się niezastąpionym narzędziem w księgowości. Dzięki tej technologii firmy mogą automatycznie przetwarzać dokumenty finansowe, eliminując ręczne wprowadzanie danych. W tym artykule przeanalizujemy, jak działa odczytywanie faktur, jakie korzyści przynosi i jakie są najlepsze praktyki wdrażania tego rozwiązania.

Co to jest OCR i jak działa odczytywanie dokumentów?

OCR, czyli optyczne rozpoznawanie tekstu, to technologia umożliwiająca automatyczne przetwarzanie tekstu z zeskanowanych dokumentów lub obrazów do edytowalnej i przeszukiwalnej formy cyfrowej. Proces ten składa się z kilku etapów:

Skanowanie i Preprocessing

Pierwszym krokiem jest skanowanie dokumentu, który może być w formie papierowej faktury, paragonu lub wyciągu bankowego. Wysokiej jakości skan jest kluczowy dla dokładności OCR. Następnie dokument przechodzi przez preprocessing, gdzie jest oczyszczany z szumów i poprawiana jest jego jakość.

Rozpoznawanie Tekstu

Za pomocą zaawansowanych algorytmów OCR, takich jak te wykorzystujące sztuczną inteligencję i machine learning, program identyfikuje litery, liczby i inne znaki w dokumencie. Algorytmy te są w stanie rozpoznać różne czcionki, rozmiary tekstu i układy. W ten sposób odczytywanie dokumentów jest skuteczne i szybkie

Nowoczesne rozwiązania do odczytywania dokumentów

Narzędzia takie jak SaldeoSMART pokazują, jak zaawansowana technologia może usprawnić procesy księgowe i przyczynić się do lepszego zarządzania dokumentami. Wdrażając OCR w swojej firmie, możesz zyskać przewagę konkurencyjną i zapewnić lepszą obsługę finansową. Wybierz sprawdzony program do odczytywania dokumentów!

0 notes

Text

Oreo: Więcej niż Ciastko, Symbol Innowacji w Technologii Żywności. Co nadaje ciasteczkom ich charakterystyczną czarną barwę?

Na arenie globalnych przysmaków, tylko nieliczne produkty osiągają status kultowych – wśród nich królują ciasteczka Oreo. Dostępne niemal w każdym zakątku świata, zdumiewają swoją wszechobecnością. W świecie przysmaków, gdzie rywalizacja jest zacięta jak finał ligi mistrzów, ciasteczka Oreo to prawdziwi mistrzowie.

Co sprawia, że są tak popularne? To zagadka. Jednakże ich wyrazista, głęboka czerń niewątpliwie odgrywa istotną rolę.

Niewiele jest pokarmów bardziej czarnych niż Oreo. Ich barwa przypomina intensywnie spaloną potrawę, ale bez nieprzyjemnych smaków. Tajemnica kryje się w procesie przetwarzania czekolady czy kakao, które są kluczowym składnikiem tych ciasteczek.

Kakao nadaje Oreo mroczny czarny odcień

Przyglądając się bliżej składnikom ciasteczek Oreo, odkryjesz, że to właśnie kakao w proszku, stanowiące około 4,5% ich zawartości, jest głównym architektem ich barwy. To właśnie ono potwierdza, że są to ciasteczka czekoladowe. Pozostałe składniki to mąka pszenna, cukry, tłuszcze, substancje spulchniające, sól, emulgator i aromaty. Zatem, nie znajdziemy w nich żadnych barwników czy koloryzantów. Przypomina to sytuację z pewnego meczu, gdzie niesławny rezerwowy, wchodząc na boisko w ostatnich minutach, strzela zwycięskiego gola.

Aczkolwiek, większość proszków kakaowych ma barwę brązową, a nie czarną. Uzyskują ten kolor w procesie produkcyjnym, podczas przekształcania ziaren kakaowych w proszek. Jednak ich dokładny odcień zależy od sposobu przetwarzania, a konkretnie od stopnia ich alkalizacji.

Alkalizacja sprawia, że proszek kakaowy staje się czarny

W procesie tworzenia proszku kakaowego, jednym z kluczowych momentów jest decyzja o jego alkalizacji. Przetwarzanie kakao przypomina nieco piłkarski mecz, gdzie kluczową rolę odgrywa moment, kiedy trener decyduje się na wprowadzenie zmiany taktyki. Taką zmianą taktyczną w procesie produkcyjnym kakao jest alkalizacja Zwykle proszek ten jest kwaśny, z pH w przedziale 4,7-6. Alkalizacja to etap, na którym do kakao dodaje się składnik alkaliczny, co podnosi jego pH, przekształcając je w substancję zasadową.

To zwiększenie pH ma istotny wpływ na właściwości kakao. Przede wszystkim, powoduje to zmianę koloru z jasnobrązowego na ciemnobrązowy, a nawet czarny. Ale nie tylko kolor ulega zmianie - proces ten wpływa również na smak kakao, czyniąc go mniej gorzkim. Dodatkowo, poprawia się rozpuszczalność proszku, co ułatwia jego wykorzystanie, na przykład przy przygotowywaniu czekoladowego mleka

Kontrola procesu determinuje kolor

To, jaki dokładnie odcień i profil smakowy uzyska alkalizowane kakao, zależy od warunków, w jakich przeprowadza się ten proces. Zmiana temperatury, ciśnienia, czasu trwania procesu czy rodzaju użytego środka alkalicznego - każdy z tych elementów może wpłynąć na ostateczną barwę proszku kakaowego. Na przykład, aby uzyskać czarny proszek kakaowy, zwykle potrzebne są wysokie temperatury, sięgające nawet 135°C. Przekroczenie tej wartości może spowodować jeszcze ciemniejszy kolor, ale równocześnie negatywnie wpłynąć na smak, niczym strzał, który mimo siły i precyzji, odbija się od poprzeczki. Alkalizacja przy niższych temperaturach z kolei skutkuje powstaniem proszku o czerwonym odcieniu.

Czarne proszki kakaowe wymagają także dłuższego czasu alkalizacji i zazwyczaj potrzebują wyższego ciśnienia w porównaniu do proszków brązowych czy czerwonych. To niczym precyzyjne dostrojenie instrumentu muzycznego - każdy detal ma znaczenie dla ostatecznej harmonii barwy i smaku.

Holenderskie kakao - jest alkalizowanym kakaem

Możesz mieć trudności z odnalezieniem proszku kakaowego określanego jako “alkalizowany”. Poszukiwanie może przypominać poszukiwanie piłkarskiego talentu ukrytego w niższych ligach. Zamiast tego, częściej spotkasz kakao “holenderskie”. Nazwa “holenderskie” wywodzi się od nazwiska wynalazcy tego procesu - Coenraad Johannes van Houten, holenderskiego producenta czekolady, który odkrył efekt alkalizacji na proszek kakaowy ponad 100 lat temu.

Alkalizacja łagodzi smak

Ogólnie rzecz biorąc, im ciemniejszy kolor kakao, tym mniej jest ono cierpkie i gorzkie. W rezultacie, produkty wykonane z ciemniejszego proszku będą miały mniej tego typowego “czekoladowego” smaku. To może być powodem, dla którego ciasteczka Oreo, mimo zawartości kakao, niekoniecznie kojarzą się z typowym smakiem czekolady.

Fizyka vs. Produkcja żywności: Tajemnice Kremu Oreo

Kiedy fizyka spotyka się z tworzeniem nowych produktów, wyniki mogą być zaskakujące, a czasem nawet przepyszne. Przypadek ciasteczek Oreo doskonale ilustruje to połączenie. Kluczowym elementem, który wzbudza ciekawość, jest lepkość i adhezyjność kremu, które decydują o tym, że przylega on głównie do jednej strony ciasteczka. Jak to się dzieje?

Lepkość i Adhezyjność: Główni Bohaterowie

Lepkość, czyli opór przeciwko przepływowi, w przypadku kremu Oreo sprawia, że ma on konsystencję wystarczająco gęstą, aby nie wyciekać, ale jednocześnie wystarczająco płynną, by łatwo się rozsmarowywać. Adhezyjność kremu, czyli jego zdolność do przylegania do innych powierzchni, w tym przypadku do ciastka, jest równie istotna. Kiedy na jedno z ciasteczek nakładany jest krem, jego adhezyjne właściwości sprawiają, że "przywiera" on do tej pierwszej powierzchni bardziej niż do drugiej, dodanej chwilę później.

Porównanie z Cukierniczymi Kuzynami

Podobne zjawiska można zaobserwować w innych produktach cukierniczych. Weźmy na przykład francuskie makaroniki – tutaj również grają rolę właściwości fizyczne nadzienia, które decydują o tym, jak dobrze będą się trzymać dwie połówki ciastka. Również w przypadku wypieków takich jak torty, odpowiednia lepkość kremu ma kluczowe znaczenie dla utrzymania warstw ciasta w stabilnej konstrukcji.

Czym Jest Oreologia?

Oreo zainspirowało nawet powstanie nowej subdyscypliny w nauce - oreologii. Ta zabawna, lecz poważna dziedzina bada właśnie takie zagadnienia jak wpływ lepkości i adhezyjności na właściwości produktów spożywczych. Przez lata, oreologia rozszerzyła swoje zainteresowania, badając różne aspekty ciasteczek, od ich składu, przez teksturę, aż po interakcje między różnymi składnikami.

Praktyczne Zastosowania

Wiedza o lepkości i adhezyjności kremu ma praktyczne znaczenie nie tylko dla producentów ciasteczek, ale także dla profesjonalnych cukierników. Zrozumienie tych właściwości pozwala na tworzenie lepszych przepisów i technik dekorowania, które uwzględniają zachowanie kremów i nadzień.

Tekstura żywności vs lepkość vs adhezyjność

Na poziomie produkcji żywności, tworzenia nowych produktów spożywczych, tekstura żywności, która obejmuje lepkość i adhezyjność, jest ważnym parametrem sensorycznym. Tekstura jest postrzegana przez wiele zmysłów i obejmuje różne właściwości, takie jak twardość, spójność, lepkość, sprężystość, adhezyjność, przeżuwalność i gumowatość. Te parametry są istotne nie tylko dla ciastek Oreo, ale również dla innych produktów spożywczych, gdzie właściwości fizyczne wpływają na odbiór sensoryczny i doświadczenia smakowe.

Oreo zaprezentowało ponad 100 odmian smakowych na całym świecie

Wyszukiwania w Internecie pokazują, że wiele osób zastanawiało się, ile odmian Oreo było dostępnych na przestrzeni czasu. Biorąc pod uwagę, że Oreo można kupić w tak wielu krajach i istnieją od ponad wieku, nie powinno dziwić, że różne rankingi wykazały, że istnieje ponad 100 smaków Oreo. Czy są jakieś różnice między tym, co jest dostępne w USA i za granicą?

Okazuje się, że różnic jest kilka. W Chinach Oreo oferuje Oreo o smaku lodów z zielonej herbaty, ciastko przypominające smak lodów i uczucie chłodzenia. Innym słynnym chińskim Oreo jest smak brzoskwini i winogron. W Argentynie Oreo ma smak banana lub dulce de leche. Jednocześnie dobrze brzmi również indonezyjski smak czekolady i truskawek. Wreszcie, Meksyk ma atrakcyjną odmianę Oreo, ciastko czekoladowe trio. Jednak najlepiej sprzedającym się modelem marki pozostaje klasyczne czarno-białe Oreo.

Podwójnie Nadziewane Oreo: Matematyczna Zagadka Nadzienia

Podwójnie nadziewane ciasteczka Oreo, znane jako "Double Stuf", wydają się być kulinarne marzenie każdego łasucha. Ale czy rzeczywiście mają one dwa razy więcej nadzienia, niż standardowe wersje? W 2013 roku, nauczyciel matematyki z Nowego Jorku, Dan Anderson, postanowił to sprawdzić. Jego eksperyment, przeprowadzony z uczniami, ujawnił, że Double Stuf Oreo ma około 1,86 raza więcej kremowego nadzienia niż zwykłe ciasteczka Oreo. Ten niespodziewany wynik poruszył świat miłośników słodyczy i pokazał, że czasem matematyka może dostarczyć zaskakujących odpowiedzi w najmniej spodziewanych miejscach.

Sam J. Porcello: Naukowiec, Który Ukształtował Oreo

Sam J. Porcello, znany jako "Mr. Oreo", odegrał kluczową rolę w kształtowaniu tego, czym dziś są ciasteczka Oreo. Dołączył do Nabisco w 1956 roku, Porcello stał się pionierem w dziedzinie opracowywania nadzienia. Podczas swojej kadencji pracował nad różnymi produktami, w tym nad SnackWells, ale praca nad Oreo przyniosła mu sławę. Najbardziej znaczącym wkładem Porcello w powstanie Oreo była pomoc w opracowaniu nadzienia, które jest obecnie używane w ciasteczku. Eksperymentował z różnymi nadzieniami, w tym cytrynowym, limonkowym i pomarańczowym, zanim zdecydował się na kremowe białe nadzienie, które wszyscy znamy i kochamy

W swojej karierze eksperymentował z wieloma smakami, tworząc krem, który stał się sercem ciasteczek Oreo. Porcello, mający na swoim koncie aż pięć patentów związanych z Oreo, przyczynił się do rozwoju jednej z najbardziej ikonicznych marek przekąsek na świecie. Jego innowacje w dziedzinie smaku i tekstury nadały Oreo charakter, który przetrwał próbę czasu.

Początki Oreo: Inspiracja i Rywalizacja z Hydrox

Oreo, choć obecnie jest symbolem amerykańskiej kultury przekąsek, ma swoje korzenie w rywalizacji z innym ciasteczkiem – Hydrox. Hydrox, wprowadzone na rynek przez Sunshine Biscuit Company w 1908 roku, były pierwotnym wzorem dla ciasteczek kanapkowych. Kiedy Nabisco wprowadziło Oreo w 1912 roku, ciasteczko to szybko zyskało na popularności, stopniowo przewyższając Hydrox. Różnice między oboma ciasteczkami – od tekstury po wzory na wierzchu – stały się przedmiotem dyskusji wśród konsumentów. Z czasem Hydrox zaczęto uważać za naśladowcę Oreo, mimo że były na rynku pierwsze. Historia Oreo i Hydrox jest fascynującym przykładem tego, jak dynamika rynkowa i percepcja konsumentów mogą wpływać na losy produktów.

Oreo w Popkulturze: Więcej niż Ciasteczko

Oreo nie jest tylko przysmakiem – stało się ono kulturowym fenomenem, obecnym w filmach, muzyce i internecie. Przykładowo, ciasteczko to pojawia się w wielu filmowych scenach, często jako symbol amerykańskiego dzieciństwa lub komfortu. Ponadto, Oreo zdobyło status ikony w mediach społecznościowych, będąc bohaterem wielu popularnych memów i wideo. Jego uniwersalność i zdolność do przekraczania granic kulturowych czynią je czymś więcej niż tylko przekąską – Oreo stało się częścią globalnego języka popkultury.

Podsumowanie

Zamykając naszą fascynującą podróż przez świat ciasteczek Oreo, stajemy przed inspirującym przykładem, jak zaawansowane technologie i innowacje w produkcji żywności mogą przekształcić proste składniki w globalne fenomeny spożywcze. Ciasteczka Oreo, ze swoją wyrazistą, głęboką barwą i rozpoznawalnym smakiem, są żywym dowodem na to, jak naukowe podejście do przetwarzania żywności może zrewolucjonizować branżę.

Dla ekspertów w dziedzinie technologii żywności, historia Oreo stanowi inspirację do dalszego poszerzania granic innowacyjności. Proces alkalizacji kakao, który nadaje Oreo ich charakterystyczny kolor, oraz rozwój oreologii, pokazują, że zrozumienie naukowych aspektów produkcji żywności może prowadzić do tworzenia produktów, które odnoszą międzynarodowy sukces.

Ta historia podkreśla także znaczenie dostosowywania produktów do zróżnicowanych gustów i preferencji na całym świecie. Z ponad 100 różnymi smakami, Oreo udowadnia, że elastyczność i innowacyjność w tworzeniu produktów są kluczowe dla zdobywania globalnego uznania.

W dzisiejszym świecie, gdzie konsumenci poszukują zarówno tradycyjnych, jak i innowacyjnych doświadczeń smakowych, eksperci z dziedziny technologii żywności są nieocenionymi partnerami w odkrywaniu i implementowaniu nowych, ekscytujących rozwiązań. Od naukowego podejścia do składników, przez rozwój procesów produkcyjnych, aż po wprowadzanie na rynek innowacyjnych produktów, ich wiedza i doświadczenie są kluczowe w osiąganiu sukcesów na miarę Oreo.

Podsumowując, opowieść o Oreo to nie tylko przyciągająca uwagę opowieść o słynnym ciasteczku, ale także znakomity przykład znaczenia technologii żywności w tworzeniu nowoczesnych, udanych produktów spożywczych. Dzięki pasji i innowacyjności ekspertów w tej dziedzinie, przyszłość branży spożywczej wydaje się równie obiecująca i pełna nowych, ekscytujących możliwości, jak sama historia ciasteczka, które przekroczyło granice bycia zwykłą przekąską, stając się ikoną w kulturze masowej.

#konsultant#doradztwo#usługi konsultingowe#freelancer#produkcja spożywcza#technolog żywności#system HACCP#firma konsultingowa#certyfikacja BRC#certyfikacja IFS#żywności#znakowaniażywności#branża spożywcza#doradztwo technologia spożywcza#konsulting#produkcja żywności#technologia żywności

0 notes

Text

Wytłaczarka do tworzyw sztucznych to urządzenie używane do przetwarzania odpadów plastikowych na granulki wtórne. Jest to jedno z kluczowych urządzeń w procesie recyklingu i ponownego wykorzystywania tworzyw sztucznych. Poprzez procesy takie jak podgrzewanie, sprasowywanie i przetwarzanie, wytłaczarka może przekształcać odpady plastikowe w równomierne granulki, które mogą być wykorzystane do produkcji nowych wyrobów z tworzyw sztucznych.

Zasada działania wytłaczarki zwykle obejmuje wprowadzenie odpadów plastikowych do wnętrza maszyny. Zazwyczaj nie jest to pojedyncze urządzenie, ale raczej linia produkcyjna, która wymaga współpracy kilku maszyn. Po przejściu przez kilka etapów, takich jak rozdrabnianie, sprasowywanie i topienie, odpady piankowe ostatecznie stają się wartościowymi granulkami wtórnymi.

Te granulki wtórne mają dobre właściwości fizyczne i chemiczne i mogą być szeroko stosowane w różnych branżach, takich jak opakowania, budownictwo, motoryzacja czy artykuły gospodarstwa domowego.

Efektywne wykorzystanie wytłaczarki do tworzyw sztucznych może przyczynić się do zrównoważonego wykorzystania odpadów plastikowych, zmniejszając zapotrzebowanie na nowe surowce i tym samym zmniejszając zanieczyszczenie środowiska oraz promując zrównoważony rozwój. To także powszechny sposób na przetwarzanie odpadów piankowych, a ceny granulek wtórnych stale rosną.

0 notes

Text

Słabe przetwarzanie słuchowe w praktyce

Właśnie poszłam na spotkanie, na którym nikogo nie było. Ponieważ ono się odbędzie dopiero w środę.

Chyba zaatakowało mnie znienacka słabe przetwarzanie słuchowe i jak znajoma osoba mówiła mi, że "dziewiętnastego", to ja usłyszałam "siedemnastego". No bo przysięgam, że tak usłyszałam. I nawet pomyślałam, że data jakaś dziwna, że czemu nie w środę, tylko poniedziałek. XD

No cóż, dzisiaj ogólnie jest słaby dzień, także nie dziwi mnie ta wpadka zupełnie. Ale już siedzę w domku i nic produktywnego nie robię, chilluję się, a jutro na pewno będzie lepiej.

0 notes

Text

ChatGPTPolsku: Przyszłość Dekodowania Języka AI

Nowa Era Komunikacji

W dzisiejszym świecie cyfrowej interakcji, rozumienie języka sztucznej inteligencji (AI) staje się kluczowym elementem przyszłościowej komunikacji. Jest to obszar, który przez lata był przedmiotem intensywnych badań i rozwoju. Jako doktorant i pasjonat tego obszaru, przedstawiam światu ChatGPTPolsku - rewolucyjną platformę, która nie tylko dekoduje język AI, ale także stawia na pierwszym miejscu potrzeby użytkowników.

Aby uzyskać więcej informacji, zobacz : https://chatgptpolsku.org/

Wizja i Misja

ChatGPTPolsku to owoc wieloletnich badań i zaangażowania w rozwój technologii AI. Naszą wizją jest stworzenie środowiska, w którym komunikacja z maszynami staje się intuicyjna, naturalna i dostępna dla wszystkich. Nasza misja polega na zapewnieniu użytkownikom narzędzia, które nie tylko przetwarza język maszynowy, ale również dba o ich potrzeby, zapewniając przyjazne środowisko i bezpieczną interakcję.

Innowacyjne Rozwiązania

ChatGPTPolsku wyróżnia się innowacyjnym podejściem do dekodowania języka AI. Nasz system opiera się na zaawansowanych algorytmach, które pozwalają na szybkie i precyzyjne przetwarzanie treści. Jednak nasza platforma to nie tylko technologia - to kompleksowe rozwiązanie, które obejmuje przyjazny dla użytkownika interfejs, łatwy dostęp do informacji, szybkie reagowanie na potrzeby użytkowników oraz wysoki poziom bezpieczeństwa danych.

Przyjazność Dla Użytkownika

W centrum naszej działalności stoi użytkownik. Dlatego dbamy o to, aby nasza platforma była łatwa w obsłudze i zrozumiała dla każdego. Nasz interfejs jest intuicyjny, a funkcje łatwo dostępne. Ponadto, system szybkiego reagowania pozwala nam na natychmiastową reakcję na potrzeby użytkowników, zapewniając im kompleksową pomoc i wsparcie.

Bezpieczeństwo i Prawo

W erze cyfrowej ochrona danych jest niezwykle istotna. Dlatego też ChatGPTPolsku poświęca dużą uwagę bezpieczeństwu użytkowników. Nasz system jest oparty na najnowszych standardach bezpieczeństwa, zapewniając pełną ochronę danych użytkowników. Ponadto, dbamy o to, aby nasza platforma była zgodna z obowiązującymi przepisami prawnymi, zapewniając użytkownikom pełną pewność i bezpieczeństwo korzystania z naszych usług.

Podsumowanie

ChatGPTPolsku to nie tylko kolejna platforma dekodująca język AI. To rewolucja w sposobie komunikacji z maszynami, która stawia na pierwszym miejscu potrzeby użytkowników. Nasza innowacyjna technologia, przyjazny interfejs, szybka reakcja na potrzeby użytkowników oraz wysoki poziom bezpieczeństwa sprawiają, że jesteśmy liderem w dziedzinie komunikacji cyfrowej. Przyłącz się do nas już dziś i odkryj przyszłość komunikacji z AI!

Informacja :

Adres : Polna 8B,Bydgoszcz, Poland

Naród : Poland

Miasto : Bydgoszcz

Kod pocztowy : 85-163

Telefon : +48 691-404-165

E-mail : [email protected]/[email protected]

Moja strona internetowa : https://chatgptpolsku.org/

0 notes

Text

Gestion d'entrepôt en Europe

W dzisiejszym dynamicznym i konkurencyjnym świecie biznesu, gdzie oczekiwania klientów stale się zmieniają, a wymagania rynku stale ewoluują, płynna logistyka stała się kluczem do osiągnięcia sukcesu.

Efektywny porządek przetwarzanie, terminowe dostawy i doskonała obsługa produktu nie są już opcjonalne; są niezbędne, aby firmy mogły się wyróżniać i wyróżniać. Gestion d'entrepôt en Europe

Przenieś swoją logistykę na wyższy poziom

Odkryj nowy poziom wydajności i doskonałości dzięki naszym kluczowym funkcjom spersonalizowanym w celu optymalizacji każdego aspektu logistyki. Od kompleksowego zarządzania po gwarantowane oszczędności, strategiczne pozycjonowanie i najwyższej jakości magazynowanie – nasza oferta ma na celu zwiększenie Twojego sukcesu operacyjnego. Gestion de la logistique et des entrepôts

U podstaw naszej wyjątkowej usługi leży strong>wyjątkowy ludzki charakter, gwarantujący, że każda interakcja i każde rozwiązanie zostaną opracowane z dbałością i zaangażowaniem.

0 notes